-

数据资产管理服务

- 文档导读

- 产品介绍

- 快速入门

- 用户指南

-

API参考

- 使用前必读

- 接口简介

- 环境准备

- 接口使用方法

-

数据集

- 数据集订购接口

- 数据集发布接口

- 目录管理接口

- 数据集管理接口

- 数据集可视授权接口

-

订阅和审批接口

- 查询数据集订阅类型

- 申请订阅单个数据集

- 查询已经订阅的数据集

- 将需要订阅的数据集加入购物车

- 删除加入购物车的内容

- 查询加入购物车的内容

- 申请人员查看申请信息

- 查看具体的申请内容

- 添加审批人员信息

- 查看审批人员信息

- 删除审批人员信息

- 审批人员查看待审批或者已经审批的申请信息

- 审批人员审批申请信息

- 查询订购用户信息

- 查询用户订阅并下载成功的数据集信息

- 根据数据集ID查询用户订阅成功数据集详情信息

- 查看给定数据集的订阅情况

- 撤销未审批完成的订单

- 申请本地下载数据集

- 获取用户订阅申请状态

- 自动订阅数据集

- 查询自动订阅的数据集的下载状态

- 批量申请订阅数据集

- 数据集订阅到期续订和确认销毁

- 数据集订阅到期续订

- 重复提交校验

- 订阅付费数据集

- 根据ID订阅付费数据集

- 数据集下载接口

- 计量统计接口

- 用户信息管理接口

- 通知接口

- 标签接口

- 数据集评论接口

- 网图服务数据集查询接口

- 数据集备份恢复接口

- 数据资产账本接口

-

数据接入

- 管理软件包

- 管理采集机(运维)

- 管理采集机(用户)

-

管理采集任务

- 创建采集任务(数据准备,含机机接口)

- 创建采集任务

- 创建采集任务(控制节点,含机机接口)

- 编辑采集任务(数据节点,console页面)

- 启动采集任务(数据准备,含机机接口)

- 启动采集任务(控制节点,含机机接口)

- 启动采集任务(数据节点,console页面)

- 停止采集任务(数据准备,含机机接口)

- 停止采集任务(控制节点,含机机接口)

- 停止采集任务(数据节点console页面)

- 删除采集任务(数据准备,含机机接口)

- 删除采集任务(控制节点,含机机接口)

- 删除采集任务(数据节点,console页面)

- 连通性测试(数据准备,含机机接口)

- 连通性测试(数据准备,控制节点,含机机接口)

- 连通性测试(console,数据节点)

- 连通性测试(console,控制节点)

- 判断VPN是否打通

- 发送邮件

- 查询采集任务列表

- 采集任务发布数据集

- 查询采集任务详情

- 更新采集任务(数据节点)

- 查询采集任务状态列表

- 获取任务采集批次信息

- 获取任务批次采集信息

- 查询采集任务日志

- 删除采集文件记录

- 根据标签查询采集任务(数据准备)

- 查询采集任务状态(数据准备)

- 查询项目OBS信息(数据准备)

- 项目ID与采集任务ID关联(数据准备)

- 项目ID与采集任务ID取消关联(数据准备)

- 下载采集数据记录

- 查询kafkatopic信息

- 上传kafka证书

- 查询国家或者城市编码

- 根据协议类型获取协议类别列表

- 根据协议和采集机ID获取对应的探针包信息

- 根据采集机ID获取所有探针包信息

- 获取探针自定义参数

- 管理本地上传任务

- 数据接入备份恢复

- 采集机相关接口(机机接口)

- 订购数据服务相关接口

- 管理用户信息

- 施工数据相关接口

- 网图服务相关接口

- 数据解析

- 数据备份

- 数据恢复

- 数据准备

- 公共参数

- 修订记录

- 常见问题

- 产品术语

-

数据集服务

- 文档导读

- 产品介绍

- 快速入门

- 用户指南

-

API参考

- 使用前必读

- 接口简介

- 环境准备

- 接口使用方法

- 数据集服务订购接口

- 数据集发布接口

- 目录管理接口

- 数据集管理接口

- 数据集可视授权接口

-

订阅和审批接口

- 查询数据集订阅类型

- 申请订阅单个数据集

- 查询已经订阅的数据集

- 将需要订阅的数据集加入购物车

- 删除加入购物车的内容

- 查询加入购物车的内容

- 申请人员查看申请信息

- 查看具体的申请内容

- 添加审批人员信息

- 查看审批人员信息

- 删除审批人员信息

- 审批人员查看待审批或者已经审批的申请信息

- 审批人员审批申请信息

- 查询订购用户信息

- 查询用户订阅并下载成功的数据集信息

- 根据数据集ID查询用户订阅成功数据集详情信息

- 查看给定数据集的订阅情况

- 撤销未审批完成的订单

- 获取用户订阅申请状态

- 自动订阅数据集

- 查询自动订阅的数据集的下载状态

- 批量申请订阅数据集

- 数据集订阅到期续订和确认销毁

- 数据集订阅到期续订

- 重复提交校验

- 订阅付费数据集

- 根据ID订阅付费数据集

- 数据集下载接口

- 计量统计接口

- 用户信息管理接口

- 通知接口

- 标签接口

- 数据集评论接口

- 网图服务数据集查询接口

- 数据集服务备份恢复接口

- 数据资产账本接口

- 公共参数

- 修订记录

- 常见问题

- 产品术语

- 数据生成服务

- 模型训练服务

- 文档下载

- 通用参考

链接复制成功!

模型训练

使用特征工程处理后生成的训练集进行模型训练。

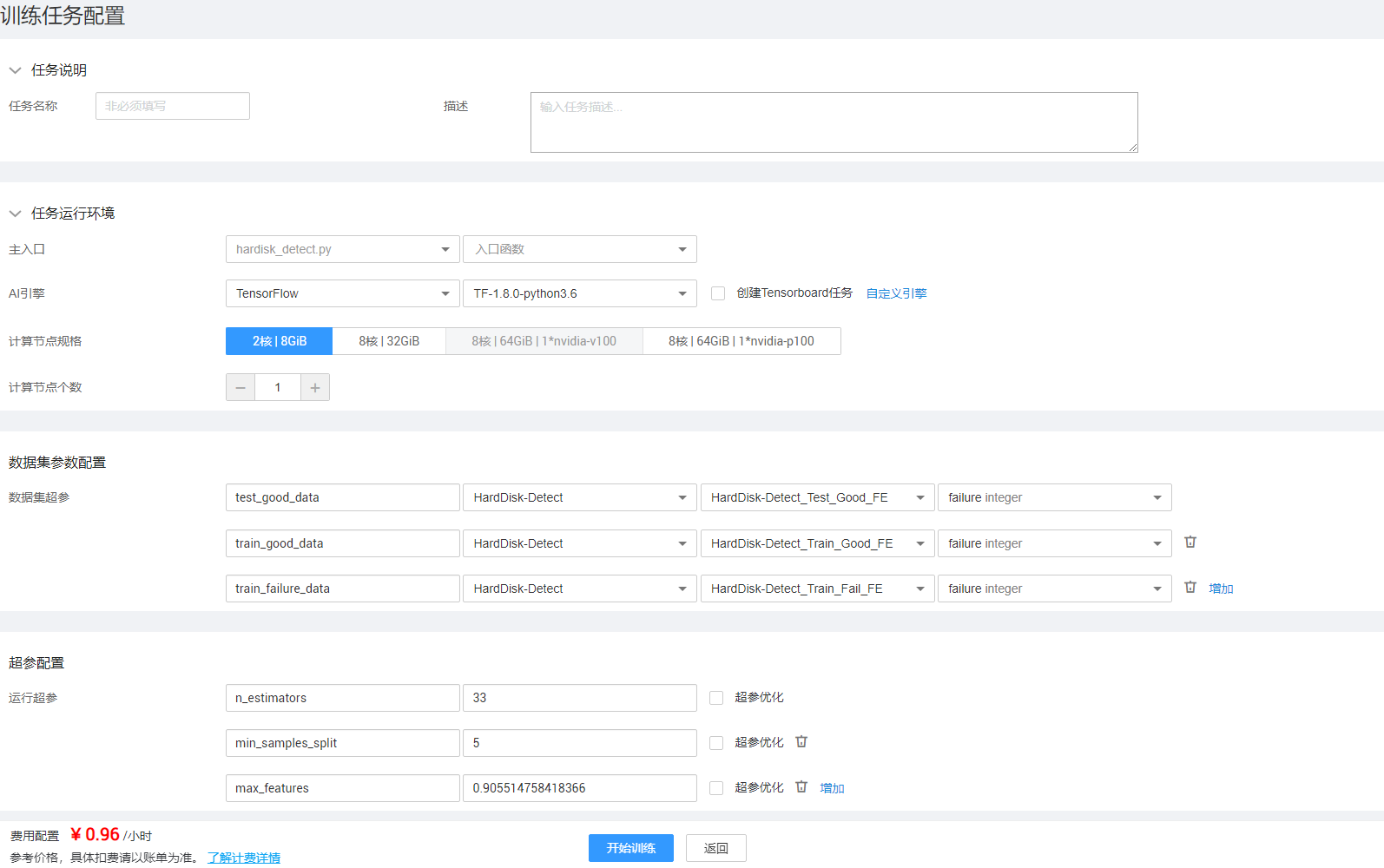

创建训练任务(简易编辑器)

- 单击简易编辑器界面右上角的“训练”,弹出“训练配置”对话框,如图1所示。

- 在“训练配置”对话框中配置参数,如表1所示。

表1 训练配置参数配置 区域

参数名称

参数描述

任务说明

任务名称

训练任务的名称。

只能以字母(A~Z a~z)开头,由字母、数字(0~9)、下划线(_)、(-)组成,不能以下划线结尾,长度范围为[1,32]。

描述

训练任务的描述信息。

任务运行环境

AI引擎

AI引擎及AI引擎的Python版本。

创建tensorboard任务

创建Tensorboard,详情请参见创建Tensorboard。

自定义引擎

通过引擎的镜像地址自定义增加引擎。

主入口

训练任务的入口文件及入口函数。

计算节点规格

模型训练服务提供的计算节点资源,包括CPU和GPU。

用户可以单击选定计算节点资源,并在“计算节点个数”中配置计算节点资源的个数。

计算节点个数

计算节点的个数。

- 1代表单节点计算

- 2代表分布式计算,开发者需要编写相应的调用代码。可使用内置的MoXing分布式训练加速框架进行训练,训练算法需要符合MoXing程序结构。可参考如下文档:https://github.com/huaweicloud/ModelArts-Lab/tree/master/docs/moxing_api_doc

数据集参数配置

数据集超参

配置数据集实例的超参。

通过调用SDK(get_hyper_param)获取数据集相关的超参,包括训练数据集实例、验证数据集实例等。数据集超参支持输入多个,可以通过“增加”和

图标,来增加或删除运行超参。

图标,来增加或删除运行超参。详细SDK说明,请在模型训练服务首页右下角的浮框中,依次单击“帮助中心 > SDK文档”查看。

超参配置

运行超参

通过调用SDK(get_hyper_param)获取运行超参,包括标签列、迭代次数等。运行超参支持输入多个,可以通过“增加”和

图标,来增加或删除运行超参。

图标,来增加或删除运行超参。详细SDK说明,请在模型训练服务首页右下角的浮框中,依次单击“帮助中心 > SDK文档”查看。

超参优化

训练任务执行的过程中可以同步进行超参优化。

勾选“运行超参”后的“超参优化”复选框,可配置运行超参的参数类型、起始值、终止值、优化方法、优化目标和终止条件。训练完成后,可以单击

查看优化报告,得到运行超参不同取值下的模型评分和试验时长。详情请参见创建超参优化服务。

查看优化报告,得到运行超参不同取值下的模型评分和试验时长。详情请参见创建超参优化服务。 - 单击“开始训练”,提交模型训练任务。

注意:

如果“训练任务状态”一直处在“RUNNING”中,模型训练服务的前台就会一直给后台发消息,查询当前训练任务的状态。即使平台访问超时,查询训练任务状态的接口还是会一直给后台发送查询消息,永不超时。直到“训练任务状态”变更为“FINISHED”、“FAILED”或“STOPPED”,接口才会停止服务状态查询操作。

- 单击

,查看训练状态。

,查看训练状态。

- ALL显示所有训练任务。

- WAITING表示训练任务准备中。

- RUNNING表示正在训练。

- FINISHED表示训练成功。

- FAILED表示训练失败。

- STOPPED表示停止训练任务。

- 单击训练任务下方的

图标,查看系统日志、运行日志、运行图和Tensorboard信息。

图标,查看系统日志、运行日志、运行图和Tensorboard信息。

- 系统日志:可以查看代码执行的具体过程。系统运行日志信息,如代码目录、日志路径、使用的SDK信息等。

- 运行日志:用户可以在代码编辑的时候自定义信息输出到运行日志中,用于查看代码执行的具体结果。例如用户信息、代码目录、执行命令等。当训练任务运行失败时,可以通过运行日志定位训练任务失败原因。

- 运行图:用户在训练工程中,调用SDK,以图表的形式显示任务执行信息。

- Tensorboard:创建训练任务时,若勾选了“创建Tensorboard任务”,训练结束后,该页签可以展示TensorFlow在运行过程中的计算图、各种指标随着时间的变化趋势以及训练中使用到的数据信息。

单击 图标,查看模型评估报告。

图标,查看模型评估报告。

- 评估指标:可以通过数值和图表方式展示各项指标的数据信息。

- 超参:展示训练集、测试集和标签列的信息。

- 任务系统参数:展示训练任务的配置参数信息。

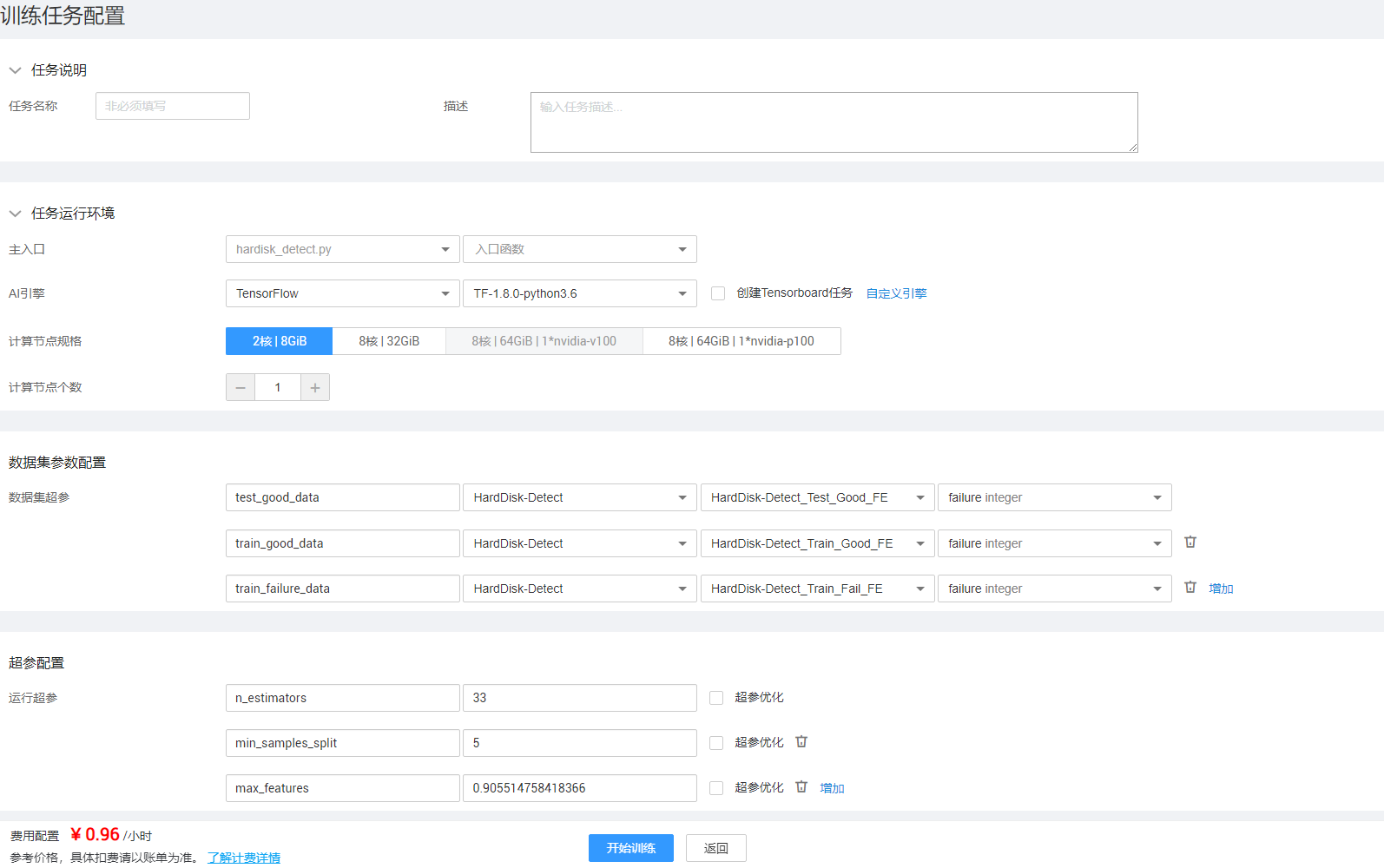

创建训练任务(WebIDE)

- 返回“模型训练”菜单界面,单击模型训练工程所在行,进入训练工程详情界面。

- 单击界面右上角的

图标,弹出“训练任务配置”对话框,如图2所示。

图标,弹出“训练任务配置”对话框,如图2所示。

- 在“训练任务配置”对话框中配置参数,如表2所示。

表2 训练配置参数配置 区域

参数名称

参数描述

任务说明

任务名称

训练任务的名称。

只能以字母(A~Z a~z)开头,由字母、数字(0~9)、下划线(_)、(-)组成,不能以下划线结尾,长度范围为[1,32]。

描述

训练任务的描述信息。

任务运行环境

AI引擎

AI引擎及AI引擎的Python版本。

创建tensorboard任务

创建Tensorboard,详情请参见创建Tensorboard。

自定义引擎

通过引擎的镜像地址自定义增加引擎。

主入口

训练任务的入口文件及入口函数。

计算节点规格

模型训练服务提供的计算节点资源,包括CPU和GPU。

用户可以单击选定计算节点资源,并在“计算节点个数”中配置计算节点资源的个数。

计算节点个数

计算节点的个数。

- 1代表单节点计算

- 2代表分布式计算,开发者需要编写相应的调用代码。可使用内置的MoXing分布式训练加速框架进行训练,训练算法需要符合MoXing程序结构。可参考如下文档:https://github.com/huaweicloud/ModelArts-Lab/tree/master/docs/moxing_api_doc

数据集参数配置

数据集超参

配置数据集实例的超参。

通过调用SDK(get_hyper_param)获取数据集相关的超参,包括训练数据集实例、验证数据集实例等。数据集超参支持输入多个,可以通过“增加”和

图标,来增加或删除运行超参。

图标,来增加或删除运行超参。详细SDK说明,请在模型训练服务首页右下角的浮框中,依次单击“帮助中心 > SDK文档”查看。

超参配置

运行超参

通过调用SDK(get_hyper_param)获取运行超参,包括标签列、迭代次数等。运行超参支持输入多个,可以通过“增加”和

图标,来增加或删除运行超参。

图标,来增加或删除运行超参。详细SDK说明,请在模型训练服务首页右下角的浮框中,依次单击“帮助中心 > SDK文档”查看。

超参优化

训练任务执行的过程中可以同步进行超参优化。

勾选“运行超参”后的“超参优化”复选框,可配置运行超参的参数类型、起始值、终止值、优化方法、优化目标和终止条件。训练完成后,可以单击

查看优化报告,得到运行超参不同取值下的模型评分和试验时长。详情请参见创建超参优化服务。

查看优化报告,得到运行超参不同取值下的模型评分和试验时长。详情请参见创建超参优化服务。 - 单击“开始训练”,训练任务开始。

- 单击界面右上角的“关闭”,返回模型训练工程详情界面。

“模型训练任务”下方展示新建的训练任务,“训练状态”列展示任务的状态。

- ALL显示所有训练任务。

- WAITING表示训练任务准备中。

- RUNNING表示正在训练。

- FINISHED表示训练成功。

- FAILED表示训练失败。

- STOPPED表示停止训练任务。

注意:

如果“训练任务状态”一直处在“RUNNING”中,模型训练服务平台的前台就会一直给后台发消息,查询当前训练任务的状态。即使平台访问超时,查询训练任务状态的接口还是会一直给后台发送查询消息,永不超时。直到“训练任务状态”变更为“FINISHED”、“FAILED”或“STOPPED”,接口才会停止服务状态查询操作。

- 单击训练任务记录对应的

图标,查看系统日志、运行日志、运行图和Tensorboard信息。

图标,查看系统日志、运行日志、运行图和Tensorboard信息。

- 系统日志:可以查看代码执行的具体过程。系统运行日志信息,如代码目录、日志路径、使用的SDK信息等。

- 运行日志:用户可以在代码编辑的时候自定义信息输出到运行日志中,用于查看代码执行的具体结果。例如用户信息、代码目录、执行命令等。当训练任务运行失败时,可以通过运行日志定位训练任务失败原因。

- 运行图:用户在训练工程中,调用SDK,以图表的形式显示任务执行信息。

- Tensorboard:创建训练任务时,若勾选了“创建Tensorboard任务”,训练结束后,该页签可以展示TensorFlow在运行过程中的计算图、各种指标随着时间的变化趋势以及训练中使用到的数据信息。

单击 图标,查看模型评估报告。

图标,查看模型评估报告。

- 评估指标:可以通过数值和图表方式展示各项指标的数据信息。

- 超参:展示训练集、测试集和标签列的信息。

- 任务系统参数:展示训练任务的配置参数信息。