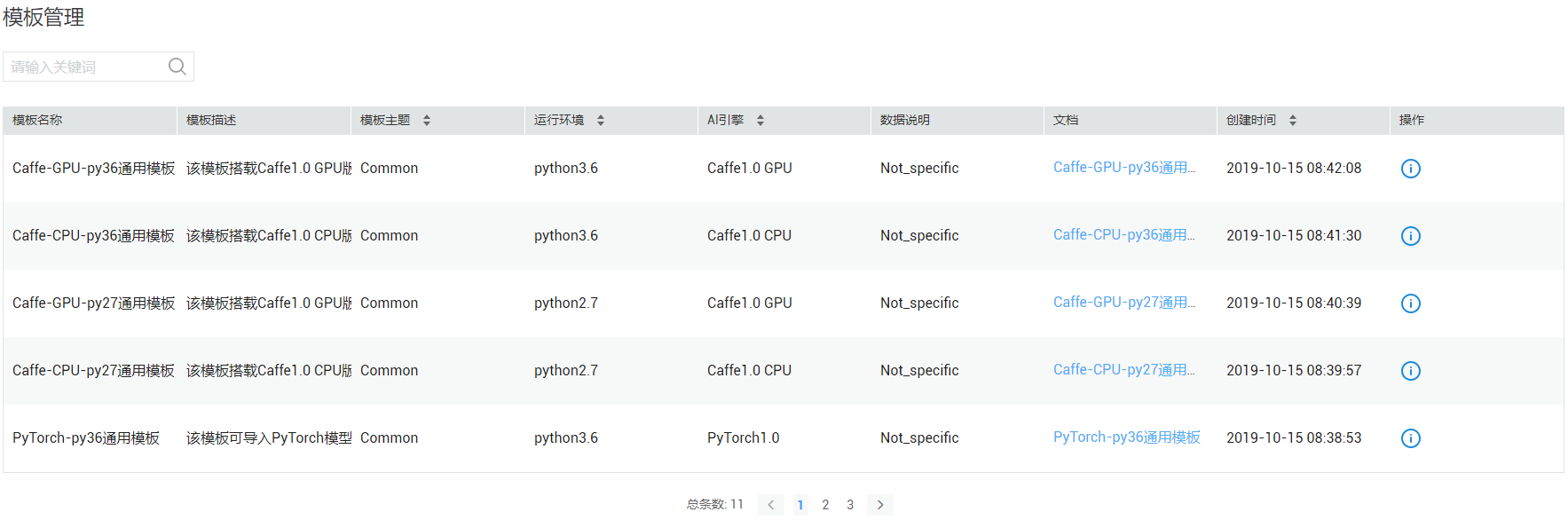

模板管理

云端推理框架新增模板能力,用户在云端推理框架发布推理服务时,可以使用系统预置的模板,将模型包发布成推理服务。

背景信息

在模型训练服务“模型管理”界面发布的推理服务,仅封装了Tensorflow类型的模型。对模型包格式上限制导致定制会比较多。或者使用特殊环境的Case难以实现,比如:KPI异常检测服务使用了很多Python的框架,且需要自定义启动的方式;有些Case还需要使用Java、Tomcat。

包括如下缺点:

- 对模型包格式有约束。虽然云端推理框架对模型训练服务发布的推理服务,进行了适配和封装,例如:预置若干必须的文件。还是对开发者增加了隐含约束,比如:流量预测服务曾遇到模型被覆盖的问题。

- 对入口文件“custom_service.py”的实现方式有约束,必须实现特定的接口,如:TensorflowService。如果推理服务不使用Tensorflow引擎,实现起来效果不理想。

- 仅支持提供一个推理服务调用接口,无法满足某些Case的需求,比如:KPI异常检测。

模板优势

使用云端推理框架的“模板管理”具备如下优势:

相对于仅能使用固定类型的模型类型TensorFlow,模板部署模型包的方式仅可以满足定制化的需求。比如:使用Java的Case;KPI异常检测Case定制启动的命令或提供多个推理服务调用接口。