准备推理环境

前提条件

- 已准备Lite Server资源,具体参考资源规格要求。推荐使用“西南-贵阳一”Region上的Lite Server和昇腾Snt9b资源。

- 安装过程需要连接互联网git clone,确保容器可以访问公网。

步骤一:检查环境

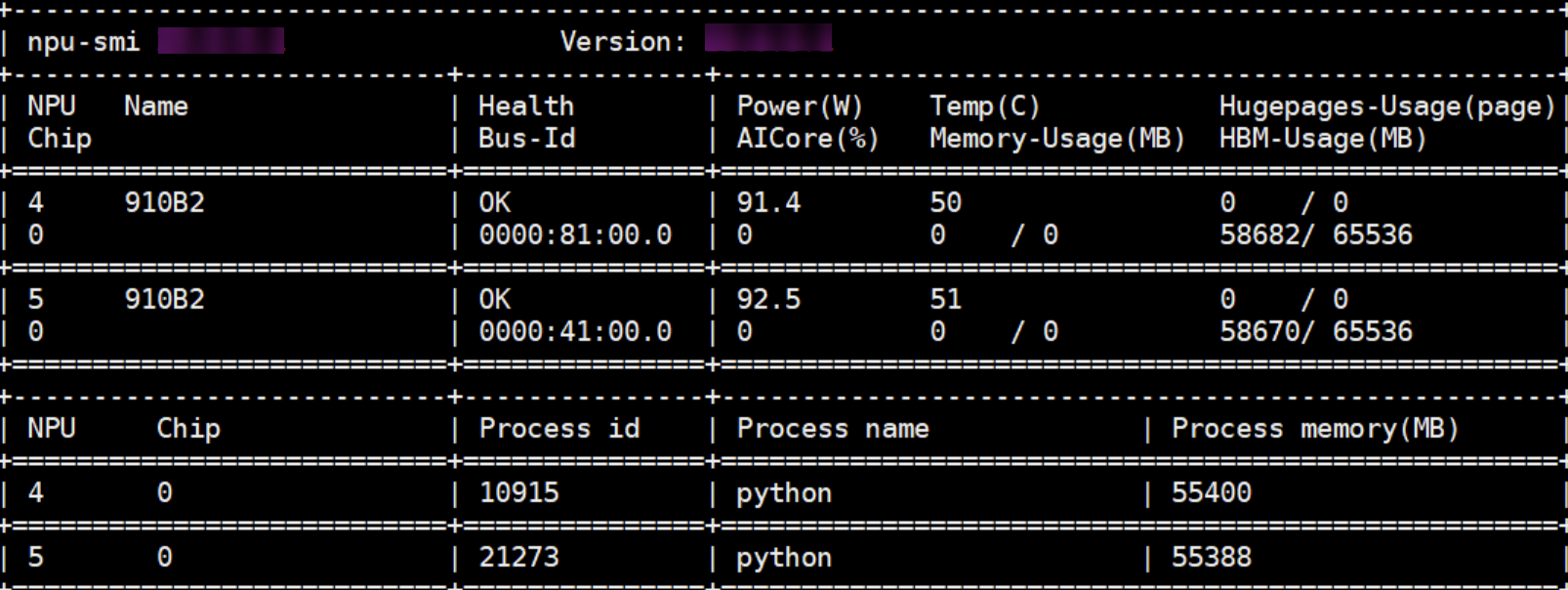

- SSH登录机器后,检查NPU设备状态。运行如下命令,返回NPU设备信息。

npu-smi info # 在每个实例节点上运行此命令可以看到NPU卡状态 npu-smi info -l | grep Total # 在每个实例节点上运行此命令可以看到总卡数,用来确认对应卡数已经挂载 npu-smi info -t board -i 1 | egrep -i "software|firmware" #查看驱动和固件版本

如出现错误,可能是机器上的NPU设备没有正常安装,或者NPU镜像被其他容器挂载。请先正常安装固件和驱动,或释放被挂载的NPU。

驱动版本要求是24.1.0.6。如果不符合要求请参考安装固件和驱动章节升级驱动。

- 检查docker是否安装。

docker -v #检查docker是否安装

如尚未安装,运行以下命令安装docker。

yum install -y docker-engine.aarch64 docker-engine-selinux.noarch docker-runc.aarch64

- 配置IP转发,用于容器内的网络访问。执行以下命令查看net.ipv4.ip_forward配置项的值,如果为1,可跳过此步骤。

sysctl -p | grep net.ipv4.ip_forward

如果net.ipv4.ip_forward配置项的值不为1,执行以下命令配置IP转发。sed -i 's/net\.ipv4\.ip_forward=0/net\.ipv4\.ip_forward=1/g' /etc/sysctl.conf sysctl -p | grep net.ipv4.ip_forward

步骤四:制作推理镜像

unzip AscendCloud-*.zip -d ./AscendCloud && cd ./AscendCloud && unzip AscendCloud-OPP-*.zip && unzip AscendCloud-OPP-*-torch-2.1.0-py310-*.zip -d ./AscendCloud-OPP && cd .. && unzip ./AscendCloud/AscendCloud-LLM-*.zip -d ./AscendCloud/AscendCloud-LLM && cd ./AscendCloud/AscendCloud-LLM/llm_inference/ascend_vllm/ && sh build_image.sh --base-image=${base_image} --image-name=${image_name}

参数说明:

- ${base_image}为基础镜像地址。

- ${image_name}为推理镜像名称,可自行指定。

运行完后,会生成推理所需镜像。

步骤五:启动容器

启动容器镜像前请先按照参数说明修改${}中的参数。docker启动失败会有对应的error提示,启动成功会有对应的docker id生成,并且不会报错。

docker run -itd \

--device=/dev/davinci0 \

--device=/dev/davinci1 \

--device=/dev/davinci2 \

--device=/dev/davinci3 \

--device=/dev/davinci4 \

--device=/dev/davinci5 \

--device=/dev/davinci6 \

--device=/dev/davinci7 \

-v /etc/localtime:/etc/localtime \

-v /usr/local/Ascend/driver:/usr/local/Ascend/driver \

-v /etc/ascend_install.info:/etc/ascend_install.info \

--device=/dev/davinci_manager \

--device=/dev/devmm_svm \

--device=/dev/hisi_hdc \

-v /var/log/npu/:/usr/slog \

-v /usr/local/sbin/npu-smi:/usr/local/sbin/npu-smi \

-v /sys/fs/cgroup:/sys/fs/cgroup:ro \

-v ${dir}:${container_work_dir} \

--net=host \

--name ${container_name} \

${image_id} \

/bin/bash

参数说明:

- --device=/dev/davinci0,..., --device=/dev/davinci7:挂载NPU设备,示例中挂载了8张卡davinci0~davinci7。

- -v ${dir}:${container_work_dir} 代表需要在容器中挂载宿主机的目录。宿主机和容器使用不同的大文件系统,dir为宿主机中文件目录,${container_work_dir}为要挂载到的容器中的目录。为方便两个地址可以相同。

- 容器不能挂载到/home/ma-user目录,此目录为ma-user用户家目录。如果容器挂载到/home/ma-user下,拉起容器时会与基础镜像冲突,导致基础镜像不可用。

- driver及npu-smi需同时挂载至容器。

- 不要将多个容器绑到同一个NPU上,会导致后续的容器无法正常使用NPU功能。

- --name ${container_name}:容器名称,进入容器时会用到,此处可以自己定义一个容器名称。

- {image_id} 为docker镜像的ID,即第四步中生成的新镜像id,在宿主机上可通过docker images查询得到。

步骤六:进入容器

- 进入容器。

docker exec -it -u ma-user ${container_name} /bin/bash - 评估推理资源。运行如下命令,返回NPU设备信息可用的卡数。

npu-smi info # 启动推理服务之前检查卡是否被占用、端口是否被占用,是否有对应运行的进程

如出现错误,可能是机器上的NPU设备没有正常安装,或者NPU镜像被其他容器挂载。请先正常安装固件和驱动,或释放被挂载的NPU。

驱动版本要求是24.1.0.6。如果不符合要求请参考安装固件和驱动章节升级驱动。启动后容器默认端口是8080。

- 配置需要使用的NPU卡为容器中的第几张卡。例如:实际使用的是容器中第1张卡,此处填写“0”。

export ASCEND_RT_VISIBLE_DEVICES=0

如果启动服务需要使用多张卡,则按容器中的卡号依次编排。例如:实际使用的是容器中第1张和第2张卡,此处填写为“0,1”,以此类推。

export ASCEND_RT_VISIBLE_DEVICES=0,1

可以通过命令npu-smi info查询NPU卡为容器中的第几张卡。例如下图查询出两张卡,如果希望使用第一和第二张卡,则“export ASCEND_RT_VISIBLE_DEVICES=0,1”,注意编号不是填4、5。图1 查询结果

启动推理服务的具体操作步骤请参见启动推理服务(大语言模型)或启动推理服务(多模态模型)。