文档首页/

AI开发平台ModelArts/

最佳实践/

DeepSeek&Qwen3基于Lite Server&Cluster推理/

Qwen3模型基于ModelArts Lite Server适配NPU的混部推理解决方案/

方案规划

更新时间:2025-09-12 GMT+08:00

方案规划

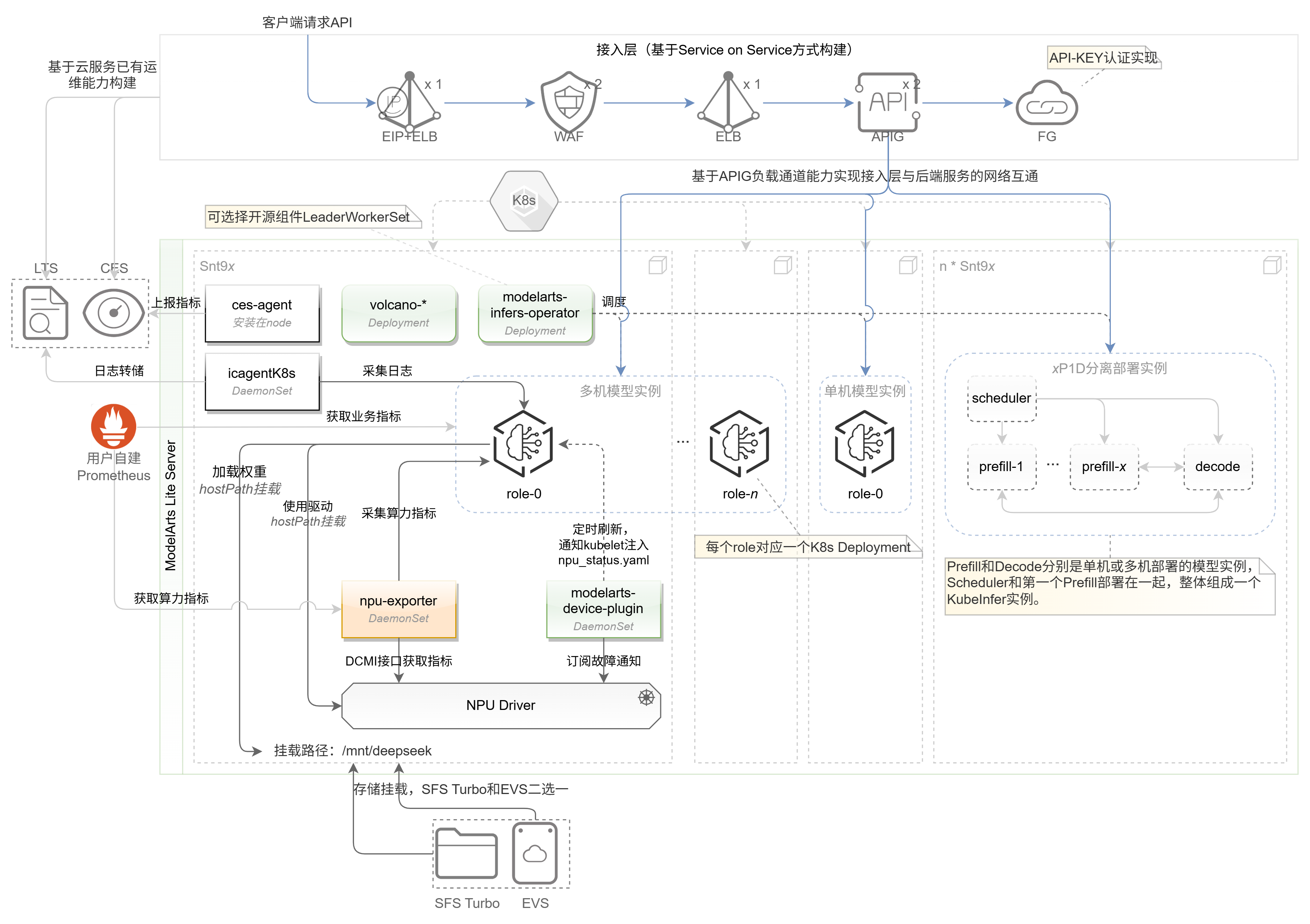

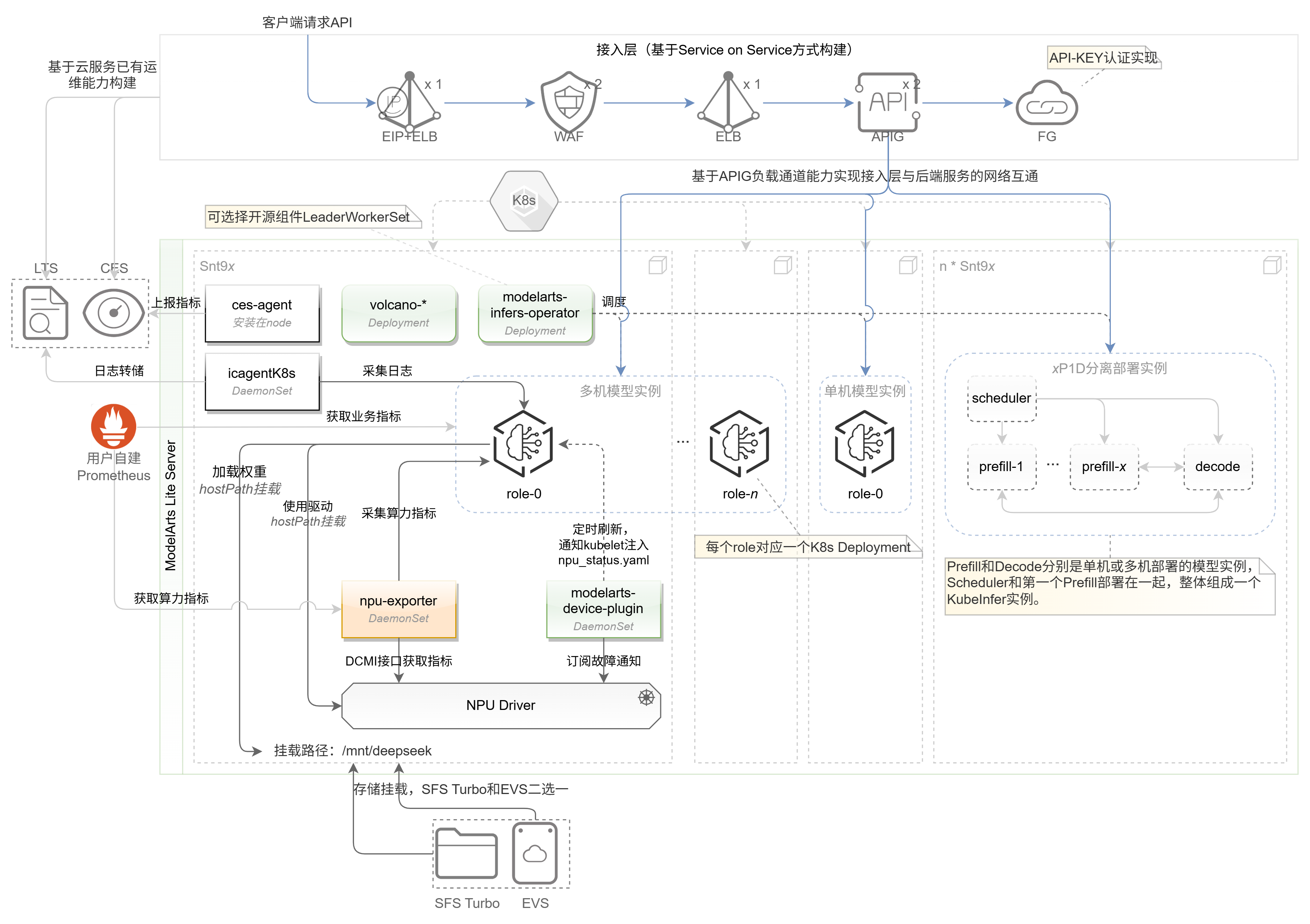

图1 架构图

本架构描述了部署开源三方大模型推理的整体方案:

- 架构整体分为接入层和推理层,其中接入层是业务请求入口,重点关注安全、流控和运维等方面;推理层是业务执行的地方,重点关注模型如何部署以及可靠性管理、运维等方面。

- 【可选】在接入层上业务请求通过EIP进入云网络,通过ELB进行流量转发,同时在网络安全上使用独享模式方式接入WAF;最后把chat API注册到APIG,并利用APIG的负载通道(服务器)能力对接K8s Service实现多实例的负载均衡。

- 【可选】接入层的监控由于各云服务已对接CES云服务,因此可使用CES云服务实现接入层各组件的监控功能,同时也支持配置监控告警。

- 【可选】接入层的依赖组件按高可靠原则,WAF和APIG实例建议至少2个。注:ELB本身是集群模式,因此单个实例并不意味着单点!

- 推理层使用Lite Server + 开源Kubernetes (K8s)作为基础设施进行模型部署。

- 在推理层利用ModelArts的KubeInfer插件(modelarts-infers-operator)和其依赖插件实现模型多实例的自动化部署。同时默认创建NodePort类型的K8s Service暴露KubeInfer实例对外访问端口。注:NodePort Service仅用于快速验证功能是否正常,正式调用从APIG入口。

- 推理层的模型权重存储使用SFS Turbo共享文件系统,并挂载至每个节点;同时对于KubeInfer实例Pod,使用hostPath方式访问挂载至节点目录的SFS Turbo目录。【可选】推理层的模型权重可使用EVS云硬盘。

- 推理层通过ModelArts的device-plugin实现NPU的监控与告警。另外CES的ces-agent组件实现节点指标(更多通用节点指标)采集并上报至CES云服务,通过CES可实现节点指标监控告警。【可选】推荐业务在K8s中部署开源Prometheus组件采集容器指标,部署开源NPU Exporter组件采集容器挂载的NPU的指标并参考自建Prometheus数据上报到AOM实现指标接入AOM服务。

- 推理框架Ascend-vLLM提供了Prometheus exporter接口,可供外部组件采集推理框架的指标信息。

- 【可选】推荐业务参考自建K8s应用日志接入LTS使用LTS的ICAgent组件将开源K8s容器、节点日志转储至LTS云服务。