文档首页/

AI开发平台ModelArts/

最佳实践/

DeepSeek&Qwen3基于Lite Server&Cluster推理/

Qwen3模型基于ModelArts Lite Server适配NPU的混部推理解决方案/

流程与约束

更新时间:2025-09-12 GMT+08:00

流程与约束

场景描述

本文档介绍了在ModelArts的Lite Server上基于Ascend-vllm推理框架部署开源三方大模型的解决方案。推理使用的算力资源是Ascend Snt9b和Snt9b23。

使用流程

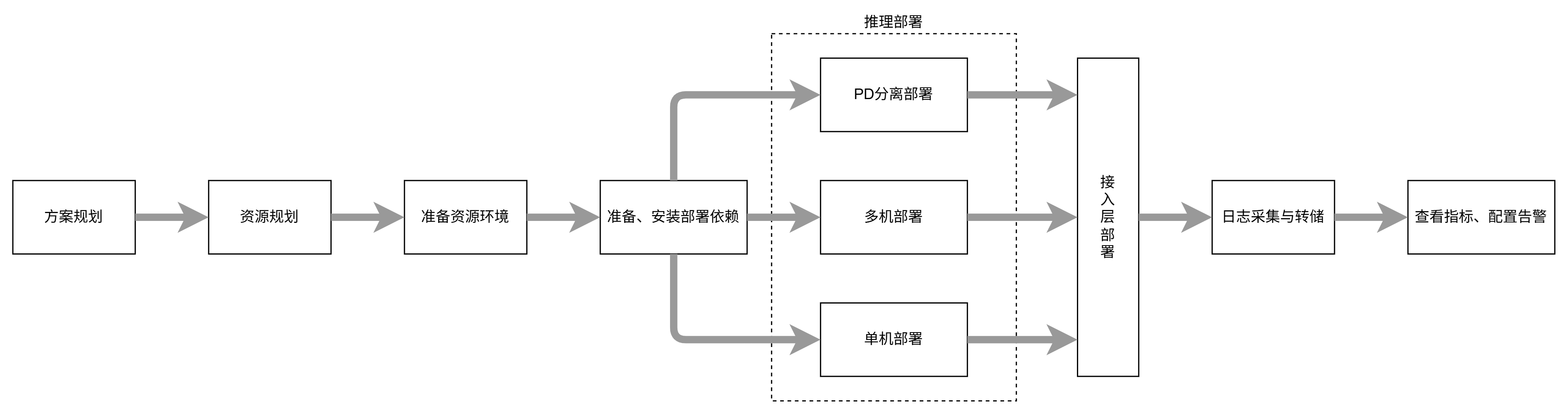

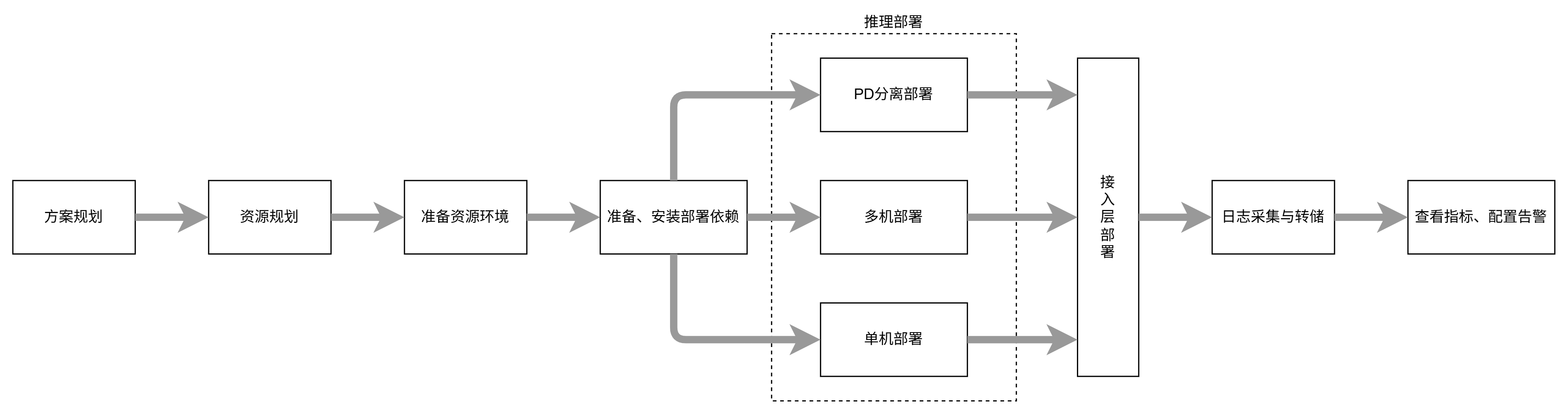

图1 使用流程

推荐您根据以下使用流程使用本解决方案部署开源三方大模型:

- 方案规划:您需要对部署的整体方案进行规划,明确部署方式、部署依赖等等。

- 资源规划:当明确整体部署方案后,需要根据整体方案规划好所需的算力资源、存储资源,以及接入层依赖资源。

- 准备资源环境:当规划好资源后就可以开始购买算力资源和存储资源,并完成相关配置。

- 准备、安装部署依赖:在正式部署开源三方大模型之前您还需要准备好部署依赖插件并安装,准备好模型权重和推理镜像。

- 推理部署:完成上述准备工作后,您将正式开始部署开源三方大模型推理,支持单机部署、多机部署和PD分离部署,您可以根据不同模型不同需求选择对应的部署方式。

- 接入层部署:完成推理部署后,开始部署接入层。此操作步骤为可选操作,但基于安全、可靠性等原则通常建议您部署。

- 日志采集与转储:当完成前面步骤后,整体的推理服务已经可以使用,基于可维护性考虑,您还需要了解当前推理服务产生的相关日志,并进行采集与转储。

- 查看指标、配置告警:为了更进一步地维护推理服务,您还需要查看相关指标并配置相应的告警。

约束限制

- 本方案基于ModelArts指定版本适配,使用前请明确版本信息,本方案适配的版本见获取推理镜像中说明。

- 本方案使用K8s管理算力资源,因此您需要对K8s的工作负载、服务等基础知识有一定的了解 ,并能熟练使用K8s的相关命令。

- 本方案使用K8s容器网络方式部署,因此您对业务的访问需要基于K8s的服务。

- 为了保障业务可靠性,必须要有热备算力资源,否则在出现业务故障时只能中断业务进行硬件维修,该过程所需时间较长。

- 为了保障业务可靠性,部署的推理实例要求必须是多副本或多实例,否则一旦出现故障将直接导致业务中断。

- 为了保障升级过程中不影响业务,需要您配置基于LoadBalancer的K8s服务,从而利用K8s的能力实现升级过程中自动摘流和升级后自动接入的能力。

- 为了实现快速部署,默认提供了相关插件和推理服务的部署参考脚本,您可以直接使用这些脚本也可以基于这些脚本进行定制化修改,本方案默认提供的参考脚本见获取部署版本包中说明。