Kafka增量抽取最佳实践

概述

Kafka增量抽取是指通过设置特定的时间范围,从Kafka中抽取指定时间段内的数据,以实现数据的周期性同步。这种策略特别适用于需要定期将Kafka中的数据同步到其他存储系统(如Hive数据湖)的场景。通过合理配置Kafka的起止时间策略和调度能力,可以高效地完成周期增量同步任务。

应用场景

常见场景包括但不限于以下几种:

- 按小时同步:每小时将Kafka中新增的数据同步到Hive数据湖。

- 按天同步:每天将Kafka中新增的数据同步到Hive数据湖。

- 更细粒度的周期同步:根据业务需求,设置更细粒度的时间间隔(如每15分钟)进行数据同步。

操作步骤

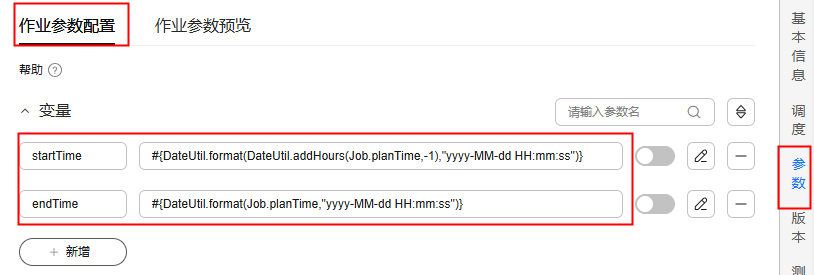

- 配置作业参数变量。

- 起始时间:startTime:#{DateUtil.format(DateUtil.addHours(Job.planTime,-1),"yyyy-MM-dd HH:mm:ss")},表示任务调度时间前一个小时。

- 结束时间:endTime:endTime:#{DateUtil.format(Job.planTime,"yyyy-MM-dd HH:mm:ss")},表示任务调度时间。

图1 配置作业参数变量

- 配置读取Kafka任务。

将“消费记录策略”设置为“起止时间”,将“起始时间”设置为变量${startTime},“结束时间”设置为变量${endTime}。

图2 配置读取Kafka任务

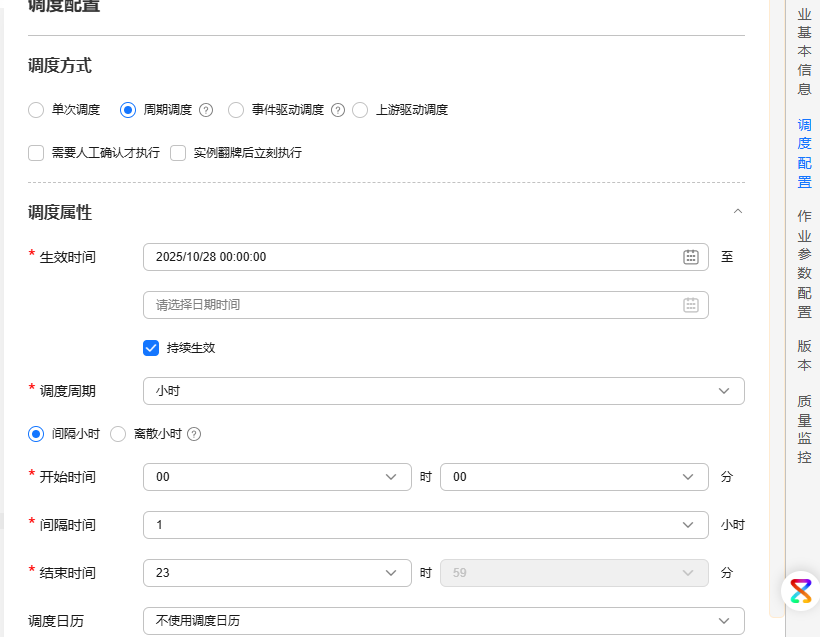

- 配置调度策略。

将任务配置调度周期为【小时】,任务将按小时调度并抽取一个小时内的Kafka消息。

图3 配置调度周期

总结

通过合理配置Kafka的起止时间策略和周期调度,可以高效地完成周期增量同步任务。这种方法特别适用于需要定期将Kafka中的数据同步到其他存储系统的场景,能够显著提高数据处理的效率和可靠性。在实际操作中,建议根据具体的业务需求和环境进行调整和优化,以达到最佳的同步效果。