Oracle同步到StarRocks作业配置(内测)

支持的源端和目的端数据库版本

|

源端数据库 |

目的端数据库 |

|---|---|

|

Oracle数据库(10、11、12、19版本) |

StarRocks(1.x、2.x) |

数据库账号权限要求

在使用Migration进行同步时,源端和目的端所使用的数据库账号需要满足以下权限要求,才能启动实时同步任务。不同类型的同步任务,需要的账号权限也不同,详细可参考下表进行赋权。

|

类型名称 |

权限要求 |

|---|---|

|

源数据库连接账号 |

Oracle 库需要开启归档日志,同时需表查询权限和日志解析权限,开通对应权限详情请参考Oracle数据源如何开通归档日志、查询权限和日志解析权限?。 |

|

目标数据库连接账号 |

目标数据库的每张表必须具有如下权限:LOAD 、SELECT、CREATE、ALTER、DROP。 |

- 建议创建单独用于Migration任务连接的数据库账号,避免因为数据库账号密码修改,导致的任务连接失败。

- 连接源和目标数据库的账号密码修改后,请同步修改管理中心对应的连接信息,避免任务连接失败后自动重试,导致数据库账号被锁定影响使用。

支持的同步对象范围

在使用Migration进行同步时,不同类型的链路,支持的同步对象范围不同,详细情况可参考下表。

|

类型名称 |

使用须知 |

|---|---|

|

同步对象范围 |

|

注意事项

除了数据源版本、连接账号权限及同步对象范围外,您还需要注意的事项请参见下表。

|

类型名称 |

使用和操作限制 |

|---|---|

|

数据库限制 |

|

|

使用限制 |

通用:

全量同步阶段:

增量同步阶段:

常见故障排查: 在任务创建、启动、全量同步、增量同步、结束等过程中,如有遇到问题,可先参考常见问题章节进行排查。 |

|

其他限制 |

|

操作步骤

本小节以Oracle到StarRocks的实时同步为示例,介绍如何配置Migration实时集成作业。配置作业前请务必阅读使用前自检概览, 确认已做好所有准备工作。

- 参见新建实时集成作业创建一个实时集成作业并进入作业配置界面。

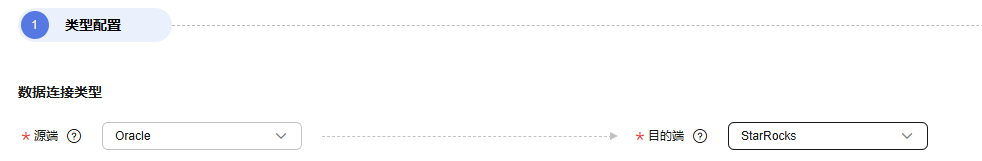

- 选择数据连接类型:源端选Oracle,目的端选StarRocks。

图1 选择数据连接类型

- 选择集成作业类型:同步类型默认为实时,同步场景包含整库场景。

图2 选择集成作业类型

- 配置网络资源:选择已创建的Oracle、StarRocks数据连接和已配置好网络连接的migration资源组。

图3 选择数据连接及migration资源组

无可选数据连接时,可单击“新建”跳转至管理中心数据连接界面,单击“创建数据连接”创建数据连接,详情请参见配置DataArts Studio数据连接参数进行配置。

无可选migration资源组时,可单击“新建”跳转至购买migration资源组页面创建migration资源组配置,详情请参见购买创建数据集成资源组增量包进行配置。

- 检测网络连通性:数据连接和migration资源组配置完成后需要测试整个迁移任务的网络连通性,可通过以下方式进行数据源和migration资源组之间的连通性测试。

- 单击展开“源端配置”触发连通性测试,会对整个迁移任务的连通性做校验。

- 单击源端和目的端数据源和migration资源组中的“测试”按钮进行检测。

- 配置源端参数。

选择需要迁移的Oracle库表。图4 选择库表

库与表均支持自定义选择,即可选择一库一表,也可选择多库多表。

- 配置目的端参数。

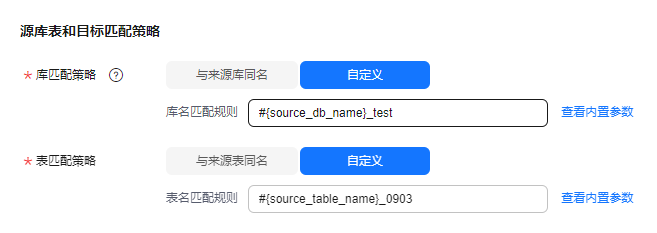

- 源库表和目标匹配策略。

- 库匹配策略。

- 与来源库同名:数据将同步至与来源Oracle库名相同的StarRocks库中。

- 自定义:数据将同步至自行指定的StarRocks库中。

- 表匹配策略。

- 与来源表同名:数据将同步至与来源Oracle表名相同的StarRocks表中。

- 自定义:数据将同步至自行指定的StarRocks表中。

图5 整库场景下源库表和目标匹配策略

自定义匹配策略时,支持用内置变量#{source_db_name}和#{source_table_name}标志来源的库名和表名,其中表匹配策略必须包含#{source_table_name}。

- 库匹配策略。

- StarRocks参数配置。

高级配置:支持通过参数配置部分高级功能,参数详情可参考下表。

表5 StarRocks高级配置一览表 参数名

参数类型

默认值

单位

配置说明

sink.batch.size

-

20000条

条

单批次写入StarRocks数据的最大条数。

sink.max-retries

-

3次

次

数据库写入失败时的最大重试次数。

sink.batch.interval

-

1

秒

每批次数据写入StarRocks的时间间隔。

sink.enable-delete

-

true

-

是否启用删除功能。

sink.batch.bytes

-

10

MB

写入、写入或更新、以及删除的最大字节数。

- 源库表和目标匹配策略。

- 刷新源表和目标表映射,检查映射关系是否正确,同时可根据需求修改表属性、添加附加字段,并通过“自动建表”能力在目的端Hudi数据库中建出相应的表。

图6 源表与目标表映射

- 附加字段编辑:单击操作列“附加字段编辑”可为目的端的StarRocks表中增加自定义字段,同时附加字段也会额外加入到StarRocks表的建表中。用户可以在已有的源表字段基础上添加多个附加字段,并自定义字段名、选择字段类型、填写字段值。

- 字段名称:目的端StarRocks表新增字段的名称。

- 字段类型:目的端StarRocks表新增字段的类型。

- 字段值:目的端StarRocks表新增字段的取值来源。

表6 附加字段取值方式 类型

示例

常量

任意字符

内置变量

- 源端host ip地址:source.host。

- 源端schema名称:source.schema。

- 源端table名称:source.table。

- 目的端schema名称:target.schema。

- 目的端table名称:target.table。

源表字段

源表中的任一字段。

配置附加字段的取值来源于源表字段时,请注意任务运行过程中不能修改对应源表字段的名称,否则可能导致作业异常。

udf方法

- substring(#col, pos[, len]): 截取源端col列的子串, 范围在[pos, pos+len)。

- date_format(#col, time_format[, src_tz, dst_tz]): 将源端col列按time_format格式化, 可选转换时区。

- now([tz]): 获取指定时区的当前时间。

- if(cond_exp, str1, str2): 满足条件表达式cond_exp时返回str1, 否则返回str2。

- concat(#col[, #str, ...]): 拼接多个参数, 可为源端列或字符串。

- from_unixtime(#col[, time_format]): 将unix时间戳按time_format格式化。

- unix_timestamp(#col[, precision, time_format]): 将时间转成unix时间戳, 可显式定义时间格式及转换后精度。

- 自动建表:单击“自动建表”可按照已配置映射规则在目的端数据库自动建表,成功后表建立方式会显示为使用已有表。

- 附加字段编辑:单击操作列“附加字段编辑”可为目的端的StarRocks表中增加自定义字段,同时附加字段也会额外加入到StarRocks表的建表中。用户可以在已有的源表字段基础上添加多个附加字段,并自定义字段名、选择字段类型、填写字段值。

- 配置任务属性。

表7 任务配置参数说明 参数

说明

默认值

执行内存

作业执行分配内存,跟随处理器核数变化而自动变化。

8GB

处理器核数

范围:2-32。

每增加1处理核数,则自动增加4G执行内存和1并发数。

2

并发数

作业执行支持并发数。该参数无需配置,跟随处理器核数变化而自动变化。

1

自动重试

作业失败时是否开启自动重试。

否

最大重试次数

“自动重试”为是时显示该参数。

1

重试间隔时间

“自动重试”为是时显示该参数。

120秒

是否写入脏数据

选择是否记录脏数据,默认不记录脏数据,当脏数据过多时,会影响同步任务的整体同步速度。

- 否:默认为否,不记录脏数据。

- 是:允许脏数据,即任务产生脏数据时不影响任务执行。

允许脏数据并设置其阈值时:

- 若产生的脏数据在阈值范围内,同步任务将忽略脏数据(即不会写入目标端),并正常执行。

- 若产生的脏数据超出阈值范围,同步任务将失败退出。

说明:

脏数据认定标准:脏数据是对业务没有意义,格式非法或者同步过程中出现问题的数据;单条数据写入目标数据源过程中发生了异常,则此条数据为脏数据。 因此只要是写入失败的数据均被归类于脏数据。

例如,源端是VARCHAR类型的数据写到INT类型的目标列中,则会因为转换不合理导致脏数据不会成功写入目的端。用户可以在同步任务配置时,配置同步过程中是否写入脏数据,配置脏数据条数(单个分片的最大错误记录数)保证任务运行,即当脏数据超过指定条数时,任务失败退出。

否

脏数据策略

“是否写入脏数据”为是时显示该参数,当前支持以下策略:

- 不归档:不对脏数据进行存储,仅记录到任务日志中。

- 归档到OBS:将脏数据存储到OBS中,并打印到任务日志中。

不归档

脏数据写入连接

“脏数据策略”选择归档到OBS时显示该参数。

脏数据要写入的连接,目前只支持写入到OBS连接。

-

脏数据目录

脏数据写入的OBS目录。

-

脏数据阈值

是否写入脏数据为是时显示该参数。

用户根据实际设置脏数据阈值。

说明:- 脏数据阈值仅针对每个并发生效。比如阈值为100,并发为3,则该作业可容忍的脏数据条数最多为300。

- 输入-1表示不限制脏数据条数。

100

添加自定义属性

支持通过自定义属性修改部分作业参数及开启部分高级功能,详情可参见任务性能调优章节。

-

- 提交并运行任务。

作业配置完毕后,单击作业开发页面左上角“提交”,完成作业提交。

图7 提交作业

提交成功后,单击作业开发页面“启动”按钮,在弹出的启动配置对话框按照实际情况配置同步位点参数,单击“确定”启动作业。

图8 启动配置

表8 启动配置参数 参数

说明

同步模式

- 增量同步:从指定时间位点开始同步增量数据。

- 全量+增量:先同步全量数据,随后实时同步增量数据。

时间

增量同步需要设置该参数,指示增量同步起始的时间位点。

说明:配置的位点时间早于CDC日志最早时间点时,默认会以日志最新时间点开始消费。

- 监控作业。

通过单击作业开发页面导航栏的“前往监控”按钮,可前往作业监控页面查看运行情况、监控日志等信息,并配置对应的告警规则,详情请参见实时集成任务运维。

图9 前往监控

性能调优

若链路同步速度过慢,可参见任务性能调优章节中对应链路文档进行排查及处理。