方案概述

方案概览

本文档利用训练框架PyTorch_npu+华为自研Ascend Snt9B或Snt9B23硬件,为用户提供了常见主流开源大模型在ModelArts Lite Cluster上的训练方案。训练框架使用的是MindSpeed-LLM(原ModelLink)。本方案目前仅适用于企业客户,完成本方案的部署,需要先联系您所在企业的华为方技术支持。

约束限制

- 本文档适配昇腾云ModelArts 6.5.905版本,请参考表1获取配套版本的软件包,请严格遵照版本配套关系使用本文档。

- 本文档中的模型运行环境是ModelArts Lite Cluster。

- 本文档中的CCE集群版本选择v1.27~1.28。版本使用的容器引擎为Containerd。

- 确保集群可以访问公网。

操作流程

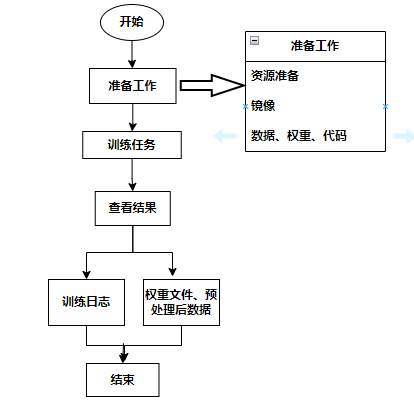

流程图

|

阶段 |

任务 |

说明 |

|---|---|---|

|

准备工作 |

本教程案例是基于ModelArts Lite k8s Cluster运行的,需要购买并开通k8s Cluster资源。 |

|

|

准备AscendFactory训练代码、分词器Tokenizer和推理代、训练数据,可以用本案使用的数据集,也可以使用自己准备的数据集。 |

||

|

准备训练模型适用的容器镜像。 |

||

|

执行训练任务(预训练/微调) |

介绍如何进行预训练,包括训练数据处理、超参配置、创建训练任务及性能查看。 |

|

|

查看训练结果 |

查看训练后的日志,训练的性能结果。 |