基于Docker单机、多机部署

步骤1:启动容器

启动容器镜像前请先按照参数说明修改${}中的参数。docker启动失败会有对应的error提示,启动成功会有对应的docker id生成,并且不会报错。

docker run -itd \

--device=/dev/davinci0 \

--device=/dev/davinci1 \

--device=/dev/davinci2 \

--device=/dev/davinci3 \

--device=/dev/davinci4 \

--device=/dev/davinci5 \

--device=/dev/davinci6 \

--device=/dev/davinci7 \

-v /etc/localtime:/etc/localtime \

-v /usr/local/Ascend/driver:/usr/local/Ascend/driver \

-v /etc/ascend_install.info:/etc/ascend_install.info \

--device=/dev/davinci_manager \

--device=/dev/devmm_svm \

--device=/dev/hisi_hdc \

-v /var/log/npu/:/usr/slog \

-v /usr/local/sbin/npu-smi:/usr/local/sbin/npu-smi \

-v /sys/fs/cgroup:/sys/fs/cgroup:ro \

-v ${dir}:${container_model_path} \

--net=host \

--name ${container_name} \

${image_id} \

/bin/bash

参数说明:

- --device=/dev/davinci0,..., --device=/dev/davinci7:挂载NPU设备,示例中挂载了8张卡davinci0~davinci7。

- -v ${dir}:${container_model_path} 代表需要在容器中挂载宿主机的目录。宿主机和容器使用不同的大文件系统,dir为宿主机中文件目录,${container_model_path}为要挂载到的容器中的目录。为方便两个地址可以相同。

- 容器不能挂载到/home/ma-user目录,此目录为ma-user用户家目录。如果容器挂载到/home/ma-user下,拉起容器时会与基础镜像冲突,导致基础镜像不可用。

- driver及npu-smi需同时挂载至容器。

- 不要将多个容器绑到同一个NPU上,会导致后续的容器无法正常使用NPU功能。

- 步骤三:上传模型权重文件中的权重路径挂载到容器路径中,后续部署推理服务的时候需要用到:${container_model_path}。

- --name ${container_name}:容器名称,进入容器时会用到,此处可以自己定义一个容器名称。

- {image_id} 为docker镜像的ID,即步骤四:制作推理镜像制作生成的新镜像id,在宿主机上可通过docker images查询得到。

步骤2:进入容器

- 进入容器。

docker exec -it -u ma-user ${container_name} /bin/bash - 配置需要使用的NPU卡为容器中的第几张卡。例如:实际使用的是容器中第1张卡,此处填写“0”。

export ASCEND_RT_VISIBLE_DEVICES=0

如果启动服务需要使用多张卡,则按容器中的卡号依次编排。例如:实际使用的是容器中第1张和第2张卡,此处填写为“0,1”,以此类推。

export ASCEND_RT_VISIBLE_DEVICES=0,1

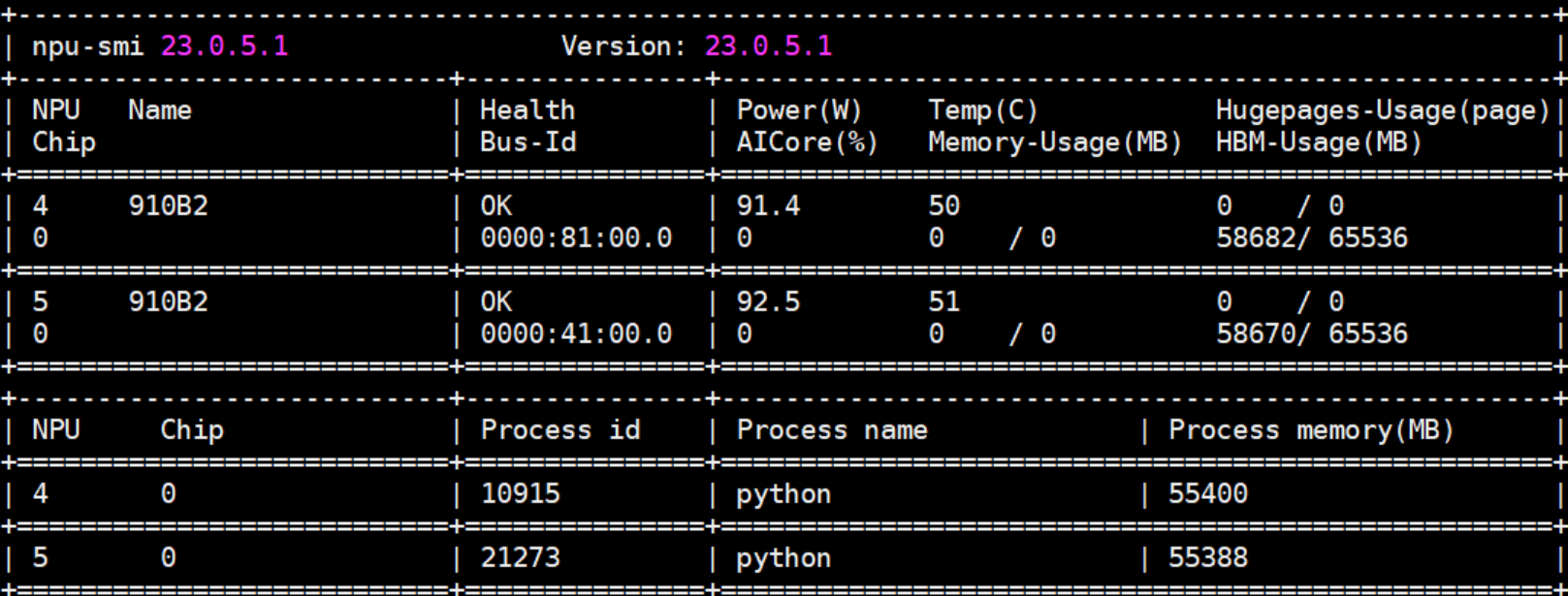

可以通过命令npu-smi info查询NPU卡为容器中的第几张卡。例如下图查询出两张卡,如果希望使用第一和第二张卡,则“export ASCEND_RT_VISIBLE_DEVICES=0,1”,注意编号不是填4、5。图1 查询结果

步骤3.1:启动离线推理

- LLM模型启动离线推理,参考vLLM Offline Batched Inference。

- 多模态模型启动离线推理,使用vllm提供的样例脚本https://github.com/vllm-project/vllm/blob/v0.7.2/examples/offline_inference/vision_language.py,也可参考ModelArts官网指导离线推理(多模态模型)。

步骤3.2:启动在线推理

详细启动服务与请求方式参考OpenAI服务API接口启动方式:https://docs.vllm.ai/en/latest/getting_started/quickstart.html。

export ASCEND_TURBO_TASK_QUEUE=0

export CPU_AFFINITY_CONF=1

export VLLM_USE_V1=0

export HCCL_OP_EXPANSION_MODE=AIV

export PYTORCH_NPU_ALLOC_CONF=expandable_segments:True

# 指定可使用的卡,按需修改。和下述--tensor-parallel-size的值要对应!

export ASCEND_RT_VISIBLE_DEVICES=0,1

# 单卡不需要添加该环境变量

export USE_MM_ALL_REDUCE_OP=1

python -m vllm.entrypoints.openai.api_server --model ${container_model_path} \

--max-num-seqs=256 \

--max-model-len=4096 \

--max-num-batched-tokens=4096 \

--tensor-parallel-size=1 \

--block-size=128 \

--host=${docker_ip} \

--port=8080 \

--gpu-memory-utilization=0.9 \

--trust-remote-code \

--enforce-eager

- --model ${container_model_path}:模型地址,模型格式是HuggingFace的目录格式。即上传的HuggingFace权重文件存放目录。如果使用了量化功能,则使用量化转换后的权重。如果使用的是训练后模型转换为HuggingFace格式的地址,还需要有Tokenizer原始文件。

- --max-num-seqs:最大同时处理的请求数,超过后在等待池等候处理。

- --max-model-len:推理时最大输入+最大输出tokens数量,输入超过该数量会直接返回。max-model-len的值必须小于config.json文件中的"seq_length"的值,否则推理预测会报错。config.json存在模型对应的路径下,例如:${container_work_dir}/config.json。不同模型推理支持的max-model-len长度不同,具体差异请参见表1。

- --max-num-batched-tokens:prefill阶段,最多会使用多少token,必须大于或等于--max-model-len,推荐使用4096或8192。

- --dtype:模型推理的数据类型。支持FP16和BF16数据类型推理。float16表示FP16,bfloat16表示BF16。如果不指定,则根据输入数据自动匹配数据类型。使用不同的dtype会影响模型精度。如果使用开源权重,建议不指定dtype,使用开源权重默认的dtype。

- --tensor-parallel-size:模型并行数。模型并行与流水线并行的乘积取值需要和启动的NPU卡数保持一致,可以参考表1。此处举例为1,表示使用单卡启动服务。

- --pipeline-parallel-size:流水线并行数。模型并行与流水线并行的乘积取值需要和启动的NPU卡数保持一致,默认为1。

- --block-size:kv-cache的block大小,推荐设置为128。

- --host=${docker_ip}:服务部署的IP,${docker_ip}替换为宿主机实际的IP地址,默认为None,举例:参数可以设置为0.0.0.0。

- --port:服务部署的端口。

- --gpu-memory-utilization:NPU使用的显存比例,复用原vLLM的入参名称,默认为0.9。

- --trust-remote-code:是否相信远程代码。

- --distributed-executor-backend:多卡推理启动后端,可选值为"ray"或者"mp",其中"ray"表示使用ray进行启动多卡推理,"mp"表示使用python多进程进行启动多卡推理。默认使用"mp"后端启动多卡推理。

- --enforce-eager:未设置INFER_MODE环境变量时,部分模型会默认使用CANNGraph图模式启动来提升性能,设置该参数后将关闭图模式。

- --disable-async-output-proc:关闭异步后处理特性,关闭后性能会下降。

多模态模型启动推理服务时跟大语言模型启动时支持的参数设置有差异:

- 多模态不支持以下参数:--num-scheduler-steps、--multi-step-stream-outputs、--disable-async-output-proc参数。

- 多模态支持limit-mm-per-prompt,详情可参考vllm官网介绍,LLM不支持设置该参数。

多机部署启动推理服务(可选)

当单机显存无法放下模型权重时,可选用多机方式部署;多机部署方式,需要机器在同一个集群,NPU卡之间IP能够ping通方可,具体步骤如下:

- 查看卡IP,在其中一个机器上执行。

for i in $(seq 0 7);do hccn_tool -i $i -ip -g;done

- 检查卡之间的网络是否通。

# 在另一个机器上执行,29.81.3.172是上一步输出的ipaddr的值 hccn_tool -i 0 -ping -g address 29.81.3.172

- 启动Ray集群。

# 指定通信网卡,使用ifconfig查看,找到和主机IP一致的网卡名 export GLOO_SOCKET_IFNAME=enp67s0f5 export TP_SOCKET_IFNAME=enp67s0f5 export RAY_EXPERIMENTAL_NOSET_ASCEND_RT_VISIBLE_DEVICES=1 # 指定可使用的卡 export ASCEND_RT_VISIBLE_DEVICES=0,1,2,3,4,5,6,7 # 将其中一个机器设为头节点 ray start --head --num-gpus=8 # 在其他机器执行 ray start --address='10.170.22.18:6379' --num-gpus=8

- --num-gpus:要跟ASCEND_RT_VISIBLE_DEVICES指定的可用卡数一致。

- --address:head节点IP+端口号,头节点创建成功后,会有打印。

- 环境变量每个节点都要设置。

- 更新环境变量需要重启Ray集群。

- 选择其中一个节点,添加指定分布式后端参数【--distributed-executor-backend=ray】,其他参数与正常启服务一致即可。