选择模型与训练方法

NLP大模型

NLP大模型主要用于处理和理解人类语言,能够实现对话问答、文案生成和阅读理解等任务,并具备逻辑推理、代码生成以及插件调用等高阶能力。

NLP大模型提供了基模型和功能模型两种类型:

- 基模型:已经在大量数据上进行了预训练,学习并理解了各种复杂特征和模式。这些模型可以作为其他任务的基础,例如阅读理解、文本生成和情感分析等。基模型本身不具备对话问答能力。

- 功能模型:在基模型的基础上进行微调,以适应特定任务。功能模型具备对话问答能力,并经过特定场景的优化,能够更好地处理文案生成、阅读理解和代码生成等任务。

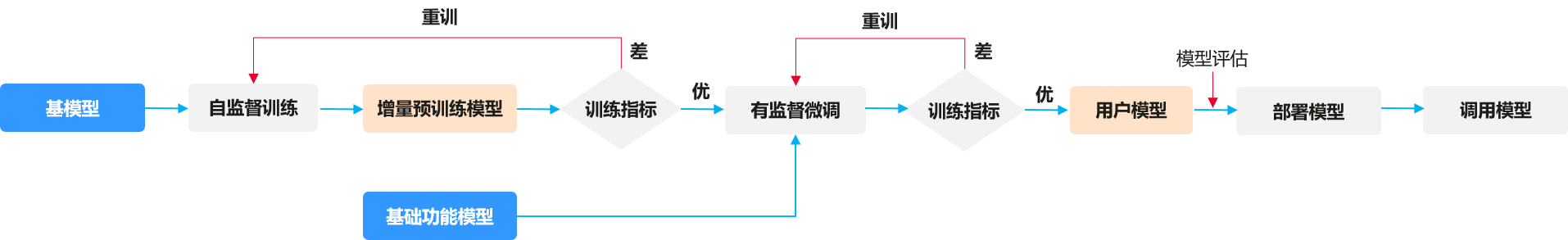

功能模型无需额外训练即可直接用于客户任务,而基模型则需要经过微调训练才能应用。NLP大模型不仅支持预训练和微调,还可以通过如下训练途径来构建满足客户需求的“用户模型”。

除基模型、功能模型这两种模型划分途径外,NLP大模型还提供了多种系列的模型,不同系列模型在能力上有所差异,可执行的训练操作也有所不同。

|

训练任务 |

N1 |

N2 |

N4 |

|---|---|---|---|

|

预训练 |

× |

× |

× |

|

微调 |

√ |

√ |

√ |

不同系列的模型,对文本长度的处理也各有差异,选择合适的模型能够处理特定长度的文本,从而提高模型的整理效果。

|

模型类别 |

模型 |

token |

简介 |

|---|---|---|---|

|

NLP大模型 |

盘古-NLP-N1-基础功能模型-32K |

部署可选4096、32768 |

基于NLP-N1-基模型训练的基础功能模型,具备文案生成、多轮对话、实体抽取、翻译、知识问答等大模型通用能力,具有32K上下文能力,可外推至128K。 |

|

盘古-NLP-N2-基础功能模型-4K |

4096 |

基于NLP-N2-基模型训练的基础功能模型,具备文案生成、多轮对话、实体抽取、翻译、知识问答等大模型通用能力。 |

|

|

盘古-NLP-N2-基础功能模型-32K |

32768 |

基于NLP-N2-基模型训练的基础功能模型,具备文案生成、多轮对话、实体抽取、翻译、知识问答等大模型通用能力。 |

|

|

盘古-NLP-N4-基础功能模型-4K |

4096 |

基于NLP-N4-基模型训练的基础功能模型,具备文案生成、多轮对话、实体抽取、翻译、知识问答等大模型通用能力,具有4K上下文能力。 |

|

|

盘古-NLP-BI专业大模型-4K |

4096 |

基于NLP-N2-基础功能模型运用特定专业代码数据训练后的BI专业大模型,具有4K上下文能力。 |

|

|

盘古-NLP-BI专业大模型-32K |

32768 |

基于NLP-N2-基础功能模型运用特定专业代码数据训练后的BI专业大模型,具有32K上下文能力。 |

|

|

盘古-NLP-N2单场景模型-4K |

4096 |

基于NLP-N2-基模型训练的单场景模型,可支持选择一个场景进行推理,如:搜索RAG方案等,具有4K上下文能力。 |

|

|

盘古-NLP-N2单场景模型-32K |

32768 |

基于NLP-N2-基模型训练的单场景模型,可支持选择一个场景进行推理,如:搜索RAG方案等,具有32K上下文能力。 |

NLP大模型训练过程中,一般使用token来描述模型可以处理的文本长度。token(令牌)是指模型处理和生成文本的基本单位。token可以是词或者字符的片段。模型的输入和输出的文本都会被转换成token,然后根据模型的概率分布进行采样或计算。不同系列模型在读取中文和英文内容时,字符长度转换为token长度的转换比如下。以N1为例,盘古模型1token≈0.75个英文单词,1token≈1.5汉字。

|

模型规格 |

token比(token/英文单词) |

token比(token/汉字) |

|---|---|---|

|

N1系列模型 |

0.75 |

1.5 |

|

N2系列模型 |

0.88 |

1.24 |

|

N3系列模型 |

0.77 |

1 |

|

N4系列模型 |

0.75 |

1.5 |