创建Kafka Topic

Topic,即消息主题,用于存储消息,供生产者生产消息以及消费者订阅消息。创建Kafka实例成功后,如果未开启“Kafka自动创建Topic”功能,则需要手动创建Topic。如果实例开启了“Kafka自动创建Topic”,则该操作为可选。

“Kafka自动创建Topic”表示向一个未创建的Topic生产或消费消息时,系统会自动创建此Topic,此Topic的默认参数值如表1所示。

集群实例支持在“实例管理 > 配置参数”中修改“log.retention.hours”(老化时间)、“default.replication.factor”(副本数)或“num.partitions”(分区数)的参数值,单机实例不支持修改配置参数。修改参数值后自动创建的Topic,Topic参数值为修改后的值。

例如:“num.partitions”修改为“5”,自动创建的Topic参数值如表1所示。

|

参数名称 |

单机实例默认值 |

集群实例默认值 |

集群实例修改后的值 |

|---|---|---|---|

|

分区数 |

1 |

3 |

5 |

|

副本数 |

1 |

3 |

3 |

|

老化时间 |

72小时 |

72小时 |

72小时 |

|

同步复制 |

不开启 |

不开启 |

不开启 |

|

同步落盘 |

不开启 |

不开启 |

不开启 |

|

消息时间戳类型 |

CreateTime |

CreateTime |

CreateTime |

|

批处理消息最大值 |

10485760字节 |

10485760字节 |

10485760字节 |

约束与限制

- Kafka单机/集群实例对Topic的总分区数设置了上限,当Topic的总分区数达到上限后,用户就无法继续创建Topic。不同规格配置的Topic总分区数不同,具体请参考Kafka实例规格。

- 2023年5月17日及以后创建的实例不提供Kafka Manager功能,不支持在Kafka Manager中创建Topic。

- 已开启密文接入的实例,“allow.everyone.if.no.acl.found”为“false”时,初始用户(即首次开启密文接入时设置的用户)可以通过客户端创建Topic,其他用户无法通过客户端创建Topic。

- Topic名称开头包含特殊字符,例如“#”号时,监控数据无法展示。

- 由于Kafka内核限制,无法区分句点和下划线,因此无法创建名称中只有句点和下划线不同的Topic。例如,已创建Topic_1,在新创建Topic.1时,报错如下:Topic 'topic.1' collides with existing topics: topic_1。

创建Kafka Topic

您可以在Kafka控制台创建Topic,也可以通过Kafka Manager或者客户端创建Topic。

- 登录Kafka控制台。

- 在管理控制台左上角单击

,选择Kafka实例所在的区域。

,选择Kafka实例所在的区域。 - 单击Kafka实例的名称,进入实例详情页面。

- 在左侧导航栏选择“实例管理 > Topic管理”,单击“创建Topic”,弹出“创建Topic”对话框。

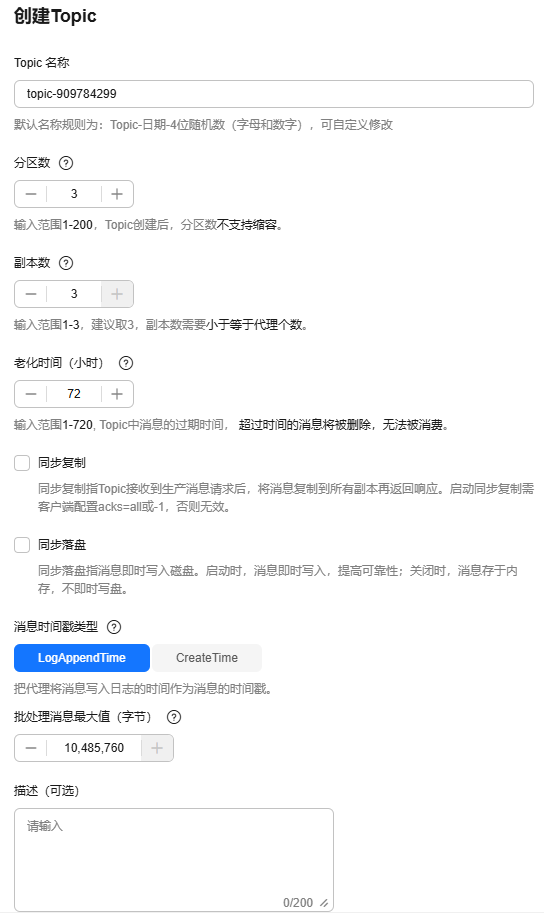

- 填写Topic名称和配置信息,单击“确定”,完成创建Topic。

图1 创建Topic(集群实例)

表2 Topic参数说明 参数

说明

Topic名称

名称支持自定义,但需要符合命名规则:以英文字母、数字、下划线开头,且只能由英文字母、数字、句点、中划线、下划线组成,长度为3~200个字符。

名称不能与以下内置Topic名称一致:

- __consumer_offsets

- __transaction_state

- __trace

- __connect-status

- __connect-configs

- __connect-offsets

- __cloud_event

- __site_event

- __dms_dial_test

- __remote_log_metadata

- __remote_log_compact_metadata

- __remote_log_metadata_offset

创建Topic后不能修改名称。

由于Kafka内核限制,无法区分句点和下划线,因此无法创建名称中只有句点和下划线不同的Topic。例如,已创建Topic_1,在新创建Topic.1时,报错如下:Topic 'topic.1' collides with existing topics: topic_1。

分区数

Topic的分区数。

如果分区数与消费者数一致,分区数越大消费的并发度越大。

该参数设置为1时,消费消息时会按照先入先出的顺序进行消费。

取值范围:1~200。

副本数

您可以为每个Topic设置副本的数量,Kafka会自动在每个副本上备份数据,当其中一个Broker故障时数据依然是可用的,副本数越大可靠性越高。更多关于副本的介绍,请参见Kafka相关概念。

该参数设置为1时,表示只有一份数据。

取值范围:1~实例的代理数量。

说明:实例节点出现故障的情况下,单副本Topic查询消息时可能会报“内部服务错误”,因此不建议使用单副本Topic。

老化时间(小时)

消息的最长保留时间,消费者必须在此时间结束前消费消息,否则消息将被删除。删除的消息,无法被消费。

取值范围:1~720。

同步复制

表示后端收到生产消息请求并复制给所有副本后,才返回客户端。

开启同步复制后,需要在生产者客户端的配置文件或者生产代码中配置acks=all或者-1,否则无效。

当副本数为1时,不能选择同步复制功能。

同步落盘

表示生产的每条消息都会立即写入磁盘,可靠性更高。关闭同步落盘后,生产的消息存在内存中,不会立即写入磁盘。

消息时间戳类型

定义消息中的时间戳类型,取值如下:

- CreateTime:生产者创建消息的时间。

- LogAppendTime:broker将消息写入日志的时间。

批处理消息最大值(字节)

Kafka允许的最大批处理大小,如果在生产客户端配置文件或代码中启用消息压缩,则表示压缩后的最大批处理大小。

如果增加“批处理消息最大值”,且存在消费者版本早于0.10.2,此时消费者的“fetch size”值也必须增加,以便消费者可以获取增加后的批处理大小。

取值范围:0~10485760。

描述

Topic的描述信息,长度为0~200个字符。

Topic创建完成后,在Topic列表页面查看新创建的Topic。

登录Kafka Manager后,在页面顶部选择“Topic > Create”,然后按照界面参数填写即可。出于性能考虑,建议单个Topic的分区数设置为200以内。

Kafka客户端版本为2.2以上时,支持通过kafka-topics.sh创建Topic,以及管理Topic的各类参数。

- 未开启密文接入的Kafka实例,在Kafka客户端的“/bin”目录下,通过以下命令创建Topic。

./kafka-topics.sh --create --topic {topic-name} --bootstrap-server {connection-address} --partitions {number-of-partitions} --replication-factor {number-of-replicas}

表3 创建Topic参数说明 参数名称

说明

topic-name

Topic名称,支持自定义。

connection-address

Kafka实例的连接地址,在Kafka控制台的“概览 > 连接信息”中获取。

number-of-partitions

Topic的分区数。

出于性能考虑,建议单个Topic的分区数设置为200以内。

number-of-replicas

Topic的副本数。

示例如下:

[root@ecs-kafka bin]# ./kafka-topics.sh --create --topic topic-01 --bootstrap-server 192.168.xx.xx:9092,192.168.xx.xx:9092,192.168.xx.xx:9092 --partitions 3 --replication-factor 3 Created topic topic-01. [root@ecs-kafka bin]#

- 已开启密文接入的Kafka实例,通过以下步骤创建Topic。

- (可选)如果已经设置了用户名和密码,以及SSL证书配置,请跳过此步骤,执行2。否则请执行以下操作。

在Kafka客户端的“/config”目录中创建“ssl-user-config.properties”文件,参考3增加用户名和密码,以及SSL证书配置。

- 在Kafka客户端的“/bin”目录下,通过以下命令创建Topic。

./kafka-topics.sh --create --topic {topic-name} --bootstrap-server {connection-address} --partitions {number-of-partitions} --replication-factor {number-of-replicas} --command-config ../config/{ssl-user-config.properties}

表4 创建Topic参数说明 参数名称

说明

topic-name

Topic名称,支持自定义。

connection-address

Kafka实例的连接地址,在Kafka控制台的“概览 > 连接信息”中获取。

number-of-partitions

Topic的分区数。

出于性能考虑,建议单个Topic的分区数设置为200以内。

number-of-replicas

Topic的副本数。

ssl-user-config.properties

配置文件的名称,此配置文件用于存放用户名和密码,以及SSL证书配置信息。

示例如下:

[root@ecs-kafka bin]# ./kafka-topics.sh --create --topic topic-01 --bootstrap-server 192.168.xx.xx:9093,192.168.xx.xx:9093,192.168.xx.xx:9093 --partitions 3 --replication-factor 3 --command-config ../config/ssl-user-config.properties Created topic topic-01. [root@ecs-kafka bin]#

- (可选)如果已经设置了用户名和密码,以及SSL证书配置,请跳过此步骤,执行2。否则请执行以下操作。

相关文档

- 如果您不想手动创建Topic,可以开启自动创建Topic功能,请参考配置Kafka自动创建Topic。

- 如果您希望通过API创建Topic,请参考Kafka实例创建Topic。