创建推理服务

在DataArtsFabric进行推理的时候,除了选择已有的公共推理服务进行推理,用户也可以部署自己的推理服务进行推理。

在DataArtsFabric部署推理服务的时候需要先有模型,您可以使用前面自己创建的模型,为了方便您操作,DataArtsFabric也默认提供了一些开源的公共模型,相关列表如下:

|

模型名称 |

简介 |

基模型类型 |

算力要求(MU) |

最大上下文长度 |

prompt模板长度 |

最大输出token |

|---|---|---|---|---|---|---|

|

Qwen 2 72B Instruct |

Qwen2在包括语言理解、生成、多语言能力、编码、数学和推理在内的多个基准测试中,超越了大多数以前的开放权重模型,与专有模型表现出竞争力。该模型参数规模为720亿。 |

QWEN_2_72B |

8 |

16k |

23 |

16360 |

|

Glm 4 9B Chat |

GLM-4-9B是智谱AI推出的最新一代预训练模型GLM-4系列中的开源版本。在语义、数学、推理、代码和知识等多方面的数据集测评中表现出较高的性能。该模型参数规模为90亿。 |

GLM_4_9B |

2 |

32k |

16 |

32751 |

Prompt模板长度为系统prompt,不管用户输入什么,系统都会将prompt模板加入到输入中。最大上下文长度包括prompt模板长度、用户最大输入token长度和最大输出token之和。

用户可以在模型导航栏下查看公共模型信息,可以使用公共模型部署推理服务,但是不允许删除公共模型。

约束与限制

部署推理服务时的通用约束限制如下:

- 推理服务资源规格最小值为1,最大值为100。

- 部署推理服务的时候选择的推理端点下的推理服务资源最大值不能超过推理端点的最大资源数。

前提条件

操作步骤

- 登录DataArtsFabric工作空间管理台。

- 选择已创建的工作空间,单击“进入工作空间”,在左侧菜单栏中选择“开发与生产->推理服务”

- 在“推理服务”页面的“我的推理服务”页签右上角,单击,进入创建页面。

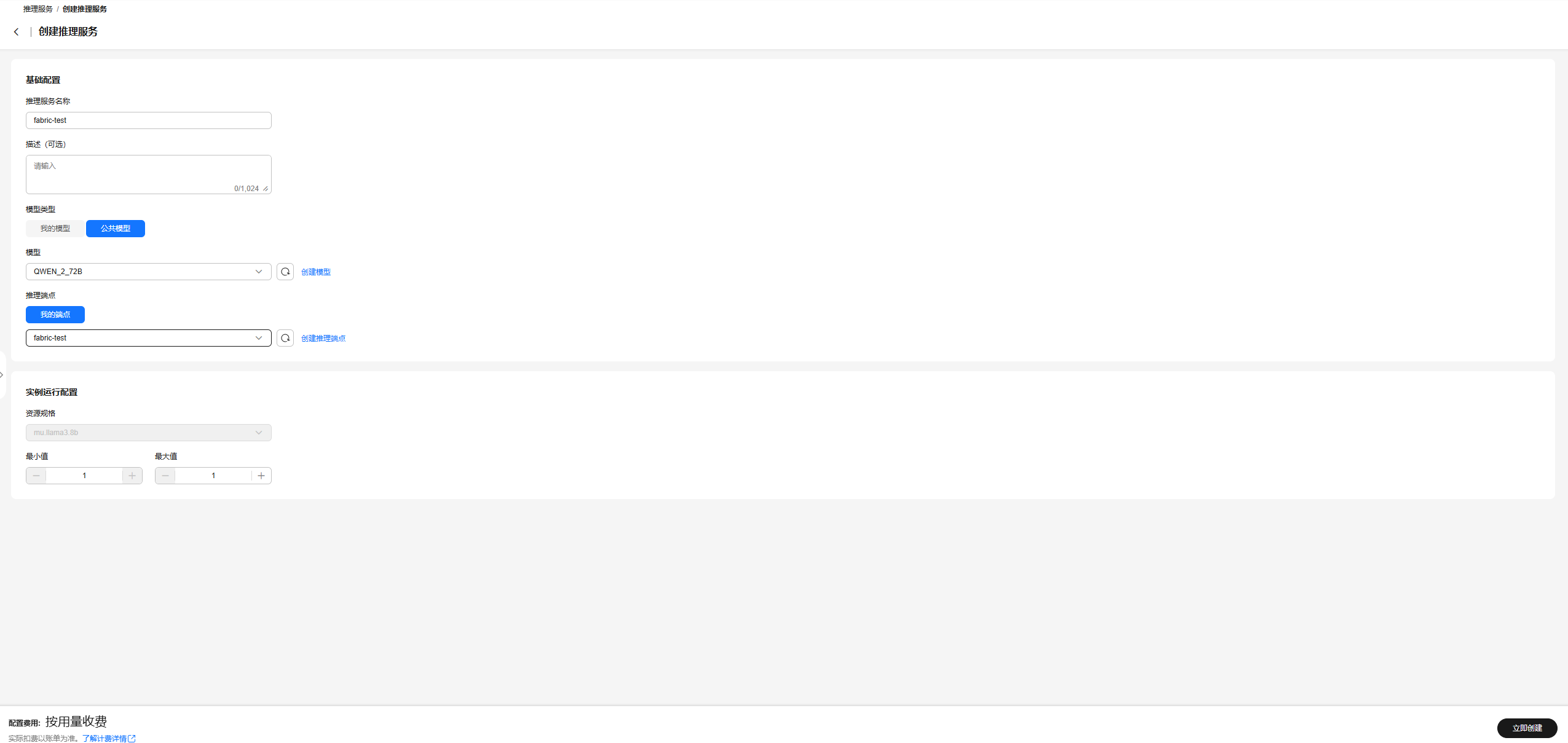

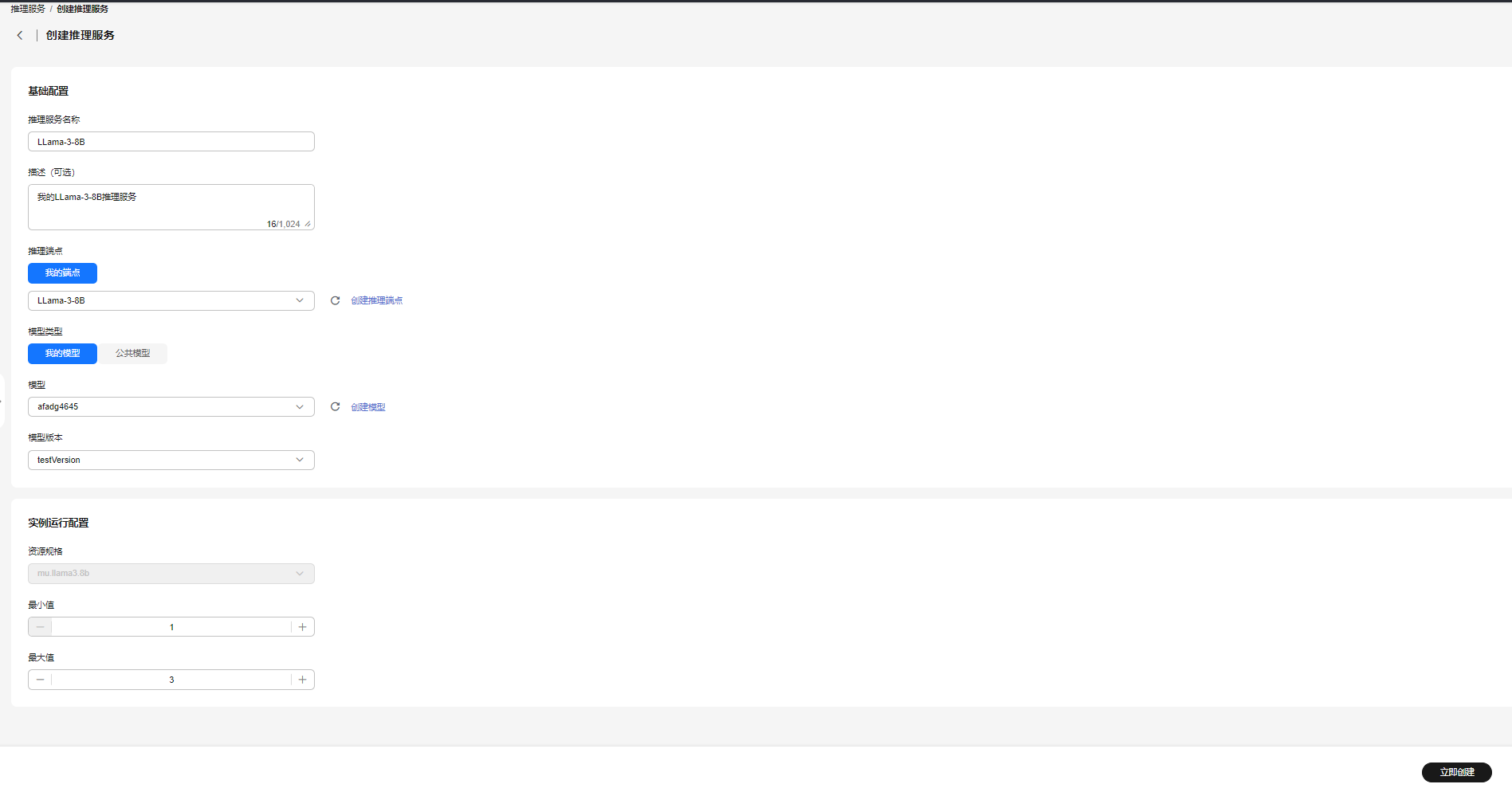

- 填写创建推理服务的名称、描述等基本信息,并选择推理端点和模型。模型可以选择公共模型或者我的模型。然后配置资源最小值和最大值。详细描述请见下表。

表2 创建推理服务参数说明 参数

是否必选

说明

基础配置

推理服务名称

是

推理服务名称。

长度为1-64,不支持重复名称。只能包含中文、字母、数字、下划线、中划线、半角句号(.)、空格。

描述

否

推理服务的描述信息。

长度为0-1024,不支持^!<>=&"'等特殊字符。

模型类型

是

支持选择“我的模型”或“公共模型”。

模型

是

- “模型类型”选择“我的模型”时,在下拉框选择用户已创建的模型。关于如何创建模型,请参见创建模型。

- “模型类型”选择“公共模型”时,在下拉框选择公共推理服务。

模型版本

是

“模型类型”选择“我的模型”时,在下拉框选择用户已创建模型的版本。

推理端点

是

在下拉框选择用户创建的推理端点。关于如何创建推理端点,请参见创建推理端点。

实例运行配置

资源规格

是

资源规格,需要与推理端点的规格保持一致,否则不支持。

最小值

是

推理服务的最小实例数,即使没有请求,也会创建最小的实例数。最小值不能小于1,最大为100。推理服务会根据不同的请求负载,在最小实例数和最大实例数之间进行自动扩缩。

最大值

是

推理服务的最大实例数。最大值不能小于1,最大值为100。同时最大值不能小于最小值,并且最大值应该小于等于所选推理端点的最大资源数。同一推理端点下的所有推理服务的最大资源数之和应该小于等于所选推理端点的最大资源数。推理服务会根据不同的请求负载,在最小实例数和最大实例数之间进行自动扩缩。请求增加后,推理服务的实例数量不会超过最大值。

图1 创建推理服务-公共模型 图2 创建推理服务-我的模型

图2 创建推理服务-我的模型

- 填写完成后,单击“立即创建”即可。

- 在“推理服务”s"页面,可查看已创建的推理服务。