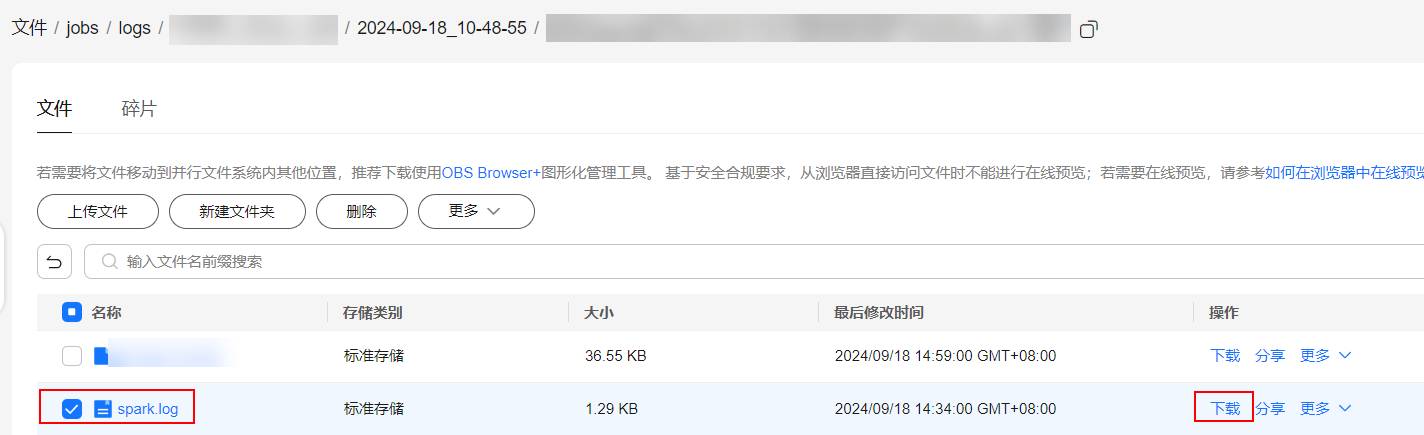

查询Spark作业日志

操作场景

DLI作业桶用于存储DLI作业运行过程中产生的临时数据,例如:作业日志、作业结果。

本节操作指导您在DLI管理控制台配置DLI作业桶,并获取Spark作业日志的操作方法。

使用须知

- 请勿将该DLI作业桶绑定的OBS桶用作其它用途,避免出现作业结果混乱等问题。

- DLI作业要由用户主账户统一设置及修改,子用户无权限。

- 不配置DLI作业桶无法查看作业日志。

- 您可以通过配置桶的生命周期规则,定时删除桶中的对象或者定时转换对象的存储类别。

- DLI的作业桶设置后请谨慎修改,否则可能会造成历史数据无法查找。

- Spark日志分割规则:

- 按大小分割:默认情况下,每个日志文件最大为128MB。

- 按时间分割:每过一小时自动创建新的日志文件。

前提条件

配置前,请先购买OBS桶或并行文件系统。大数据场景推荐使用并行文件系统,并行文件系统(Parallel File System)是对象存储服务(Object Storage Service,OBS)提供的一种经过优化的高性能文件系统,提供毫秒级别访问时延,以及TB/s级别带宽和百万级别的IOPS,能够快速处理高性能计算(HPC)工作负载。

并行文件系统的详细介绍和使用说明,请参见《并行文件系统特性指南》。

配置DLI作业桶

- 在DLI控制台左侧导航栏中单击“全局配置 > 工程配置”。

- 在“工程配置”页面,选择“DLI作业桶”,单击

配置桶信息。

图1 工程配置

配置桶信息。

图1 工程配置

- 单击

打开桶列表。

打开桶列表。 - 选择用于存放DLI作业临时数据的桶,并单击“确定”。