创建CDM与数据源之间的连接

操作场景

用户在创建数据迁移的任务前,需要先创建连接,让CDM集群能够读写数据源。一个迁移任务,需要建立两个连接,源连接和目的连接。不同的迁移方式(表或者文件迁移),哪些数据源支持导出(即作为源连接),哪些数据源支持导入(即作为目的连接),详情请参见支持的数据源。

不同类型的数据源,创建连接时的配置参数也不相同,本章节指导用户根据数据源类型创建对应的连接。

约束限制

- 当所连接的数据源发生变化(如MRS集群扩容等情况)时,您需要重新编辑并保存该连接。

- 作业运行中禁止修改密码或者更换用户。在作业运行过程中修改密码或者更换用户,密码不会立即生效且作业会运行失败。

前提条件

- 已具备CDM集群。

- CDM集群与目标数据源可以正常通信。

- 如果目标数据源为云下的数据库,则需要通过公网或者专线打通网络。通过公网互通时,需确保CDM集群已绑定EIP、CDM云上安全组出方向放通云下数据源所在的主机、数据源所在的主机可以访问公网且防火墙规则已开放连接端口。

- 如果目标数据源为云上服务(如DWS、MRS及ECS等),则网络互通需满足如下条件:

- 已获取待连接数据源的地址、用户名和密码,且该用户拥有数据导入、导出的操作权限。

新建连接

- 登录CDM管理控制台。单击左侧导航上的“集群管理”,进入集群管理界面。

或参考访问DataArts Studio实例控制台,登录DataArts Studio管理控制台。在DataArts Studio控制台首页,选择对应工作空间的“数据集成”模块,进入CDM首页。

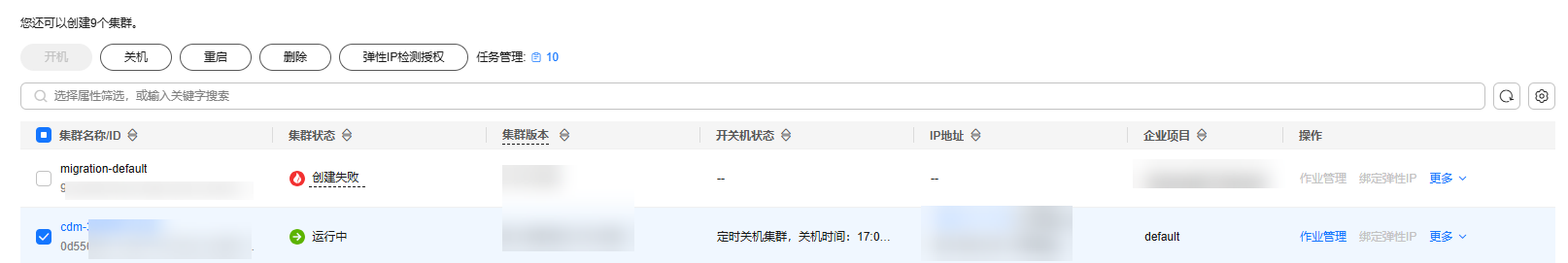

图1 集群列表

“创建来源”列仅通过DataArts Studio服务进入数据集成界面可以看到。

- 在CDM主界面,单击左侧导航上的“集群管理”,选择CDM集群后的。选择连接器类型,如图2所示。

这里的连接器类型,是根据待连接的数据源类型分类的,包含了CDM目前支持导入/导出的所有数据源类型。

- 选择数据源类型后,单击“下一步”配置连接参数,这里以创建MySQL连接为例。

每种数据源的连接参数不同,您可以根据所选择的连接器类型在表1中查找对应参数。

表1 连接参数分类 连接器类型

参数说明

- 云数据库 PostgreSQL

- 云数据库 SQL Server

- PostgreSQL

- Microsoft SQL Server

由于关系型数据库所采用的JDBC驱动相同,所以连接参数也一样,具体参数请参见PostgreSQL/SQLServer连接参数说明。

数据仓库服务(DWS)

连接数据仓库服务(DWS)时,具体参数请参见数据仓库服务(DWS)连接参数说明。

SAP HANA

连接SAP HANA时,具体参数请参见SAP HANA连接参数说明。

达梦数据库 DM

连接达梦数据库时,具体参数请参见达梦数据库 DM连接参数说明。

MySQL

连接MySQL数据库时,具体参数请参见云数据库MySQL/MySQL数据库连接参数说明。

Oracle

连接Oracle数据库时,具体参数请参见Oracle数据库连接参数说明。

分库

连接达梦数据库时,具体参数请参见分库连接参数说明。

对象存储服务(OBS)

连接OBS时,具体参数请参见OBS连接参数说明。

- MRS HDFS

- FusionInsight HDFS

- Apache HDFS

连接MRS、Apache Hadoop或FusionInsight HD上的HDFS时,具体参数请参见HDFS连接参数说明。

- MRS HBase

- FusionInsight HBase

- Apache HBase

连接MRS、Apache Hadoop或FusionInsight HD上的HBase时,具体参数请参见HBase连接参数说明。

- MRS Hive

- FusionInsight Hive

- Apache Hive

连接MRS、Apache Hadoop或FusionInsight HD上的Hive时,具体参数请参见Hive连接参数说明。

表格存储服务(CloudTable)

连接CloudTable时,具体参数请参见CloudTable连接参数说明。

- FTP

- SFTP

连接FTP或SFTP服务器时,具体参数请参见FTP/SFTP连接参数说明。

HTTP

用于读取一个公网HTTP/HTTPS URL的文件,包括第三方对象存储的公共读取场景和网盘场景。

当前创建HTTP连接时,只需要配置连接名称,具体URL在创建作业时配置。

MongoDB

连接本地MongoDB数据库时,具体参数请参见MongoDB连接参数说明。

文档数据库服务(DDS)

连接DDS时,具体参数请参见DDS连接参数说明。

- Redis

- 分布式缓存服务(DCS)

连接Redis或DCS时,具体参数请参见Redis连接参数说明。

- MRS Kafka

- Apache Kafka

连接MRS Kafka或Apache Kafka数据源时,具体参数请参见Kafka连接参数说明。

数据接入服务(DIS)

连接DIS时,具体参数请参见DIS连接参数说明。

云搜索服务

Elasticsearch

连接云搜索服务或Elasticsearch时,具体参数请参见云搜索服务(CSS)连接参数说明。

数据湖探索(DLI)

连接数据湖探索服务时,具体参数请参见DLI连接参数说明。

DMS Kafka

连接DMS的Kafka队列时,具体参数请参见DMS Kafka连接参数说明。

Cassandra

连接Cassandra时,具体参数请参见Cassandra连接参数说明。

说明:2.9.3.300以上版本不支持Cassandra。

MRS Hudi

连接MRS Hudi时,具体参数请参见MRS Hudi连接参数说明。

MRS ClickHouse

连接MRS ClickHouse时,具体参数请参见MRS ClickHouse连接参数说明。

LogHub(SLS)

连接LogHub(SLS)时,具体参数请参见LogHub(SLS)连接参数说明。

神通数据库(ST)

连接神通数据库(ST)时,具体参数请参见神通(ST)连接参数说明。

目前以下数据源处于公测阶段:FusionInsight HDFS、FusionInsight HBase、FusionInsight Hive、SAP HANA、文档数据库服务(DDS)、表格存储服务(CloudTable)、Cassandra、DMS Kafka、云搜索服务、分库、神通数据库(ST)。

- 连接的参数配置完成后单击“测试”,可测试连接是否可用。或者直接单击“保存”,保存时也会先检查连接是否可用。

受网络和数据源的影响,部分连接测试的时间可能需要30~60秒。

管理连接

- 删除:支持删除未被任何作业使用的连接,也支持批量删除连接。

- 编辑:支持修改已创建好的连接参数,但不支持重新选择连接器。修改连接时,需要重新输入数据源的登录密码。

- 测试连通性:支持直接测试已保存连接的连通性。

- 查看连接JSON:以JSON文件格式查看连接参数的配置。

- 编辑连接JSON:以直接修改JSON文件的方式,修改连接参数。

- 查看后端连接:查看该连接对应的后端连接。例如已开启后端连接,就可以查询到对应的后端连接详情。

在管理连接前,您需要确保该连接未被任何作业使用,避免影响现有作业运行。管理连接的操作流程如下:

- 进入CDM主界面,单击左侧导航上的“集群管理”,选择CDM集群后的。

- 在连接管理界面找到需要修改的连接:

- 删除连接:单击操作列的“删除”删除该连接,或者勾选连接后单击列表上方的“删除连接”来批量删除未被任何作业使用的连接。

- 编辑连接:单击该连接名称,或者单击操作列的“编辑”进入修改连接的界面,修改连接时需要重新输入数据源的登录密码。

- 测试连通性:单击操作列的“测试连通性”,直接测试已保存连接的连通性。

- 查看连接JSON:选择操作列的,以JSON文件格式查看连接参数的配置。

- 编辑连接JSON:选择操作列的,以直接修改JSON文件的方式,修改连接参数。

- 查看后端连接:选择操作列的,查看该连接对应的后端连接。