日志中心FAQ

索引

- 如何关闭日志中心?

- 插件中除log-operator外组件均未就绪

- log-operator标准输出报错

- 节点容器运行时为docker时采集不到容器文件日志

- 日志无法上报,otel组件标准输出报错:log's quota has full

- 采集容器内日志,且采集目录配置了通配符,日志无法采集

- fluent-bit容器组一直重启

- 节点OS为Ubuntu 18.04时出现日志无法采集

- 采集Job日志时出现日志无法采集

- 云原生日志采集插件运行正常,部分日志策略未生效

- log-agent-otel-collector组件出现OOM

- 节点负载过多,采集日志时缺少部分Pod信息

- 如何修改集群日志中心的日志存储时间?

- 如何修复日志采集策略中日志组(流)不存在的问题?

- Pod调度到CCI后,采集不到日志

- Turbo集群新创建节点场景出现FailedAssignENI告警

如何关闭日志中心?

关闭容器日志、kubernetes事件采集

方法一:进入“日志中心”,单击右上角“日志采集策略”,找到对应的日志策略,单击“更多 > 删除”。其中default-event为默认上报kubernetes事件,default-stdout为默认上报标准输出。

方法二:进入“插件中心”,卸载CCE 云原生日志采集插件,注意:卸载后插件将不再上报kubernetes事件到AOM。

关闭控制面组件日志采集

进入“日志中心 > 控制面组件日志”,单击“配置控制面组件日志”,取消勾选不需要采集的组件。

关闭Kubernetes审计日志采集

进入“日志中心 > Kubernetes审计日志”,单击“配置控制面审计日志”,取消勾选不需要采集的组件。

插件中除log-operator外组件均未就绪

问题现象:插件中除log-operator外组件均未就绪,且出现异常事件“实例挂卷失败”。

解决方案:请查看log-operator日志,安装插件时,其余组件所需的配置文件需要log-operator生成,log-operator生成配置出错,会导致所有组件无法正常启动。

日志信息如下:

MountVolume.SetUp failed for volume "otel-collector-config-vol":configmap "log-agent-otel-collector-config" not found

log-operator标准输出报错

问题现象:

2023/05/05 12:17:20.799 [E] call 3 times failed, reason: create group failed, projectID: xxx, groupName: k8s-log-xxx, err: create groups status code: 400, response: {"error_code":"LTS.0104","error_msg":"Failed to create log group, the number of log groups exceeds the quota"}, url: https://lts.cn-north-4.myhuaweicloud.com/v2/xxx/groups, process will retry after 45s

解决方案:LTS日志组有配额限制,如果出现该报错,请前往LTS下删除部分无用的日志组。限制详情见:日志组。

节点容器运行时为docker时采集不到容器文件日志

问题现象:

配置了容器文件路径采集,采集的目录不是挂载到容器内的,且节点容器运行时为docker,采集不到日志。

解决方案:

请检查工作负载所在节点的容器存储模式是否为Device Mapper,Device Mapper不支持采集容器内日志(创建日志策略时已提示此限制)。检查方法如下:

- 进入业务工作负载所在节点。

- 执行docker info | grep "Storage Driver"。

- 若返回的Storage Driver值为Device Mapper,则该日志无法采集。

日志无法上报,otel组件标准输出报错:log's quota has full

解决方案:

云日志服务(LTS)有免费赠送的额度,超出后将收费,报错说明免费额度已用完,如果需要继续使用,请前往LTS控制台“配置中心”,打开“超额继续采集日志”开关。

采集容器内日志,且采集目录配置了通配符,日志无法采集

排查方法:请检查工作负载配置中Volume挂载情况,如果业务容器的数据目录是通过数据卷(Volume)挂载的,插件不支持采集它的父目录,需设置采集目录为完整的数据目录。例如/var/log/service目录是数据卷挂载的路径,则设置采集目录为/var/log或/var/log/*将采集不到该目录下的日志,需设置采集目录为/var/log/service。

解决方案:若日志生成目录为/application/logs/{应用名}/*.log,建议工作负载挂载Volume时,直接挂载/application/logs,日志策略中配置采集路径为/application/logs/*/*.log

fluent-bit容器组一直重启

排查方法:节点上fluent-bit容器组一直重启,且通过kubectl describe pod命令查看Pod重启原因为OOM。查询该fluent-bit所在节点存在大量被驱逐的Pod,资源被占用导致出现OOM。

解决方案:删除节点上被驱逐的Pod。

节点OS为Ubuntu 18.04时出现日志无法采集

排查方法:重启当前节点的fluent-bit pod,查看日志是否正常采集。如依然无法采集,请确认需要采集的文件是否为打包镜像时已经存在于镜像中的日志文件。对于容器日志采集的场景来说,镜像打包时已存在的文件的日志非运行日志,属于无效日志无法采集。该问题为社区已知问题,详情请参见开源issue。

解决方案:若需要采集打包镜像时已经存在于镜像中的日志文件,建议添加在创建工作负载时,设置“生命周期>启动后命令”,在工作负载Pod启动前,先删除原来日志文件,使日志文件重新生成。

云原生日志采集插件运行正常,部分日志策略未生效

解决方案:

- 若未生效的日志策略采集类型为事件类型或插件版本低于1.5.0,则检查log-agent-otel-collector工作负载的标准输出。

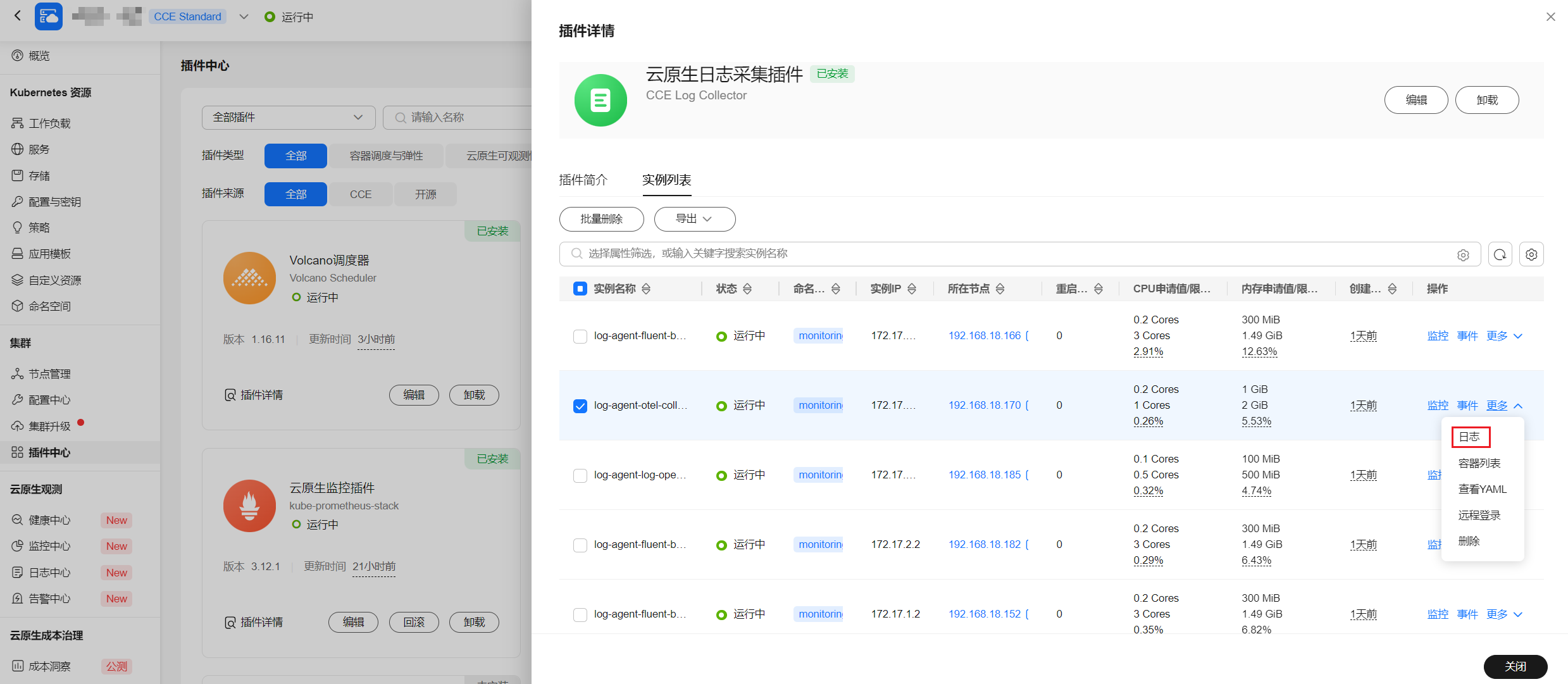

进入“插件中心”,单击 “云原生日志采集插件”名称,选择实例列表, 找到 log-agent-otel-collector ,单击“更多>日志”。

图7 查看log-agent-otel-collector实例日志

- 若未生效的日志策略类型不为事件类型,且插件版本高于1.5.0,则检查需要采集的容器所在节点的log-agent-fluent-bit实例日志。

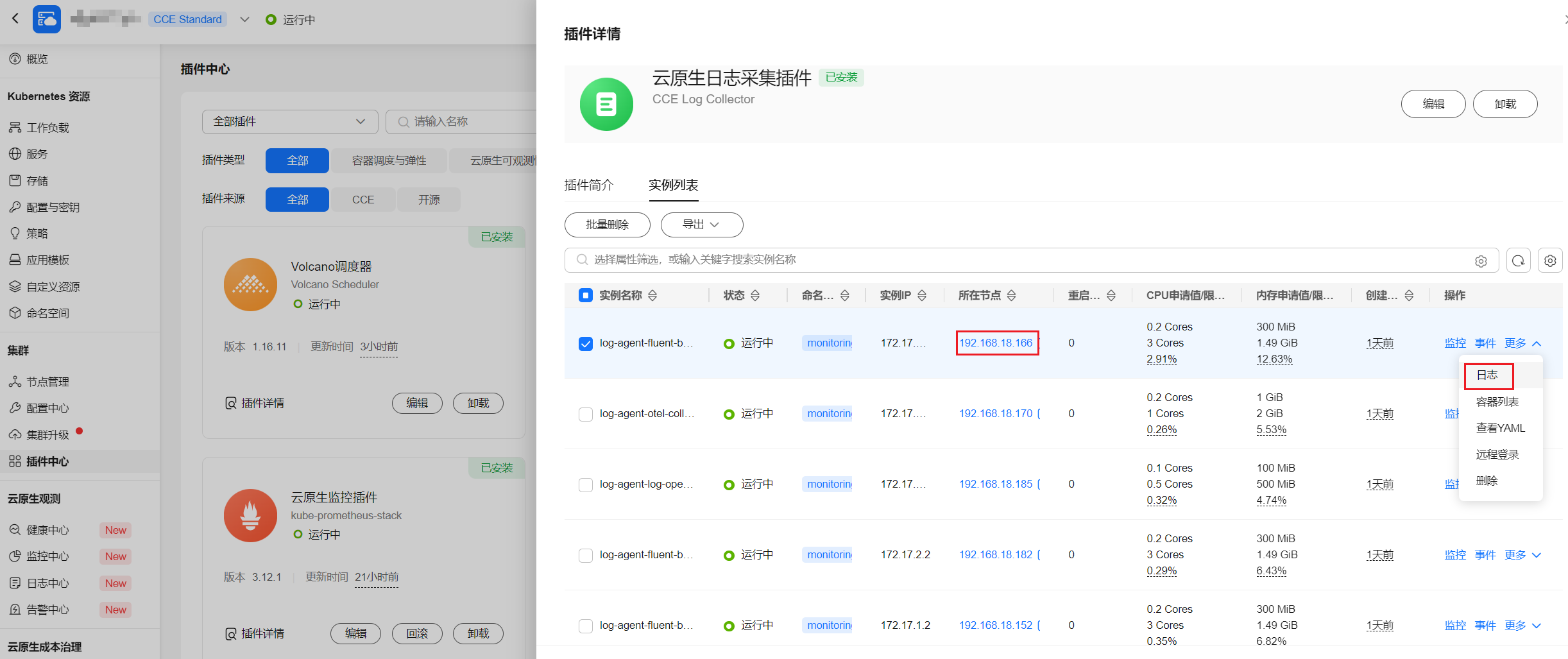

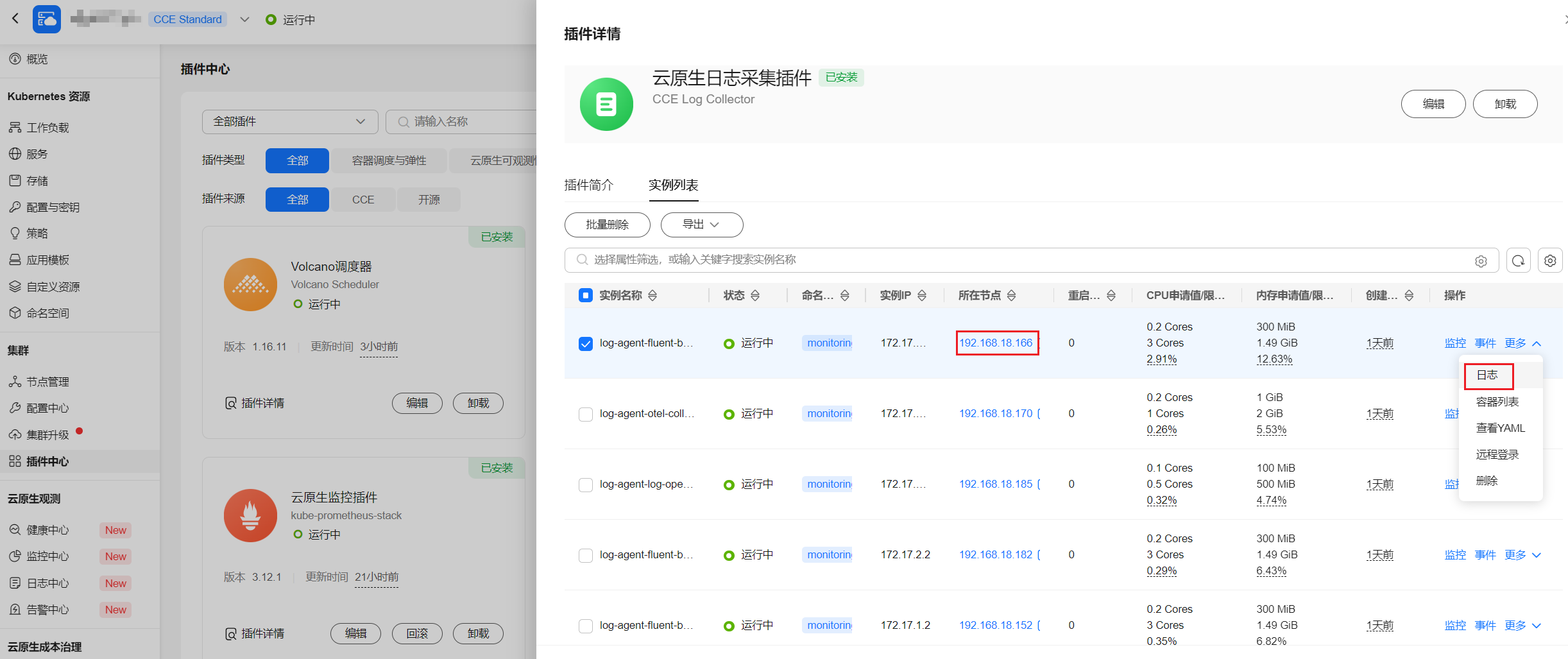

进入“插件中心”,单击“云原生日志采集插件”,选择实例列表,找到对应节点的log-agent-fluent-bit,单击“更多>日志”。

图8 查看log-agent-fluent-bit实例日志

容器选择fluent-bit,并在日志中查看关键字“fail to push {event/log} data via lts exporter”,查看后面的errorMessage。

图9 查看fluent-bit容器日志

- 若报错为“The log streamId does not exist.”,则日志组或日志流不存在,可前往“日志中心>日志采集策略”中,通过“编辑”或“删除”重建日志策略,更新策略中的日志组日志流。

- 其余报错可前往LTS搜索错误码,查看报错原因。详情请参见LTS错误码。

log-agent-otel-collector组件出现OOM

排查方法:

- 查看log-agent-otel-collector组件标准输出,查看近期是否有错误日志。

kubectl logs -n monitoring log-agent-otel-collector-xxx

若存在报错请优先处理报错,确认日志恢复正常采集。

- 若日志近期没有报错,且仍然出现OOM,则参考以下步骤进行处理:

节点负载过多,采集日志时缺少部分Pod信息

问题:插件版本在1.5.0以上,采集容器内日志或容器标准输出过程中出现日志缺少部分Pod信息,例如podID、podName等。

排查方法:

进入“插件中心”,单击“云原生日志采集插件”,选择实例列表,找到对应节点的log-agent-fluent-bit,单击“更多>日志”。

容器选择fluent-bit,并在日志中查看关键字“cannot increase buffer: current=512000 requested=*** max=512000”。

解决方案:

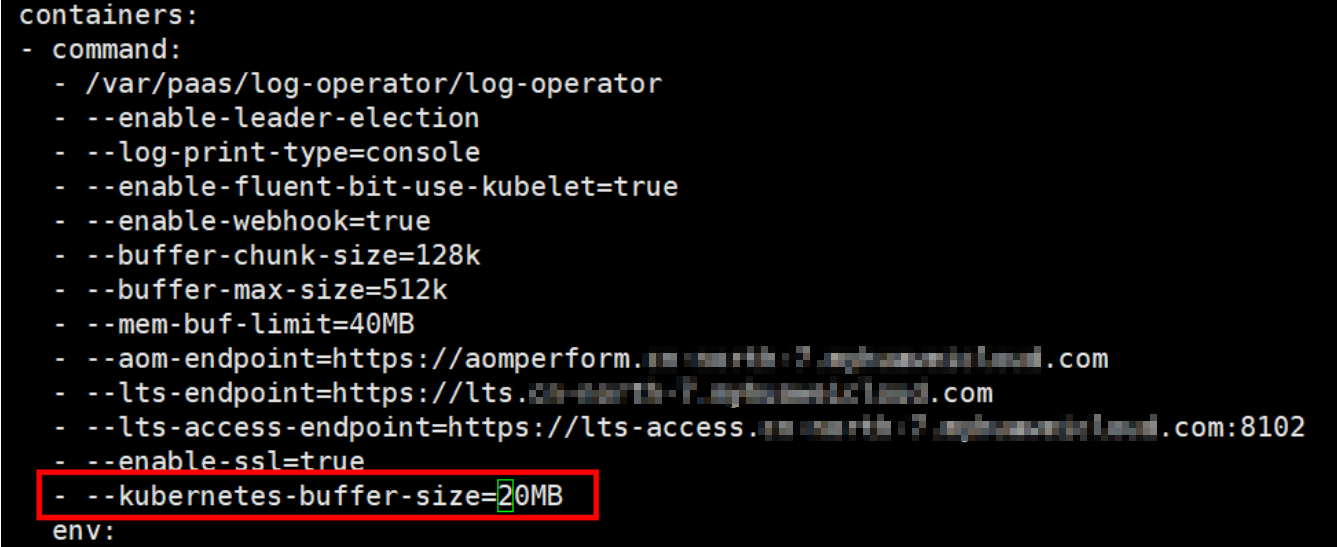

前往节点执行kubectl edit deploy -n monitoring log-agent-log-operator, 编辑log-operator容器的命令行参数,添加命令行--kubernetes-buffer-size=20MB,当前默认值为16MB,请根据节点pod信息总大小估算该值大小。0为无限制。

若升级插件,则需要重新配置该参数。

如何修复日志采集策略中日志组(流)不存在的问题?

- 场景一:默认日志组(流)不存在

以Kubernetes事件为例:当默认日志组(流)不存在时,控制台中的“Kubernetes事件”页面会提示当前日志组(流)不存在,您可以单击“创建默认日志组(流)”进行重新创建。

重建后的默认日志组(流)的ID会发生变化,对接默认日志组(流)的已有采集策略无法生效,请参见场景二进行修复。

图17 创建默认日志组(流)

- 场景二:默认日志组(流)存在但与日志采集策略不一致

- 支持修改的日志采集策略,例如default-stdout,修复方案如下:

- 登录CCE控制台,单击集群名称,在左侧导航栏中选择“日志中心”。

- 单击右上角“日志采集策略”,在对应的日志采集策略的操作栏中单击“编辑”。

- 选择“自定义日志组/日志流”,然后将其设置为集群的默认日志组(流)。

图18 设置默认日志组(流)

- 不支持修改的日志采集策略,例如default-event,则需要重建对应采集策略,修复方案如下:

- 登录CCE控制台,单击集群名称,在左侧导航栏中选择“日志中心”。

- 单击右上角“日志采集策略”,在对应的日志采集策略的操作栏中单击“删除”。

- 然后单击“创建日志采集策略”,选择策略模板中的“采集kubernetes事件”,单击“确定”进行创建。

- 支持修改的日志采集策略,例如default-stdout,修复方案如下:

- 场景三:自定义日志组(流)不存在

CCE界面暂不支持非默认日志组(流)的创建,请到云日志服务(LTS)进行重新创建。

创建完毕后,参考以下步骤进行修复:

- 登录CCE控制台,单击集群名称,在左侧导航栏中选择“日志中心”。

- 单击右上角“日志采集策略”,在对应的日志采集策略的操作栏中单击“编辑”。

- 选择“自定义日志组/日志流”,然后将其设置为新建的日志组(流)。

图19 设置自定义日志组(流)

Pod调度到CCI后,采集不到日志

若使用profile控制Pod调度到CCI后,出现调度到CCI的Pod采集不到日志的情况,且确认采集策略在CCE侧功能正常。

请检查CCE突发弹性引擎(对接CCI)插件版本是否低于1.3.54,若低于该版本,请升级插件。