使用盘古预置NLP大模型进行文本对话

场景描述

此示例演示了如何使用盘古预置NLP大模型进行对话问答,包含两种方式:使用“体验中心”功能和调用API接口。

您将学习如何使用“体验中心”功能调试模型超参数、如何调用盘古NLP大模型API以实现智能化对话问答能力。

前提条件

请确保您有预置的NLP大模型,并已完成模型的部署操作,详见《用户指南》“开发盘古NLP大模型 > 部署NLP大模型 > 创建NLP大模型部署任务”。

使用“体验中心”功能

“体验中心”功能支持用户直接调用已部署的预置服务,使用步骤如下:

- 登录ModelArts Studio大模型开发平台,进入所需空间。

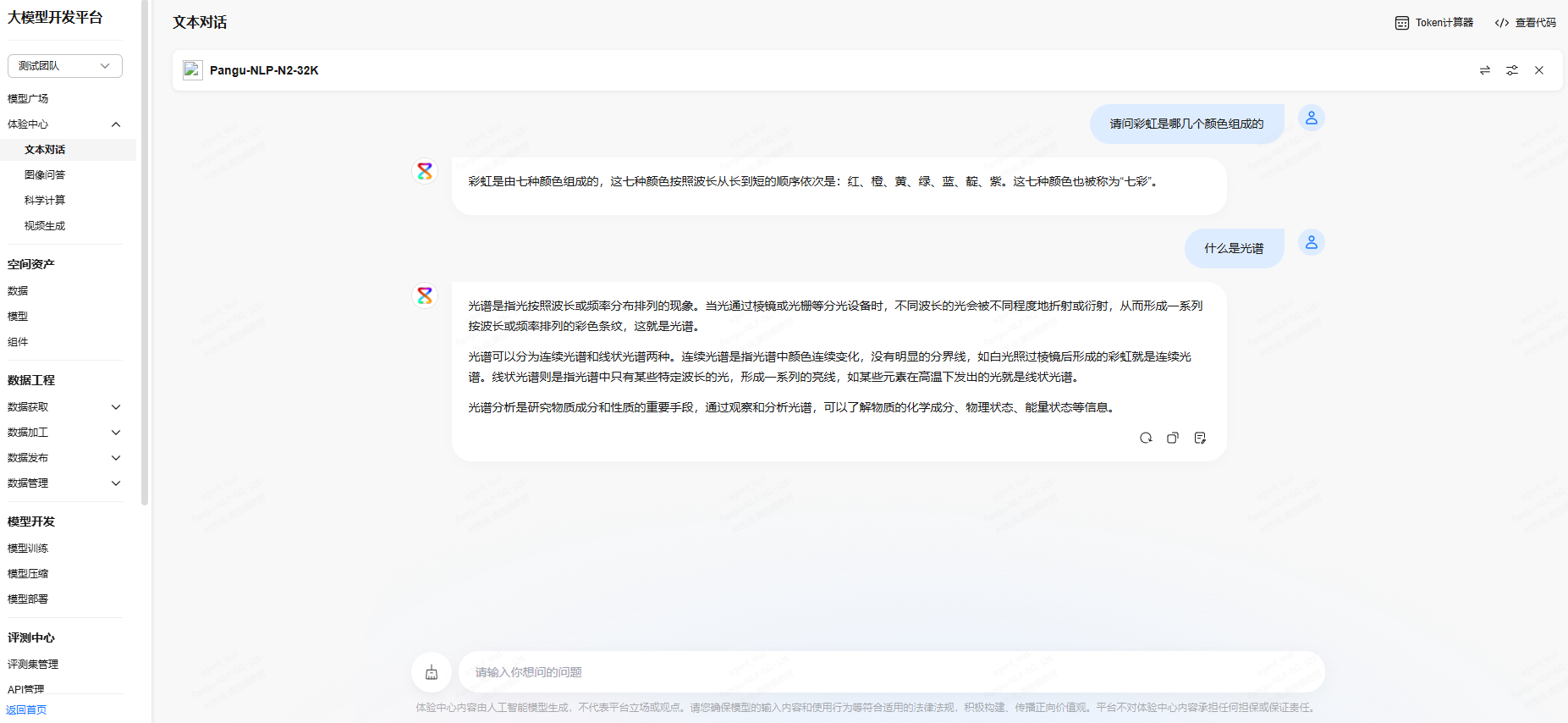

- 单击左侧“体验中心”,进入“文本对话”页签,选择服务,在输入框输入问题,模型将基于问题进行回答。

图1 使用预置服务进行文本对话

- 可以尝试修改参数并查看模型效果。以修改“核采样”参数为例,核采样控制生成文本的多样性和质量:

- 当“核采样”参数设置为1时,保持其他参数不变,单击“重新生成”,再单击“重新生成”,观察模型前后两次回复内容的多样性。

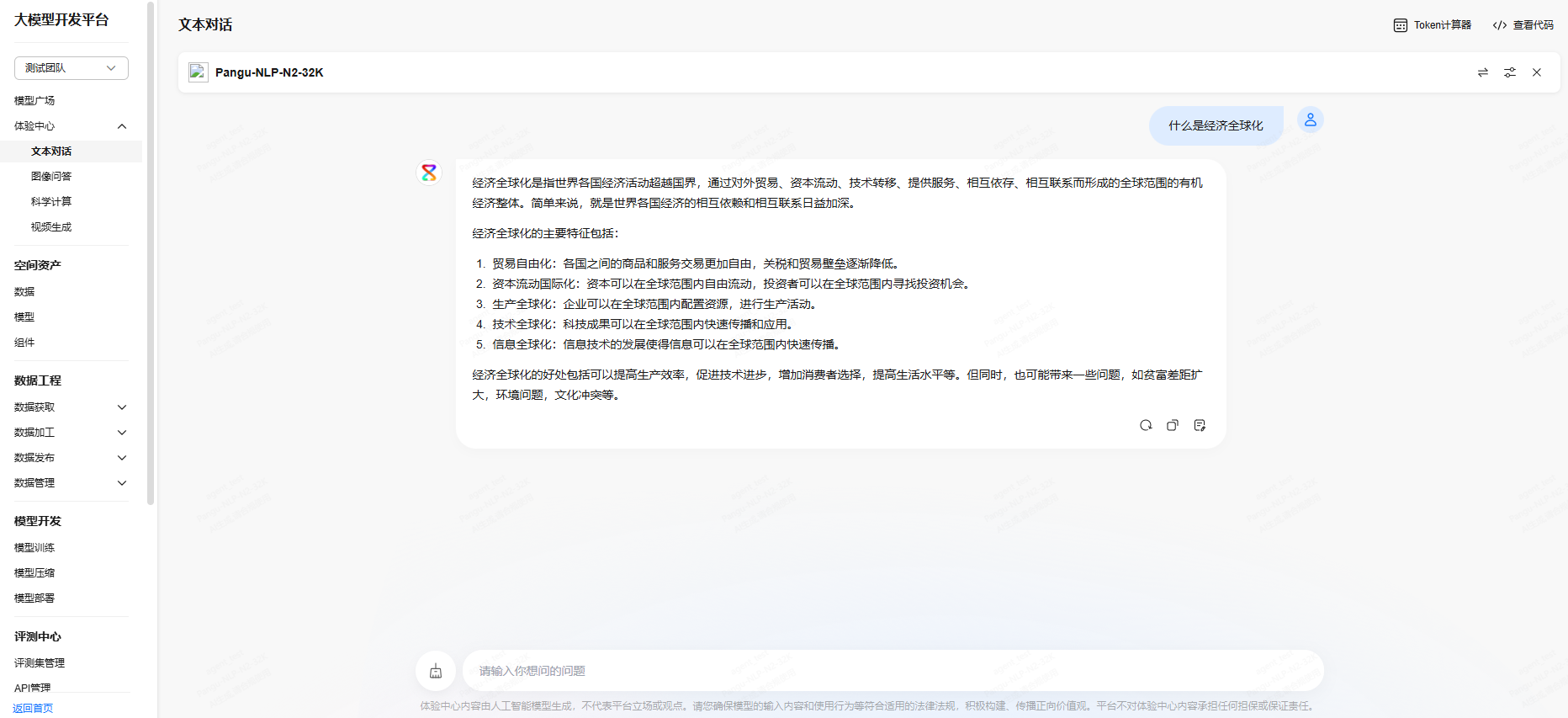

表1 “核采样”参数为1的生成结果 生成结果1

生成结果2

经济全球化是指世界各国经济活动超越国界,通过对外贸易、资本流动、技术转移、提供服务、相互依存、相互联系而形成的全球范围的有机经济整体。它包括生产全球化、贸易全球化和资本全球化等方面。经济全球化是当代世界经济的重要特征之一,也是世界经济发展的重要趋势。

经济全球化的主要表现有:

- 国际贸易的迅速增长:随着关税壁垒的降低和非关税壁垒的减少,国际贸易量迅速增加,各国经济相互依赖程度加深。

- 国际资本流动的加剧:跨国公司和国际金融市场的快速发展,使得资本在全球范围内自由流动,投资更加国际化。

- 生产全球化的趋势:生产要素在全球范围内重新配置,跨国公司在全球范围内设立生产基地,形成全球生产网络。

- 技术转移和知识传播的加快:信息技术的发展使得知识和技术能够迅速在全球范围内传播,促进了全球创新能力的提升。

经济全球化带来了许多积极影响,如促进了资源的有效配置、提高了生产效率、增加了消费者选择等。但同时也带来了一些挑战,如加剧了国际竞争、可能加剧贫富差距、对环境和资源造成压力等。因此,如何平衡经济全球化带来的利弊,是各国政府和国际社会需要共同面对和解决的问题。

经济全球化是指世界各国经济活动超越国界,通过对外贸易、资本流动、技术转移、提供服务、相互依存、相互联系而形成的全球范围的有机经济整体。简单来说,就是世界各国经济的相互依赖和相互联系日益加深。

经济全球化的主要特征包括:

- 贸易自由化:各国之间的商品和服务交易更加自由,关税和贸易壁垒逐渐降低。

- 资本流动国际化:资本可以在全球范围内自由流动,投资者可以在全球范围内寻找投资机会。

- 生产全球化:企业可以在全球范围内配置资源,进行生产活动。

- 技术全球化:科技成果可以在全球范围内快速传播和应用。

- 信息全球化:信息技术的发展使得信息可以在全球范围内快速传播。

经济全球化的好处包括可以提高生产效率,促进技术进步,增加消费者选择,提高生活水平等。但同时,也可能带来一些问题,如贫富差距扩大,环境问题,文化冲突等。

图2 “核采样”参数为1的生成结果1 图3 “核采样”参数为1的生成结果2

图3 “核采样”参数为1的生成结果2

- 将“核采样”参数调小至0.1,保持其他参数不变,单击“重新生成”,再单击“重新生成”,可以观察到模型前后两次回复内容的多样性降低。

表2 “核采样”参数为0.1的生成结果 生成结果1

生成结果2

经济全球化是指全球范围内的商品、服务、资本、技术和信息等生产要素跨国界流动和配置,各国经济相互依赖、相互联系日益紧密的过程。它是世界经济发展到一定阶段的必然结果,也是市场经济和科技进步的产物。

经济全球化的主要特征包括:

- 贸易自由化:各国之间的商品和服务交易更加自由,关税和贸易壁垒逐渐降低。

- 资本流动国际化:资本可以在全球范围内自由流动,投资者可以在全球范围内寻找投资机会。

- 生产全球化:企业可以在全球范围内配置资源,进行生产活动。

- 技术全球化:科技成果可以在全球范围内快速传播和应用。

- 信息全球化:信息技术的发展使得信息可以在全球范围内快速传播。

经济全球化的好处包括可以提高生产效率,促进技术进步,增加消费者选择,提高生活水平等。但同时,也可能带来一些问题,如贫富差距扩大,环境问题,文化冲突等。

经济全球化是指全球范围内的经济活动日益紧密地联系在一起,各国经济相互依赖、相互影响的过程。这一过程主要体现在以下几个方面:

- 贸易自由化:各国之间的商品和服务交易更加自由,关税和贸易壁垒逐渐降低,国际贸易量大幅增加。

- 资本流动国际化:资本可以在全球范围内自由流动,投资者可以在全球范围内寻找投资机会,跨国公司的数量和规模不断扩大。

- 生产全球化:企业可以在全球范围内配置资源,进行生产活动,形成了全球供应链。

- 技术全球化:科技成果可以在全球范围内快速传播和应用,推动了全球范围内的技术进步。

- 信息全球化:信息技术的发展使得信息可以在全球范围内快速传播,推动了全球范围内的信息交流。

经济全球化使得世界各国的经济联系更加紧密,促进了全球经济的发展。但同时,也带来了一些问题,如贫富差距扩大、环境问题、文化冲突等。因此,如何在全球化的过程中实现公平、可持续的发展,是各国需要共同面对的挑战。

图4 “核采样”参数为0.1的生成结果1 图5 “核采样”参数为0.1的生成结果2

图5 “核采样”参数为0.1的生成结果2

- 当“核采样”参数设置为1时,保持其他参数不变,单击“重新生成”,再单击“重新生成”,观察模型前后两次回复内容的多样性。

调用API接口

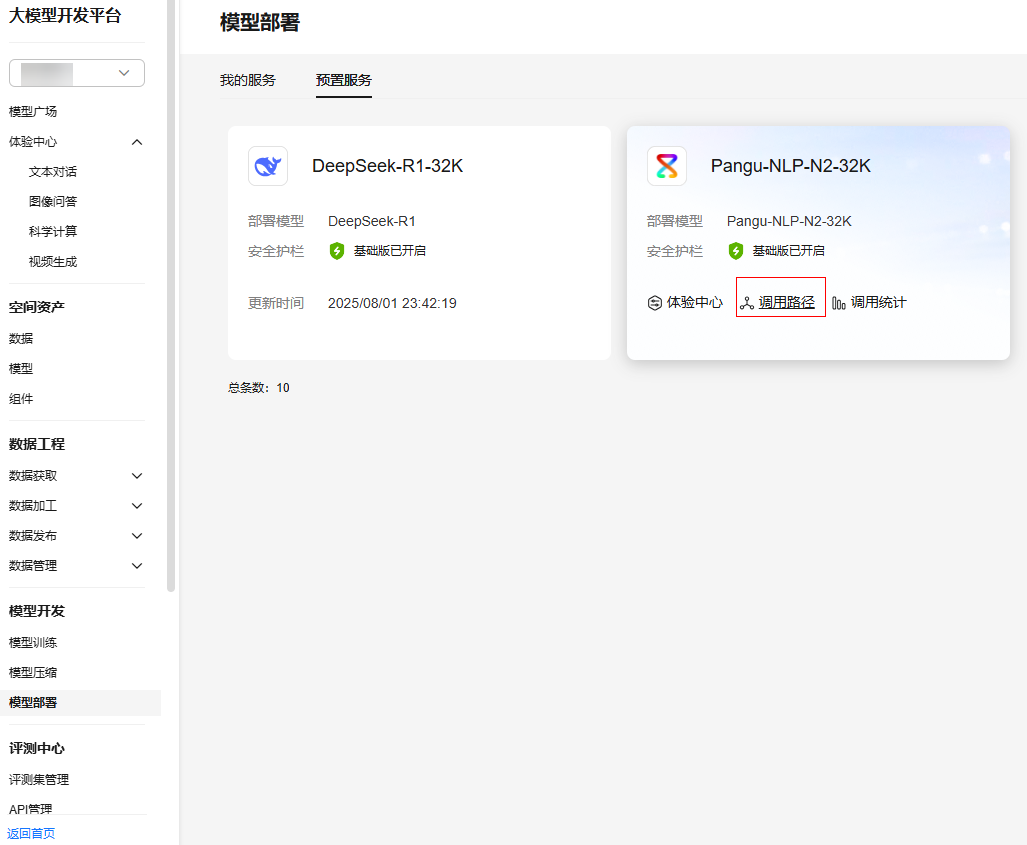

预置模型部署成功后,可以通过“文本对话”API调用NLP大模型,调用步骤如下:

- 登录ModelArts Studio大模型开发平台,进入所需空间。

- 获取调用路径。单击左侧“模型开发 > 模型部署”,在“预置服务”页签,选择所需调用的NLP大模型,单击“调用路径”,在“调用路径”弹窗获取调用路径。

图6 获取调用路径

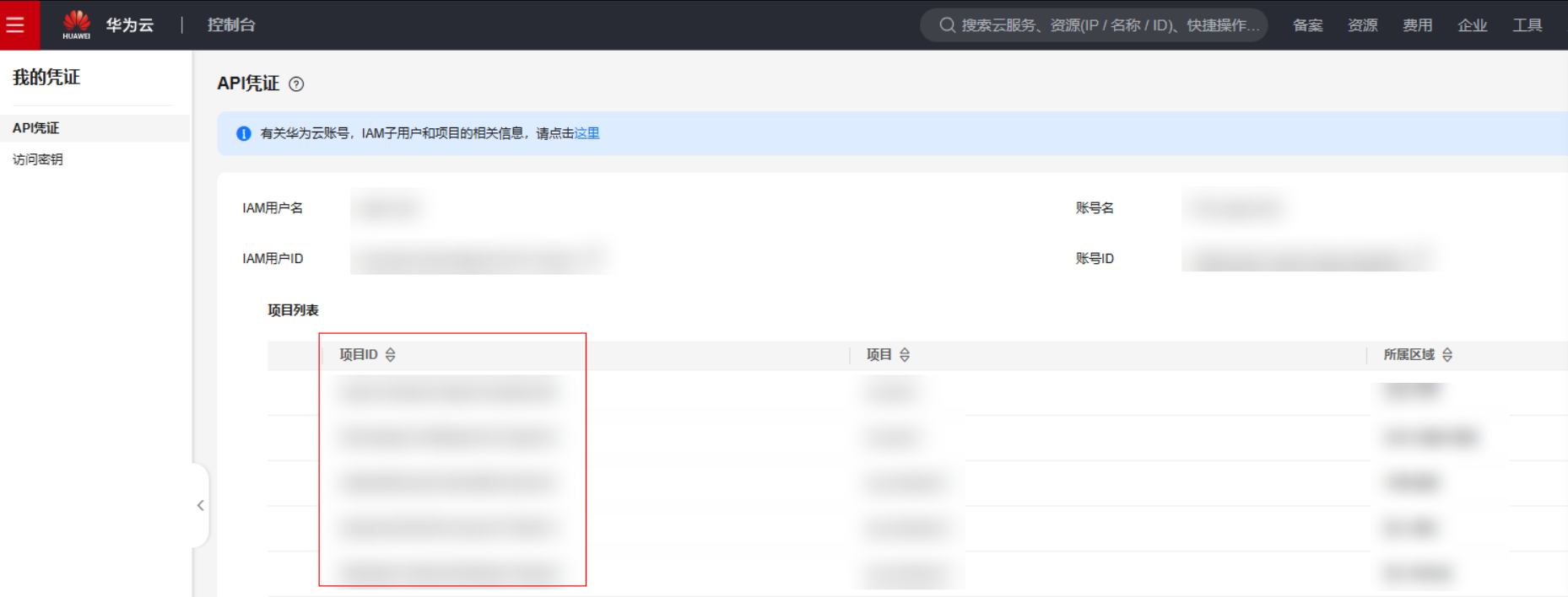

- 获取项目ID。在页面右上角“我的凭证”,在“API凭证”页面可获取项目ID。

图7 获取项目ID

- 获取Token。参考《API参考》文档“如何调用REST API > 认证鉴权”章节获取Token。

- 在Postman中新建POST请求,并填入调用路径(API请求地址)。

- 参考图8填写2个请求Header参数。

- 参数名为Content-Type,参数值为application/json。

- 参数名为X-Auth-Token,参数值为获取的Token值。

- 在Postman中选择“Body > raw”选项,参考以下代码填写请求Body。

{ "messages": [ { "content": "介绍下长江,以及长江中典型的鱼类" } ], "temperature": 0.9, "max_tokens": 600 } - 单击Postman界面“Send”按钮,发送请求。当接口返回状态为200时,表示NLP大模型API调用成功。