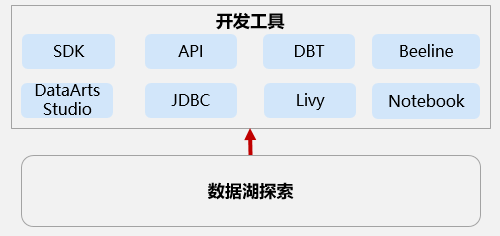

DLI支持的开发工具

DLI支持使用多种客户端连接方式,以满足不同用户的需求和使用场景。本节操作介绍DLI支持的连接方式和具体的应用场景。

在大数据分析和处理的场景中,不同用户可能需要根据自己的需求选择不同的客户端连接方式来访问数据湖服务(DLI)。然而,由于缺乏对多种连接方式的了解,用户可能会遇到选择困难,不知道哪种方式最适合自己的使用场景。DLI支持使用多种客户端连接方式,以满足不同用户的需求和使用场景。

本节操作将详细介绍DLI支持的连接方式和具体的应用场景,帮助您做出最佳选择。

|

连接方式 |

说明 |

支持提交的作业类型 |

应用场景 |

操作指导 |

|---|---|---|---|---|

|

DLI管理控制台方式 |

通过DLI管理控制台,您可以直观地管理和操作DLI服务,包括创建弹性资源池、添加或管理队列、提交作业、监控作业运行状态等。 |

|

提供图形化界面,操作简单直观,适合不熟悉命令行操作的用户。 |

DLI控制台操作指导请参考《DLI用户指南》。 |

|

DLI API方式 |

DLI提供了丰富的API接口,用户可以通过API编程方式管理和操作DLI服务,包括创建队列、提交作业、查询作业状态等。 |

|

适合具备编程基础的用户,可以通过API实现自动化管理和操作,提高工作效率。 |

具体操作请参见《数据湖探索API参考》。 |

|

DLI SDK的方式 |

DLI提供了多种语言的SDK(如Python、Java等),用户可以通过SDK在自己的应用程序中集成DLI服务,实现更复杂的业务逻辑。 |

|

提供了更丰富的功能和更高的灵活性,适合需要在应用程序中深度集成DLI服务的用户。 |

推荐使用DLI SDK V2版本 DLI SDK操作指导请参考《DLI SDK参考》。 |

|

使用JDBC方式 |

DLI支持JDBC连接,用户可以通过JDBC工具(如DBeaver、SQuirreL SQL等)连接到DLI,执行SQL查询和数据分析。 |

SQL作业 |

支持标准JDBC接口,兼容性强。 |

|

|

使用DataArts Studio 提交DLI作业 |

DLI与华为云DataArts Studio控制台深度集成,用户可以通过DataArts Studio实现一站式数据开发与分析,包括数据集成、数据开发、数据治理等。 |

|

提供一站式的数据开发和分析平台,简化了数据处理和分析的流程,提高了开发效率。 |

|

|

使用Notebook实例提交Spark作业 |

Notebook实例提供了交互式的编程环境,您可以基于Notebook提供的Web交互的开发环境同时完成代码的编写与作业的开发,使用Notebook灵活地进行数据分析与探索。 |

Spark作业 |

适用于需要实时查看数据处理和分析结果的场景,便于快速调整和优化代码。例如模型训练阶段 |

|

|

使用Livy提交Spark作业 |

基于开源的Apache Livy提交Spark作业到DLI。 |

Spark作业 |

Livy提供了稳定的REST API,适合在生产环境中提交和管理Spark作业。 |

|

|

DBT |

DBT(Data Build Tool),是一款开源的数据建模和转换工具,运行在Python环境上。 |

SQL作业 |

DBT连接DLI,用来定义和执行SQL转换,支持从数据集成、转换到分析的整个数据生命周期管理,适用于大规模数据分析项目和复杂的数据分析场景。 |

|

|

Beeline |

Beeline是数据分析师和数据工程师的重要工具之一。 |

SQL作业 |

适用于大规模数据处理的场景。Beeline提供了的SQL引擎,使得用户可以使用SQL的语言来执行数据查询、数据分析和管理任务。 |