创建Deepseek大模型训练任务

预训练

创建Deepseek大模型预训练任务步骤如下:

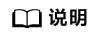

- 登录ModelArts Studio大模型开发平台,在“我的空间”模块,单击进入所需空间。

图1 我的空间

- 在左侧导航栏中选择“模型开发 > 模型训练”,单击右上角“创建训练任务”。

- 在“创建训练任务”页面,参考表1完成训练参数设置。

表1 Deepseek大模型预训练参数说明 参数分类

训练参数

参数说明

训练配置

选择模型

可以修改如下信息:

- 来源:选择“模型广场”。

- 类型:选择“大语言模型”,并选择训练所用的基础模型和版本(选择 DeepSeek-V3-32K或者DeepSeek-R1-32K具体版本)。

训练类型

选择“预训练”。

高级设置checkpoints

checkpoints:在模型训练过程中,用于保存模型权重和状态的机制。

- 关闭:关闭后不保存checkpoints,无法基于checkpoints执行续训操作。

- 自动:自动保存训练过程中的所有checkpoints。

- 自定义:根据设置保存指定数量的checkpoints。

训练参数

训练轮数

epochs,训练中遍历数据集的次数。

学习率

learning_rate,控制模型参数训练步长的更新幅度,学习率过大可能会导致模型难以收敛,过小可能会导致收敛速度过慢。

数据批量大小

batch_size,控制每个训练步长的样本量,数值越大,梯度会越稳定,但是同时也会使用更大的显存,受硬件限制可能会OOM,并延长单次训练时长。

序列长度

sequence_length,训练单条数据的最大长度,超过该长度的数据在训练时将被截断。

热身比例

warmup,控制热身阶段占整体训练的比例,可以使训练的热身阶段内学习率较小,模型慢慢趋于稳定,之后按预设学习率进行训练,模型收敛速度更快,效果更佳。

学习率衰减比率

lr_decay_ratio,控制学习率的参数,可以使模型更稳定地收敛,最小不会低于学习率x学习率衰减比率的值,若学习率不衰减则配置为1。

权重衰减系数

weight_decay,是一种对模型参数值大小进行衰减的正则化方法,防止模型过拟合,提高模型泛化能力。

模型保存策略

save_checkpoint_steps/save_checkpoint_epoch,训练过程中是按迭代步数,还是训练轮数保存Checkpoint文件。

模型保存间隔

save_checkpoint_steps,训练过程中每隔多少个训练步长保存一次模型Checkpoint文件。

save_checkpoint_epoch,训练过程中每个多少训练轮数保存一次模型Checkpoint文件。

模型保存个数

checkpoints:在模型训练过程中,用于保存模型权重和状态的机制。

- 关闭:关闭后不保存checkpoints,无法基于checkpoints执行续训操作。

- 全部:自动保存训练过程中的所有checkpoints。

- 自定义:根据设置保存指定数量的checkpoints。

训练数据配置

训练集

选择训练模型所需的数据集。

资源配置

计费模式

选择训练当前任务的计费模式。

训练单元

选择训练模型所需的训练单元。

当前展示的完成本次训练所需要的最低训练单元要求。

单实例训练单元数

选择单实例训练单元数。

实例数

选择实例数。

订阅提醒

订阅提醒

该功能开启后,系统将在任务状态更新时,通过短信或邮件将提醒发送给用户。

发布模型

开启自动发布

开启自动发布后,模型训练完成的最终产物会自动发布为空间资产,以便对模型进行压缩、部署、评测等操作或共享给其他空间。

基本信息

名称

训练任务名称。

描述

训练任务描述。

- 参数填写完成后,单击“立即创建”。

- 创建好训练任务后,页面将返回“模型训练”页面,可随时查看当前任务的状态。

全量微调

创建Deepseek大模型全量微调任务步骤如下:

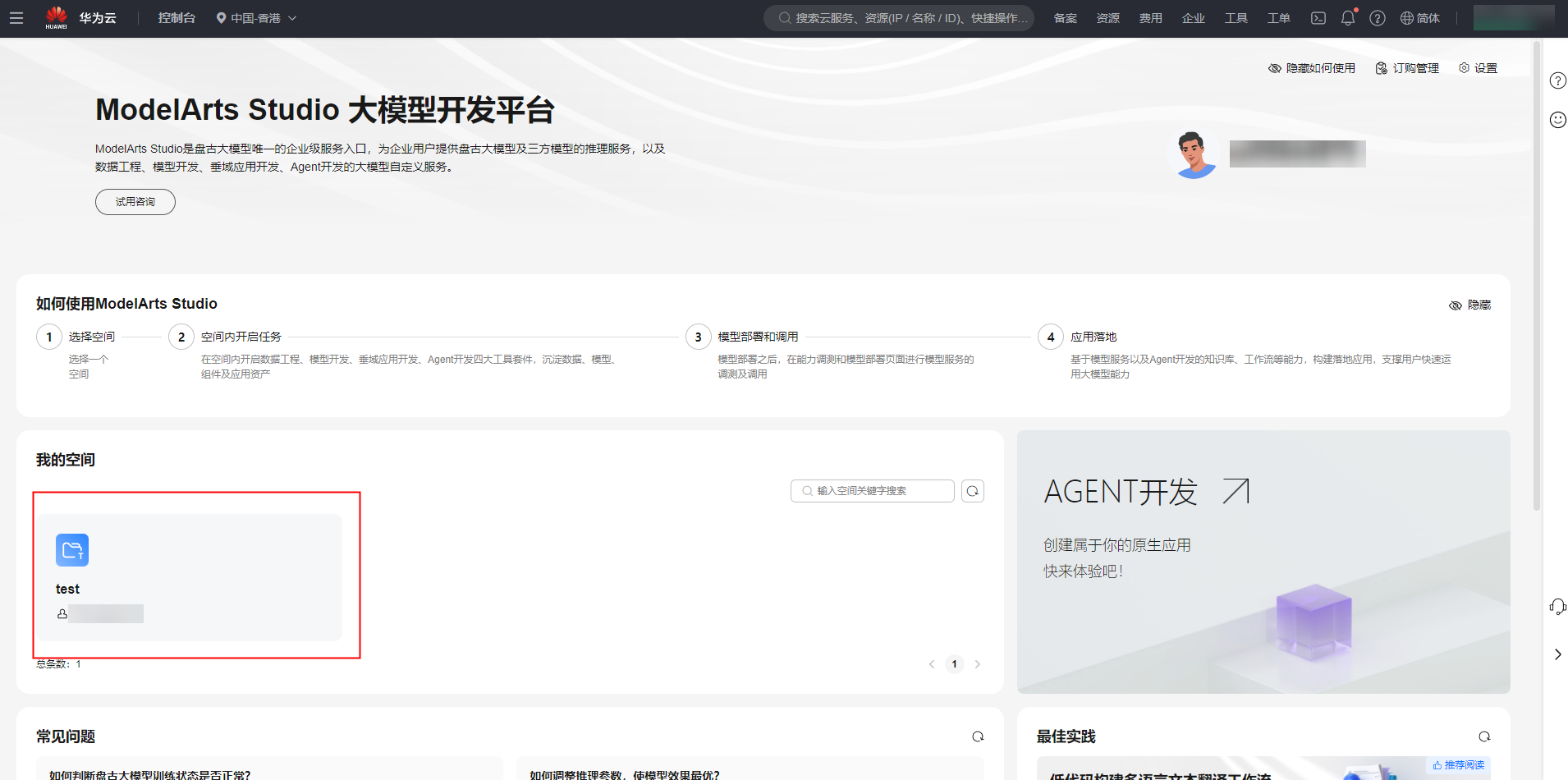

- 登录ModelArts Studio大模型开发平台,在“我的空间”模块,单击进入所需空间。

图2 我的空间

- 在左侧导航栏中选择“模型开发 > 模型训练”,单击界面右上角“创建训练任务”。

- 在“创建训练任务”页面,参考表2完成训练参数设置。

表2 Deepseek大模型全量微调参数说明 参数分类

训练参数

参数说明

训练配置

选择模型

可以修改如下信息:

- 来源:选择“模型广场”。

- 类型:选择“大语言模型”,并选择训练所用的基础模型和版本(选择 DeepSeek-V3-32K或者DeepSeek-R1-32K具体版本)。

训练类型

选择“微调”。

训练目标

选择“全量微调”。

- 全量微调:在模型进行有监督微调时,对大模型的所有参数进行更新。

高级设置

checkpoints:在模型训练过程中,用于保存模型权重和状态的机制。

- 关闭:关闭后不保存checkpoints,无法基于checkpoints执行续训操作。

- 自动:自动保存训练过程中的所有checkpoints。

- 自定义:根据设置保存指定数量的checkpoints。

训练参数

训练轮数

epochs,训练中遍历数据集的次数。

学习率

learning_rate,控制模型参数训练步长的更新幅度,学习率过大可能会导致模型难以收敛,过小可能会导致收敛速度过慢。

数据批量大小

batch_size,控制每个训练步长的样本量,数值越大,梯度会越稳定,但是同时也会使用更大的显存,受硬件限制可能会OOM,并延长单次训练时长。

序列长度

sequence_length,训练单条数据的最大长度,超过该长度的数据在训练时将被截断。

热身比例

warmup,控制热身阶段占整体训练的比例,可以使训练的热身阶段内学习率较小,模型慢慢趋于稳定,之后按预设学习率进行训练,模型收敛速度更快,效果更佳。

学习率衰减比率

lr_decay_ratio,控制学习率的参数,可以使模型更稳定地收敛,最小不会低于学习率x学习率衰减比率的值,若学习率不衰减则配置为1。

权重衰减系数

weight_decay,是一种对模型参数值大小进行衰减的正则化方法,防止模型过拟合,提高模型泛化能力。

模型保存策略

save_checkpoint_steps/save_checkpoint_epoch,训练过程中是按迭代步数,还是训练轮数保存Checkpoint文件。

模型保存间隔

save_checkpoint_steps,训练过程中每隔多少个训练步长保存一次模型Checkpoint文件。

save_checkpoint_epoch,训练过程中每个多少训练轮数保存一次模型Checkpoint文件。

模型保存个数

checkpoints:在模型训练过程中,用于保存模型权重和状态的机制。

- 关闭:关闭后不保存checkpoints,无法基于checkpoints执行续训操作。

- 全部:自动保存训练过程中的所有checkpoints。

- 自定义:根据设置保存指定数量的checkpoints。

数据配置

训练集

选择训练模型所需的数据集。

资源配置

计费模式

选择训练当前任务的计费模式。

训练单元

选择训练模型所需的训练单元。

当前展示的完成本次训练所需要的最低训练单元要求。

单实例训练单元数

选择单实例训练单元数。

实例数

选择实例数。

订阅提醒

订阅提醒

该功能开启后,系统将在任务状态更新时,通过短信或邮件将提醒发送给用户。

发布模型

是否开启自动发布

关闭,训练完成后手动发布到模型资产

开启,配置可见性、模型名称和描述

基本信息

名称

训练任务名称。

描述

训练任务描述。

不同模型训练参数默认值存在一定差异,请以前端页面展示的默认值为准。

- 参数填写完成后,单击“立即创建”。

- 创建好训练任务后,页面将返回“模型训练”页面,可随时查看当前任务的状态。

LoRA微调

创建Deepseek大模型LoRA微调任务步骤如下:

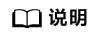

- 登录ModelArts Studio大模型开发平台,在“我的空间”模块,单击进入所需空间。

图3 我的空间

- 在左侧导航栏中选择“模型开发 > 模型训练”,单击界面右上角“创建训练任务”。

- 在“创建训练任务”页面,参考表3完成训练参数设置。

表3 Deepseek大模型LoRA微调参数说明 参数分类

训练参数

参数说明

训练配置

选择模型

可以修改如下信息:

- 来源:选择“模型广场”。

- 类型:选择“大语言模型”,并选择训练所用的基础模型和版本(选择 DeepSeek-V3-32K或者DeepSeek-R1-32K具体版本)。

训练类型

选择“微调”。

训练目标

选择“LoRA微调”。

- LoRA微调:在模型有监督微调过程中,冻结预训练好的模型权重参数,在保留自注意力模块中原始权重的基础上,对权重矩阵进行低秩分解,训练过程中只更新低秩部分的参数。

训练参数

训练轮数

epochs,训练中遍历数据集的次数

学习率

learning_rate,控制模型参数训练步长的更新幅度,学习率过大可能会导致模型难以收敛,过小可能会导致收敛速度过慢。

数据批量大小

batch_size,控制每个训练步长的样本量,数值越大,梯度会越稳定,但是同时也会使用更大的显存,受硬件限制可能会OOM,并延长单次训练时长。

序列长度

sequence_length,训练单条数据的最大长度,超过该长度的数据在训练时将被截断。

热身比例

warmup,控制热身阶段占整体训练的比例,可以使训练的热身阶段内学习率较小,模型慢慢趋于稳定,之后按预设学习率进行训练,模型收敛速度更快,效果更佳。

学习率衰减比率

lr_decay_ratio,控制学习率的参数,可以使模型更稳定地收敛,最小不会低于学习率x学习率衰减比率的值,若学习率不衰减则配置为1。

权重衰减系数

通过在损失函数中加入与模型权重大小相关的惩罚项,鼓励模型保持较小的权重,防止过拟合或模型过于复杂。

Lora矩阵的秩

LoRA_rank,在Lora矩阵中,Rank的值用于衡量矩阵的复杂度和信息量。数值较大,增强模型的表示能力,但会增加训练时长;数值越小可以减少参数数量,降低过拟合风险。

数据配置

训练集

选择训练模型所需的数据集。

资源配置

计费模式

选择训练当前任务的计费模式。

训练单元

选择训练模型所需的训练单元。

当前展示的完成本次训练所需要的最低训练单元要求。

单实例训练单元数

选择单实例训练单元数。

实例数

选择实例数。

订阅提醒

订阅提醒

该功能开启后,系统将在任务状态更新时,通过短信或邮件将提醒发送给用户。

发布模型

是否开启自动发布

关闭,训练完成后手动发布到模型资产

开启,配置可见性、模型名称和描述

基本信息

名称

训练任务名称。

描述

训练任务描述。

不同模型训练参数默认值存在一定差异,请以前端页面展示的默认值为准。

- 参数填写完成后,单击“立即创建”。

- 创建好训练任务后,页面将返回“模型训练”页面,可随时查看当前任务的状态。

QLoRA微调

创建Deepseek大模型全量微调任务步骤如下:

- 登录ModelArts Studio大模型开发平台,在“我的空间”模块,单击进入所需空间。

图4 我的空间

- 在左侧导航栏中选择“模型开发 > 模型训练”,单击界面右上角“创建训练任务”。

- 在“创建训练任务”页面,参考表4完成训练参数设置。

表4 Deepseek大模型QLoRA微调参数说明 参数分类

训练参数

参数说明

训练配置

选择模型

可以修改如下信息:

- 来源:选择“模型广场”。

- 类型:选择“大语言模型”,并选择训练所用的基础模型和版本(选择 DeepSeek-V3-32K或者DeepSeek-R1-32K具体版本)。

训练类型

选择“微调”。

训练目标

选择“QLoRA微调”。

- QLoRA微调:QloRA是一种高效微调大语言模型的技术,结合了量化和低秩适配器(Low-Rank Adaptation),旨在显著降低显存占用,同时保持模型性能,适用于资源受限的场景。

训练参数

训练轮数

epochs,训练中遍历数据集的次数。

学习率

learning_rate,控制模型参数训练步长的更新幅度,学习率过大可能会导致模型难以收敛,过小可能会导致收敛速度过慢。

数据批量大小

batch_size,控制每个训练步长的样本量,数值越大,梯度会越稳定,但是同时也会使用更大的显存,受硬件限制可能会OOM,并延长单次训练时长。

序列长度

sequence_length,训练单条数据的最大长度,超过该长度的数据在训练时将被截断

热身比例

warmup,控制热身阶段占整体训练的比例,可以使训练的热身阶段内学习率较小,模型慢慢趋于稳定,之后按预设学习率进行训练,模型收敛速度更快,效果更佳。

学习率衰减比率

lr_decay_ratio,控制学习率的参数,可以使模型更稳定地收敛,最小不会低于学习率x学习率衰减比率的值,若学习率不衰减则配置为1。

权重衰减系数

weight_decay,是一种对模型参数值大小进行衰减的正则化方法,防止模型过拟合,提高模型泛化能力。

Lora矩阵的轶

LoRA_rank,在Lora矩阵中,Rank的值用于衡量矩阵的复杂度和信息量。数值较大,增强模型的表示能力,但会增加训练时长;数值越小可以减少参数数量,降低过拟合风险。

数据配置

训练集

选择训练模型所需的数据集。

资源配置

计费模式

选择训练当前任务的计费模式。

训练单元

选择训练模型所需的训练单元。

当前展示的完成本次训练所需要的最低训练单元要求。

单实例训练单元数

选择单实例训练单元数。

实例数

选择实例数。

订阅提醒

订阅提醒

该功能开启后,系统将在任务状态更新时,通过短信或邮件将提醒发送给用户。

发布模型

是否开启自动发布

关闭,训练完成后手动发布到模型资产

开启,配置可见性、模型名称和描述

基本信息

名称

训练任务名称。

描述

训练任务描述。

不同模型训练参数默认值存在一定差异,请以前端页面展示的默认值为准。

- 参数填写完成后,单击“立即创建”。

- 创建好训练任务后,页面将返回“模型训练”页面,可随时查看当前任务的状态。