GaussDB集中式/分布式同步到DMS Kafka作业配置

支持的源端和目的端数据库版本

|

源端数据库 |

目的端数据库 |

|---|---|

|

GaussDB集中式/分布式数据库(内核引擎版本505.1.0、505.1.0.SPC0100、505.2.0) |

Kafka集群(2.7、3.x版本) |

数据库账号权限要求

在使用Migration进行同步时,源端和目的端所使用的数据库账号需要满足以下权限要求,才能启动实时同步任务。不同类型的同步任务,需要的账号权限也不同,详细可参考下表进行赋权。

|

类型名称 |

权限要求 |

|---|---|

|

源数据库连接账号 |

|

|

目标数据库连接账号 |

Kafka开启密文接入场景下,所配置用户需要有发布和订阅Topic的权限,其余场景无特殊权限要求。 |

- 建议创建单独用于Migration任务连接的数据库账号,避免因为数据库账号密码修改,导致的任务连接失败。

- 连接源和目标数据库的账号密码修改后,请同步修改管理中心对应的连接信息,避免任务连接失败后自动重试,导致数据库账号被锁定影响使用。

支持的同步对象范围

在使用Migration进行同步时,不同类型的链路,支持的同步对象范围不同,详细情况可参考下表。

|

类型名称 |

使用须知 |

|---|---|

|

同步对象范围 |

|

注意事项

除了数据源版本、连接账号权限及同步对象范围外,您还需要注意的事项请参见下表。

|

类型名称 |

使用和操作限制 |

|---|---|

|

数据库限制 |

|

|

使用限制 |

通用:

全量同步阶段: 任务启动和全量数据同步阶段,请不要在源数据库执行DDL操作,否则可能导致任务异常。 增量同步阶段:

常见故障排查: 在任务创建、启动、全量同步、增量同步、结束等过程中,如有遇到问题,可先参考常见问题章节进行排查。 |

|

其他限制 |

|

操作步骤

本小节以GaussDB到DMS Kafka的实时同步为示例,介绍如何配置Migration实时集成作业。配置作业前请务必阅读使用前自检概览, 确认已做好所有准备工作。

- 参见新建实时集成作业创建一个实时集成作业并进入作业配置界面。

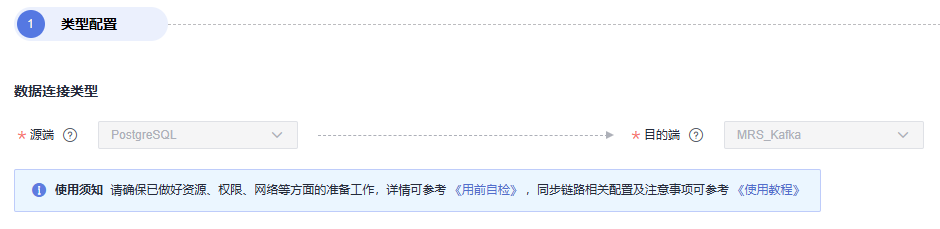

- 选择数据连接类型:源端选PostgreSQL,目的端选MRS Kafka。

图1 选择数据连接类型

- 选择集成作业类型:同步类型默认为实时,同步场景包含整库场景。

图2 选择集成作业类型

- 配置网络资源:选择已创建的GaussDB(RDS PostgreSQL)、MRS Kafka数据连接和已配置好网络连接的migration资源组。

图3 选择数据连接及migration资源组

无可选数据连接时,可单击“新建”跳转至管理中心数据连接界面,单击“创建数据连接”创建数据连接,详情请参见配置DataArts Studio数据连接参数进行配置。

无可选migration资源组时,可单击“新建”跳转至购买migration资源组页面创建migration资源组配置,详情请参见购买创建数据集成资源组增量包进行配置。

- 检测网络连通性:数据连接和migration资源组配置完成后需要测试整个迁移任务的网络连通性,可通过以下方式进行数据源和migration资源组之间的连通性测试。

- 单击展开“源端配置”触发连通性测试,会对整个迁移任务的连通性做校验。

- 单击源端和目的端数据源和migration资源组中的“测试”按钮进行检测。

- 配置源端参数。

各同步场景下选择需要同步库表的方式请参考下表。

表5 选择需要同步的库表 同步场景

配置方式

整库

选择需要迁移的GaussDB库表。图4 选择库表

库与表均支持自定义选择,即可选择一库一表,也可选择多库多表。

- 配置目的端参数。

图5 Kafka目的端配置项

- 目标Topic名称规则。

配置源端库表与目的端Kafka Topic的映射规则,可指定为固定的一个Topic,也可使用内置变量做映射,将不同源表数据同步到不同的Topic中。

可以使用的内置变量有:

- 源库名:#{source_db_name}。

- 源表名:#{source_table_name}。

- 同步kafka partition策略

支持以下三种投递策略将源端的数据按规则同步到Kafka Topic的特定Partition:

- 全部投递到Partition 0。

- 按库名+表名的hash值投递到不同Partition。

- 按表的主键值hash值投递到不同的Partition。

源端无主键情况下,目的端默认投递到partition 0。

- 新建Topic的Partition数量

- Kafka目标端属性配置

支持设置Kafka的配置项,需要增加 properties. 前缀,作业将自动移除前缀并传入底层Kafka客户端,具体参数可参考Kafka官方文档中的配置说明。

- 高级配置

支持在作业“任务配置”中添加自定义属性来开启部分高级功能,参数详情可参考GaussDB > Kafka高级参数一览表。

图6 添加自定义属性

表6 GaussDB > Kafka高级参数一览表 参数名

参数类型

默认值

单位

参数说明

sink.delivery-guarantee

string

at-least-once

-

Flink写Kafka时的语义保证机制。

- at-least-once:在 checkpoint 时会等待 Kafka 缓冲区中的数据全部被 Kafka producer 确认。消息不会因 Kafka broker 端发生的事件而丢失,但可能会在 Flink 重启时重复,因为 Flink 会重新处理旧数据。

- exactly-once:该模式下,Kafka sink 会将所有数据通过在 checkpoint 时提交的事务写入。因此,如果 consumer 只读取已提交的数据,在 Flink 发生重启时不会发生数据重复。然而这会使数据在 checkpoint 完成时才会可见,因此请按需调整 checkpoint 的间隔。

- 目标Topic名称规则。

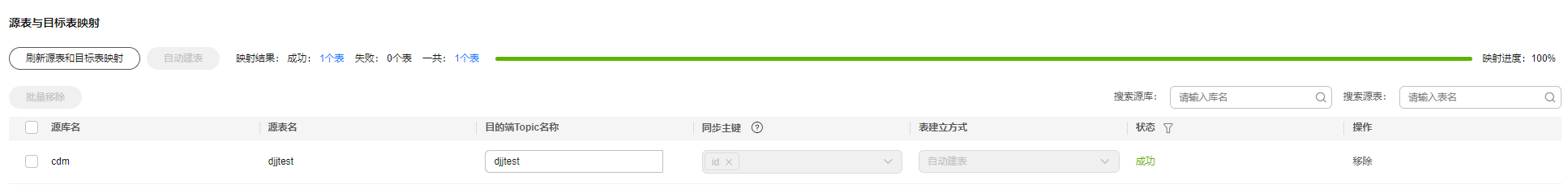

- 刷新源表和目标表映射,检查映射关系是否正确。

支持用户根据实际需求修改映射后的目的端Topic名称,可以配置为一对一、多对一的映射关系。图7 源表与目标表映射

- 配置任务属性。

表7 任务配置参数说明 参数

说明

默认值

执行内存

作业执行分配内存,跟随处理器核数变化而自动变化。

8GB

处理器核数

范围:2-32。

每增加1处理核数,则自动增加4G执行内存和1并发数。

2

并发数

作业执行支持并发数。该参数无需配置,跟随处理器核数变化而自动变化。

1

自动重试

作业失败时是否开启自动重试。

否

最大重试次数

“自动重试”为是时显示该参数。

1

重试间隔时间

“自动重试”为是时显示该参数。

120秒

添加自定义属性

支持通过自定义属性修改部分作业参数及开启部分高级功能,详情可参见任务性能调优章节。

-

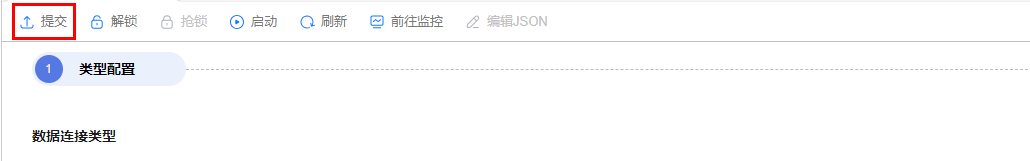

- 提交并运行任务。

作业配置完毕后,单击作业开发页面左上角“提交”,完成作业提交。

图8 提交作业

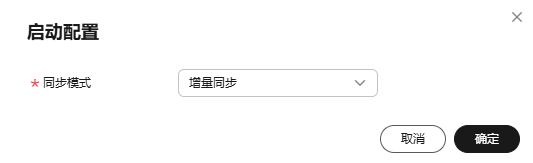

提交成功后,单击作业开发页面“启动”按钮,在弹出的启动配置对话框按照实际情况配置同步位点参数,单击“确定”启动作业。

图9 启动配置

表8 启动配置参数 参数

说明

同步模式

- 增量同步:从指定时间位点开始同步增量数据。

- 全量+增量:先同步全量数据,随后实时同步增量数据。

- 监控作业。

通过单击作业开发页面导航栏的“前往监控”按钮,可前往作业监控页面查看运行情况、监控日志等信息,并配置对应的告警规则,详情请参见实时集成任务运维。

图10 前往监控

性能调优

若链路同步速度过慢,可参见任务性能调优章节中对应链路文档进行排查及处理。