批作业监控

批作业监控提供了对批处理作业的状态进行监控的能力。

批处理作业支持作业级别的调度计划,可以定期处理批量数据,主要用于实时性要求低的场景。批作业是由一个或多个节点组成的流水线,以流水线作为一个整体被调度。被调度触发后,任务执行一段时间必须结束,即任务不能无限时间持续运行。

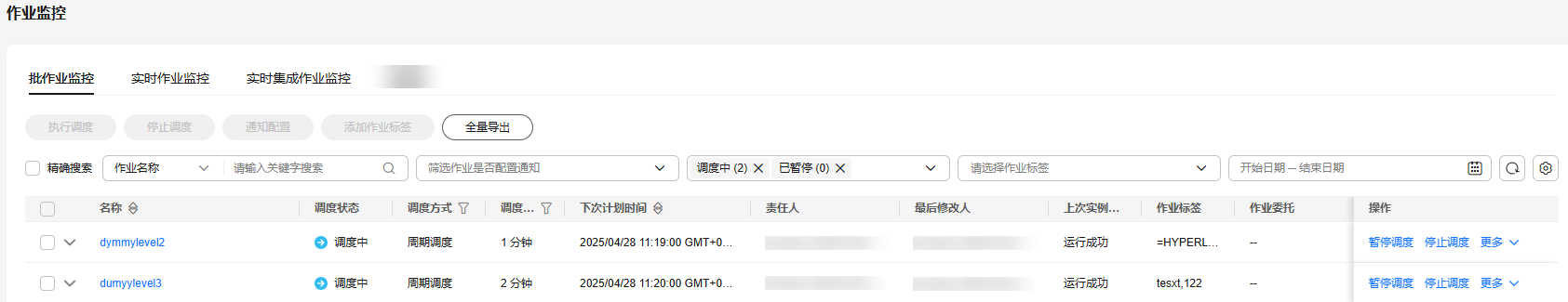

您可以在“作业监控 > 批作业监控”页面查看批处理作业的调度状态、调度周期、调度开始时间、SQL复杂度等信息,以及进行如表1所示的操作。

|

支持的操作项 |

说明 |

|---|---|

|

根据“作业名称”、“责任人”、“CDM作业”、“作业ID”、“调度身份”或“节点类型”筛选作业 |

- |

|

根据“作业是否配置通知”、“调度状态”、“作业标签”或“下次计划时间”范围,筛选作业 |

对于未配置通知的作业,系统支持可以通知类型(例如运行异常/失败)进行筛选,以便批量设置告警通知。 |

|

批量配置作业 |

通过勾选作业名称前的复选框,支持批量执行操作。 |

|

查看作业实例状态 |

单击作业名称前方的 在最近的实例的“操作”列,可以查看作业实例的运行日志,重跑作业实例。 |

|

查看作业的节点信息 |

单击作业名称,在打开的页面中单击作业节点,查看该节点的相关关联作业/脚本与监控信息。 单击作业名称,在打开的页面中查看该作业的作业实例,详情请参见批作业监控:作业实例。 |

|

调度作业相关 |

支持执行调度、暂停调度、恢复调度、停止调度、调度配置等,详情请参见批作业监控:调度作业。

说明:

作业停止调度/暂停调度时,支持设置立即生效或者下次生效。 立即生效:立即停止当前作业实例,并且后续不再生成新的作业实例。 下次生效:当前作业实例继续运行,但后续不再生成新的作业实例。 |

|

通知配置 |

在作业的“操作”列,选择,弹出“通知配置”页面,参考表1配置通知参数。 |

|

实例监控 |

在作业的“操作”列,选择,跳转到实例监控页面,查看该作业所有实例的运行记录。 |

|

调度配置 |

在作业的“操作”列,选择,跳转到作业开发页面,查看该作业调度配置信息,可以对作业的调度信息进行配置。

说明:

运行中的作业不支持配置调度操作。 |

|

补数据 |

在作业的“操作”列,选择,弹出“补数据”对话框,详情请参见批作业监控:补数据。 只有配置为周期调度类型的作业才支持补数据功能。 |

|

添加作业标签 |

在作业的“操作”列,选择,弹出对话框,详情请参见批作业监控:添加作业标签。 |

|

查看作业依赖图 |

在作业的“操作”列,选择,详情请参见批作业监控:查看作业依赖图。 |

|

全量导出 |

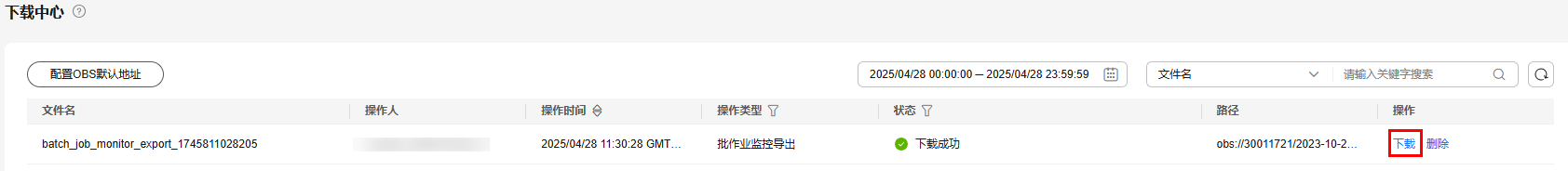

单击“全量导出”,导出完成后,请到下载中心查看导出的内容,可以下载导出的文件。

图2 查看导出记录

如果没有配置默认存储路径,单击“全量导出”后,配置存储路径,可以将该存储路径设为OBS默认地址。 当前导出数据量最大为30M,超过30M系统会自动截断。 导出的作业实例与作业节点存在对应关系。目前不支持通过勾选作业名称导出所勾选的数据,可以通过筛选条件选择需要导出的数据。 |

单击作业名称,在打开的页面中查看该作业的作业参数、作业属性、作业实例。

单击作业的某个节点,可以查看节点属性、脚本内容、节点监控信息。

同时,您可以查看当前作业版本、作业调度状态、执行调度、停止调度、对运行中的作业暂停调度、补数据、通知配置、设置作业刷新频率等。

批作业监控:作业实例

- 参考访问DataArts Studio实例控制台,登录DataArts Studio管理控制台。

- 在DataArts Studio控制台首页,选择对应工作空间的“数据开发”模块,进入数据开发页面。

- 在数据开发主界面的左侧导航栏,选择。

- 单击“批作业监控”页签,进入批作业的监控页面。

- 单击作业名称,在打开的页面中查看该作业的作业实例。您可以进行以下操作:

- 当勾选上“显示尚未生成的实例”后,通过时间筛选未来时间内尚未生成的作业实例。

勾选后进行筛选,能够显示未来时间内预计可能会生成的实例,显示的未生成实例数量不超过100个。

- 对于未来时间内尚未生成的作业实例,可以进行“冻结”和“解冻”操作。您可以单击作业实例列表上面的“冻结”和“解冻”按钮,或者通过右侧操作列的“更多”中选择冻结和解冻进行冻结和解冻操作,支持批量操作。

冻结:作业实例尚未生成或者作业实例是等待运行的状态,且实例未被冻结上,才能够进行冻结。

已被冻结的作业实例,实例运行状态为冻结状态。

作业被冻结后,会按照作业运行失败进行处理,下游依赖的相关作业,如果依赖设置的是挂起,则下游作业挂起;如果依赖设置的继续执行,则下游作业继续执行;如果依赖设置的取消,则下游作业取消执行。

尚未生成的作业实例被冻结后,可以在批作业监控的作业实例中查看,也可以在实例监控中通过运行状态进行筛选去查看被冻结状态的实例。

解冻:作业实例还未开始调度,且实例已被冻结,才能够进行解冻。

- 对作业实例进行相关的其他操作,例如:停止、重跑、手工重试、继续执行、强制成功、查看作业等待实例,查看作业开发配置信息等操作。在查看作业等待实例时,单击“操作 > 去除依赖”可以去除对上游单个实例的依赖关系。

- 手工确认执行场景下,在批作业监控页面,作业实例运行状态显示为“待确认执行”,可以进行手动确认执行,单击“确认执行”后,作业实例运行状态显示为“等待运行”。

- 当勾选上“显示尚未生成的实例”后,通过时间筛选未来时间内尚未生成的作业实例。

批作业监控:调度作业

作业开发完成后,用户可以在“作业监控”页面中管理作业的调度任务,例如:执行调度、暂停调度、恢复调度、停止调度。

- 参考访问DataArts Studio实例控制台,登录DataArts Studio管理控制台。

- 在DataArts Studio控制台首页,选择对应工作空间的“数据开发”模块,进入数据开发页面。

- 在数据开发主界面的左侧导航栏,选择。

- 单击“批作业监控”页签,进入批作业的监控页面。

批作业监控支持按照调度方式和调度周期进行筛选,可以通过条件过滤查看所需要的作业调度实例。

- 在作业的“操作”列,单击“执行调度”/“暂停调度”/“恢复调度”/“停止调度”。

如果该批处理作业设置有依赖的作业,执行调度该作业时可以设置为只启动当前作业或同时启动依赖的作业。如何配置依赖作业,请参见配置作业调度任务(批处理作业)。

如果该作业在基线任务链路上,暂停调度/停止调度时,系统会自动给出基线关联的弹窗提示。

如果该作业在基线任务链路上或者被其他作业依赖, 暂停调度/停止调度时,系统会自动给出弹窗提示。

批作业监控:补数据

补数据是指作业执行一个调度任务,在过去某一段时间里生成一系列的实例。用户可以通过补数据,修正历史中出现数据错误的作业实例,或者构建更多的作业记录以便调试程序等。

只有配置了周期调度的作业,才支持使用该功能。如需查看补数据的执行情况,请参见补数据监控。

当作业正在补数据时,请勿修改作业配置,否则会影响补数据过程中生成的作业实例。

- 参考访问DataArts Studio实例控制台,登录DataArts Studio管理控制台。

- 在DataArts Studio控制台首页,选择对应工作空间的“数据开发”模块,进入数据开发页面。

- 在数据开发主界面的左侧导航栏,选择。

- 单击“批作业监控”页签,进入批作业的监控页面。

- 在作业的“操作”列,选择。

- 弹出“补数据”对话框,配置如表2所示的参数。

图5 补数据参数

表2 参数说明 参数

说明

补数据名称

系统自动生成一个补数据的任务名称,允许修改。

作业名称

显示需要补数据的作业名称。

调度时间方式

业务日期

当“调度时间方式”选择为“单段连续业务日期”:

选择需要补数据的时间段。业务日期不能大于当前时间,大于当前时间系统会默认显示当前时间。

说明:一个作业可进行多次补数据。但多次补数据的业务日期需要避免交叉重叠,否则可能导致数据重复或混乱,用户请谨慎操作。

如果勾选了“按日期倒序补数据”,则系统按照日期倒序补跑,每日内的补数顺序仍是正序。

说明:- 该功能适合在各日数据不耦合的条件下使用。

- 为保证补数据可以倒序进行,补数据作业对更早日期作业实例的依赖关系将被忽略。

当“调度时间方式”选择为“多段离散业务日期”:

除了配置上面的业务日期参数,还需要配置以下补数据的参数:

单击“添加多段业务日期”可以添加多个离散的补数据的业务日期。您至少需要配置一个业务日期范围。

单击“删除”可以删除已添加的离散业务日期。

说明:因为DataArts Studio不支持底层服务(例如,以前的CDM、DLI等服务)的补数据实例和周期调度作业实例并发运行,为了保证补数据实例不影响周期调度作业实例运行,两种类型作业实例不会抢占并发,所以,作业的周期调度的日期与该作业补数据的业务日期不能重合,周期调度和补数据不能同时运行,避免出现运行异常问题。

是否设置周期补数据

- 是,补数据时会按照设置的周期进行补数据任务。

第二个值表示按指定周期补数据,例如:小时、天,周、月。

说明:设置周期后,将会按照周期进行补数据任务调度。对于调度周期为分钟,间隔小时以及天的任务,将按照新设置的周期去调度补数据任务,起始点为业务日期的第一个时间点。例如任务为每天1:00开始的小时任务,需要对2023/01/01 00:00 - 2023/02/01 00:00进行补数据操作, 周期为2天,则将调度2023/01/01 00:00,2023/01/03 00:00,2023/01/05 00:00……等任务。此外,当调度周期为月时候,如果第一个节点为月末最后一天,将默认调度每月最后一天。

- 否,补数据时不会按照周期进行补数据任务,默认原有的补数据规则进行补数据任务。

指定周期

当“调度时间方式”选择为“多段离散业务日期”时,需要配置此参数。

指定补数据的时间周期

通过“查看调度信息”可以查看当前时间段下任务实例执行时间。

说明:只有调度周期是小时调度和分钟调度时,进行离散补数据的时候才会有指定周期。

并行周期数

设置同时执行的实例数量,最多可同时执行5个实例。

如果补数据按照天粒度补数据,并行周期数就是在同一天内单个作业的实例并行数。

如果补数据不按照天粒度补数据,并行周期数就是按照调度周期内单个作业的实例并行数。

说明:请根据实际情况配置并行周期数,例如CDM作业实例,不可同时执行补数据操作,并行周期数只可设置为1。

需要补数据的上下游作业

选择需要补数据的上下游作业(指依赖于当前作业的作业),支持多选。

此处系统会展示作业依赖关系视图,关于作业依赖关系视图的操作,请参考批作业监控:查看作业依赖图。

说明:周期补数据场景下,当前只允许针对调度周期相同的上下游作业进行补数据。

是否按天粒度补数据

如果选择了按天粒度去补数据,表示在同一天内单个作业补数据的实例可以并行去跑,不在同一天内的单个作业补数据的实例不能并行去跑。例如小时任务可以5点和6点的作业实例并行跑,而1号和2号的作业实例不能并行跑。

是:按天粒度补数据

否:不按天粒度补数据

失败后是否停止

如果“是否按天粒度补数据”选择“是”,需要配置此参数。

是:按天粒度补数据如果失败后,后面的补数据任务立即停止。

否:按天粒度补数据如果失败后,后面的补数据任务继续执行。

说明:按天粒度补数据,前面一天任务执行失败后,第二天补数据任务不再执行。系统仅支持按天维度的补数据状态进行判断,不支持同一天内小时任务的多批次场景。

优先级

选择补数据的优先级。通过默认项配置可以设置工作空间级的补作业的优先级。

说明:补数据的优先级高于工作空间的补数据优先级。

当前只支持对DLI SQL算子设置优先级。

是否忽略OBS监听

- 是,补数据场景下,系统会忽略OBS监听。

- 否,补数据场景下,系统会监听OBS路径。

是否设置运行时间段

设置补数据任务的运行时间段。

- 单击“确定”,开始补数据,并进入“补数据监控”页面。

批作业监控:添加作业标签

支持给作业添加标签,便于作业实例的筛选分类。

- 参考访问DataArts Studio实例控制台,登录DataArts Studio管理控制台。

- 在DataArts Studio控制台首页,选择对应工作空间的“数据开发”模块,进入数据开发页面。

- 在数据开发主界面的左侧导航栏,选择。

- 单击“批作业监控”页签,进入批作业的监控页面。

- 在作业的“操作”列,选择。

- 弹出对话框,填写需要配置的作业标签。

图6 添加作业标签参数

- 填写完标签后,单击“确认”,完成作业标签的添加。

批作业监控:查看作业依赖图

作业依赖关系视图支持查看作业与其他作业的依赖关系。

- 参考访问DataArts Studio实例控制台,登录DataArts Studio管理控制台。

- 在DataArts Studio控制台首页,选择对应工作空间的“数据开发”模块,进入数据开发页面。

- 在数据开发主界面的左侧导航栏,选择。

- 单击“批作业监控”页签,进入批作业的监控页面。

- 在作业的“操作”列,选择。

- 在弹出的“作业依赖关系视图”页面,支持如下操作:

- 视图右上角支持“显示完整依赖图”、“显示当前作业及其上下游”和“显示当前作业及其直接上下游”。

- 视图右上角支持按节点名称进行搜索,搜索出来的作业节点高亮显示。

- 单击下载按钮,可以下载作业的依赖关系文件。

- 鼠标滚轮可放大、缩小关系图。

- 鼠标按住空白处,可自由拖拽用以查看完整关系图。

- 鼠标光标悬停在作业节点上,该作业节点会被标记为绿色,上游作业会被标记为青蓝色,下游作业会被标记为橙黄色。

图7 上下游作业节点标记

- 在作业节点上右键单击,可进行查看作业、复制作业名称、收起上/下游作业等操作。

图8 作业节点操作

另外,作业的节点监控信息还可以通过作业详情查看。

- 参考访问DataArts Studio实例控制台,登录DataArts Studio管理控制台。

- 在DataArts Studio控制台首页,选择对应工作空间的“数据开发”模块,进入数据开发页面。

- 在数据开发主界面的左侧导航栏,选择。

- 单击“批作业监控”页签,进入批作业的监控页面。

- 单击作业名称,进入后单击作业节点。查看作业节点监控的详细信息。