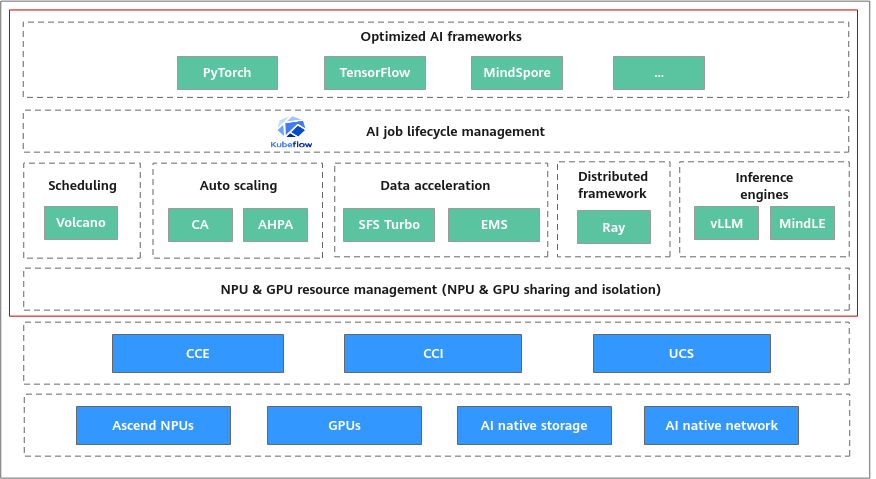

云原生AI套件概述

云原生AI套件以华为云CCE服务为基础,为您提供开箱即用的AI训练与推理全流程的解决方案,涵盖AI资源管理、AI负载调度、AI任务管理、AI数据加速及AI服务部署等服务,提供端到端的全栈支持与优化。

AI资源管理

CCE AI套件(NVIDIA GPU)和CCE AI套件(Ascend NPU)插件可以实现GPU、NPU、ROCE网卡等异构计算资源的标准化接入与高效调度,为AI、HPC等计算密集型负载提供底层硬件加速能力。

|

插件 |

描述 |

|---|---|

|

该插件是用于管理和调度NVIDIA GPU硬件资源的核心组件,由多个子模块协同工作,确保GPU设备能被容器化应用高效、安全地使用。其核心作用是将物理GPU资源抽象为CCE可调度的计算单元,并为AI训练、图形渲染等高性能负载提供完整的加速支持。同时,该插件提供GPU虚拟化技术,能够实现对硬件资源的灵活切分与动态管理,有效提高资源利用率。 |

|

|

该插件是用于管理和调度昇腾(Ascend)AI处理器的核心组件,与CloudMatrix生态深度结合,实现NPU设备上报、拓扑感知等核心功能,为AI训练/推理任务提供开箱即用的NPU加速能力。同时,支持NPU虚拟化,能够有效提升资源利用率。 |

AI负载调度

通过Volcano调度器,为AI负载提供作业调度、作业管理、队列管理等多项功能,支持优先级调度,拓扑感知调度,队列资源管理调度等多种高阶调度能力,能够有效减少各节点空闲资源碎片,提高集群资源利用率。

|

插件 |

描述 |

|---|---|

|

Volcano是CNCF孵化的高性能批量任务调度器,专为Kubernetes设计,支持AI训练、大数据处理等批处理作业的智能调度与资源优化,提供队列管理、任务优先级和弹性伸缩等高级能力,显著提升集群资源利用率和任务执行效率。 Volcano调度器插件区别于社区版本,其与CCE组件及CloudMatrix生态深度集成优化,在GPU、NPU虚拟化调度以及CloudMatrix网络拓扑感知等方面性能得到显著提升。 |

AI任务管理

CCE深度融合了Kubeflow和Kuberay两大云原生AI引擎,提供全面的AI开发支持,能够有效地管理AI任务的整个生命周期,提高资源利用率和任务执行效率。

|

插件 |

描述 |

|---|---|

|

该插件是基于Kubernetes的机器学习工作流编排系统,提供组件化、可扩展的AI流水线开发框架。其支持容器化部署TensorFlow/PyTorch等框架,实现数据预处理、模型训练、超参调优等环节的自动化串联,并提供高可靠、弹性伸缩的AI研发流水线,助力企业快速构建端到端的机器学习解决方案。 |

|

|

该插件是专为Kubernetes设计的Ray运算框架控制器,用于简化分布式AI任务部署,核心功能包括Ray集群自动化部署、节点资源隔离、弹性扩缩容及故障自愈。其与CCE集群无缝集成,用户可通过快速创建高可用Ray集群,实现大规模模型训练与实时推理,显著提升资源利用率与开发效率。 |

AI数据加速

AI数据加速引擎插件提供数据集抽象、数据编排和应用编排等能力,旨在通过透明的数据管理和优化调度,帮助AI和大数据应用高效利用任何存储的数据,而无需修改现有应用。

|

插件 |

描述 |

|---|---|

|

该插件作为数据加速引擎,通过声明式API实现数据缓存的自动化管理。其核心能力包括:

|

AI服务部署

AI推理框架插件、AI推理网关插件、kagent插件联合组成了AI服务部署的框架。其中,AI推理服务框架使用API一键式拉起推理实例,具备弹性负载均衡、弹性扩缩容等关键能力,保障推理服务在云原生环境下高效运行。利用AI推理框架部署的推理实例,可通过AI推理网关(AI Gateway)对外提供推理服务轻松应对高并发推理请求,确保服务稳定性和高效性,充分满足实际应用场景需求。同时,kagent插件可集成AI推理框架提供开箱即用的agent开发体验。

|

插件 |

描述 |

|---|---|

|

该插件是一款面向AI模型全生命周期管理的云原生插件,支持用户通过声明式API自定义注册、部署及调度AI大模型,并高效执行推理任务。 |

|

|

该插件是一个开源编程框架,将代理AI的强大功能引入云原生环境。kagent插件专为DevOps 和平台工程师构建,使AI代理能够直接在CCE集群中运行。 |

|

|

该插件是Kubernetes社区基于Gateway API推出的推理流量治理解决方案,可根据“模型名称”、“推理优先级”以及“模型版本”等AI业务属性,灵活地进行流量分发与灰度发布,以满足日益多样化的业务需求 |