使用ollama单机部署DeepSeek量化模型(Linux)

应用场景

量化是通过降低模型当中的参数精度,使得32位的浮点数转换成8位整数或者4位整数,实现模型的压缩和优化,从而降低模型的占用显存和算力,提高运行效率。但是精度会大量损失,通过量化模型我们可以减少显存的占用,提升计算效率,降低能耗,华为云为用户提供使用ollama来部署DeepSeek量化系列模型的详细步骤,帮助客户快速部署。

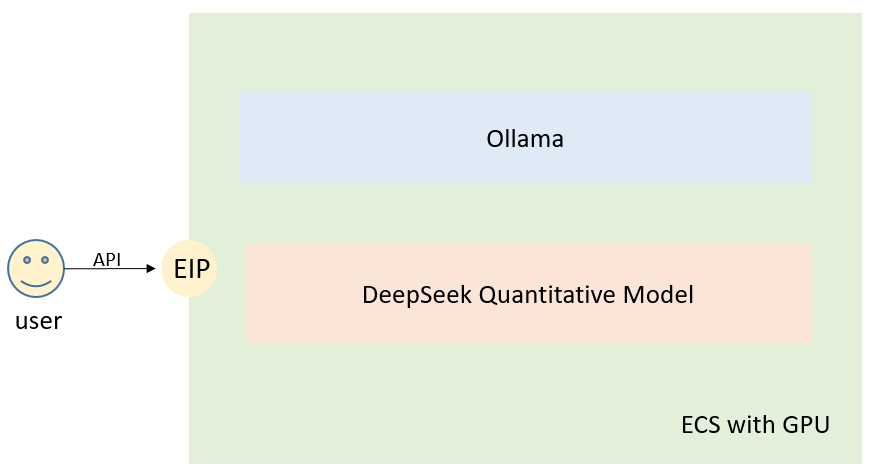

方案架构

方案优势

使用ollama从0开始部署DeepSeek蒸馏模型,深刻理解模型运行依赖,使用少量的资源,快速高效接入用户服务用于生产,实现更精细的性能和成本控制。

资源和成本规划

|

资源 |

资源说明 |

成本说明 |

|---|---|---|

|

虚拟私有云VPC |

VPC网段:192.168.0.0/16 |

免费 |

|

虚拟私有云子网 |

|

免费 |

|

安全组 |

入方向规则:

|

免费 |

|

弹性云服务器 |

|

ECS涉及以下几项费用:

具体的计费方式及标准请参考计费模式概述。 |

|

编号 |

模型名称 |

最小所需规格 |

GPU卡 |

|---|---|---|---|

|

0 |

deepseek-r1:7b deepseek-r1:8b |

p2s.2xlarge.8 |

V100(32G)*1 |

|

p2v.4xlarge.8 |

V100(16G)*1 |

||

|

pi2.4xlarge.4 |

T4(16G)*1 |

||

|

g6.18xlarge.7 |

T4(16G)*1 |

||

|

1 |

deepseek-r1:14b |

p2s.4xlarge.8 |

V100(32G)*1 |

|

p2v.8xlarge.8 |

V100(16G)*1 |

||

|

pi2.8xlarge.4 |

T4(16G)*1 |

||

|

2 |

deepseek-r1:32b |

p2s.8xlarge.8 |

V100(32G)*1 |

|

p2v.16xlarge.8 |

V100(16G)*2 |

||

|

3 |

deepseek-r1:70b |

p2s.16xlarge.8 |

V100(32G)*2 |

请联系华为云技术支持选择最适合您部署DeepSeek的GPU卡资源服务器。

基于ollama手动部署DeepSeek蒸馏模型步骤

Linux实例基于ollama手动部署DeepSeek量化版模型操作步骤如下:

实施步骤

- 创建GPU弹性云服务器。

- 镜像选择:建议选择华为云提供的GPU实例的未安装驱动的Huawei Cloud EulerOS 2.0/Ubuntu 22.04公共镜像。

图2 GPU实例镜像选择

- 需要创建EIP,方便依赖环境下载,方便调用模型接口进行推理。

- 镜像选择:建议选择华为云提供的GPU实例的未安装驱动的Huawei Cloud EulerOS 2.0/Ubuntu 22.04公共镜像。

- 驱动和CUDA的前置条件检查。

请参考手动安装GPU加速型ECS的Tesla驱动安装535版本驱动,12.2版本CUDA。

- 安装ollama。

- 执行以下命令,下载ollama安装脚本。

curl -fsSL https://ollama.com/install.sh -o ollama_install.sh chmod +x ollama_install.sh

- 执行以下命令,安装ollama。

sed -i 's|https://ollama.com/download/|https://github.com/ollama/ollama/releases/download/v0.5.7/|' ollama_install.sh sh ollama_install.sh

- 执行以下命令,下载ollama安装脚本。

- 下载大模型文件。

执行以下命令,按需下载对应的模型。

ollama pull deepseek-r1:7b ollama pull deepseek-r1:14b ollama pull deepseek-r1:32b ollama pull deepseek-r1:70b

- 使用ollama运行大模型。

执行以下命令,运行大模型。

ollama run deepseek-r1:7b ollama run deepseek-r1:14b ollama run deepseek-r1:32b ollama run deepseek-r1:70

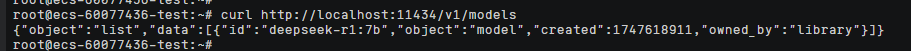

- 调用模型接口测试。ollama完全兼容OpenAI接口。

- 调用以下API查看当前运行的模型。

curl http://localhost:11434/v1/models

- 调用以下API进行聊天对话

curl http: //localhost:11434/api/chat -d '{"model": "deepseek-r1:7b","messages": [{"role": "user", "content": "hello!"}]}'

到此模型就部署完毕并验证正常,您可以在本地postman或者自己的服务里面使用EIP调用对应的API接口来对话。

- 调用以下API查看当前运行的模型。

相关操作

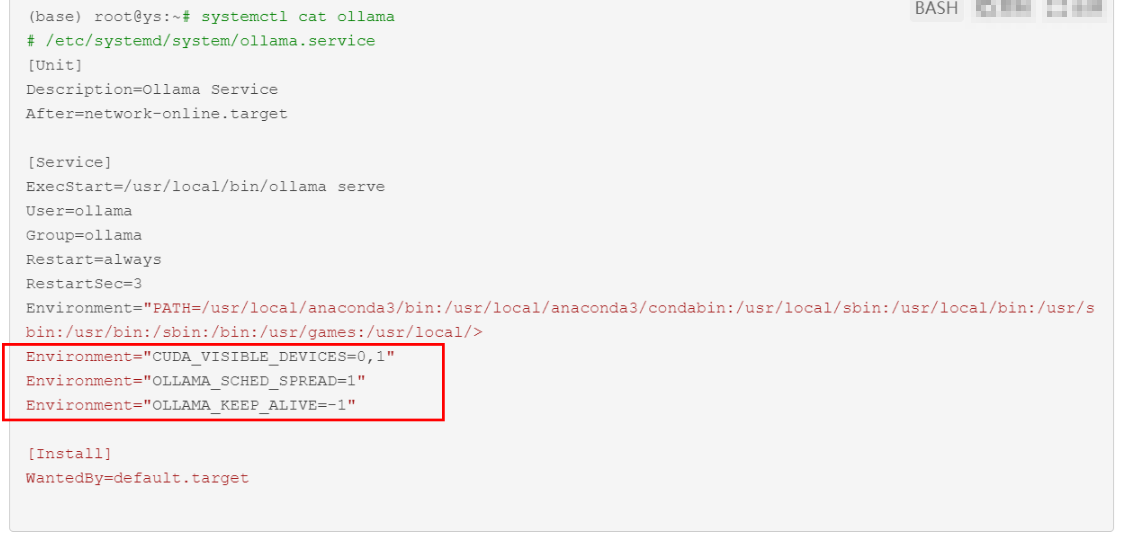

- 多卡运行需要执行以下命令,在ollama服务中添加以下参数,其中CUDA_VISIBLE_DEVICES设置使用的GPU编号。

vim /etc/systemd/system/ollama.service

- 执行以下命令,重启ollama服务。

systemctl daemon-reload systemctl stop ollama.service systemctl start ollama.service