文档首页/

AI开发平台ModelArts/

最佳实践/

LLM大语言模型推理/

LLM大语言模型推理历史版本文档/

主流开源大模型基于Lite Server&Cluster适配Ascend-vLLM PyTorch NPU推理指导(6.5.905)/

部署依赖包/

安装KubeInfer/

Cluster安装kubeinfer

更新时间:2025-08-20 GMT+08:00

Cluster安装kubeinfer

Cluster场景下需要安装kubeinfer。

步骤一:获取kubeInfer插件镜像

拉取插件镜像,建议使用官方提供的镜像部署。

crictl pull swr.cn-east-4.myhuaweicloud.com/atelier/modelarts-infers-operator:1.5.0.20250508155821

步骤二:部署KubeInfer

创建yaml文件用于部署kubeinfer,需要1个yaml文件,参考部署kubeinfer插件脚本。

- 执行如下命令创建目录,并把kubeinfer-crd.yaml放在scripts目录下。

cd /mnt/deepseek mkdir log mkdir scripts

- 执行如下命令创建pod。

cd /mnt/deepseek/scripts kubectl apply -f kubeinfer-crd.yaml

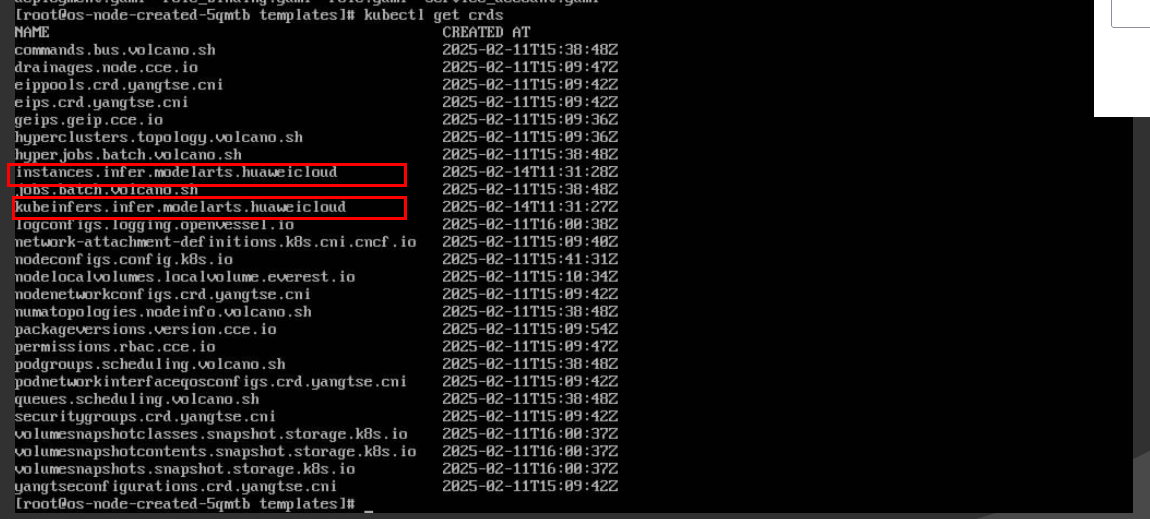

- 执行成功后,可执行如下命令查看CRD是否注册。

kubectl get crds | grep infer

如下图所示,打印'kubeinfers.infer.modelarts.huaweicloud'和'instances.infer.modelarts.huaweicloud'即为CRD注册成功。图1 查看CRD

父主题: 安装KubeInfer