Ascend-vLLM介绍

本文档介绍如何在ModelArts Lite Server和Lite Cluster环境中使用昇腾NPU资源部署基于Ascend-vLLM框架的主流开源大模型推理服务。

Ascend-vLLM概述

vLLM是GPU平台上广受欢迎的大模型推理框架,因其高效的continuous batching和pageAttention功能而备受青睐。此外,vLLM还具备投机推理和自动前缀缓存等关键功能,使其在学术界和工业界都得到了广泛应用。

Ascend-vLLM是华为云针对NPU优化的推理框架,继承了vLLM的优点,并通过特定优化实现了更高的性能和易用性。它使得在NPU卡上运行大模型变得更加高效和便捷,为用户带来了极大的便利和性能提升。Ascend-vLLM可广泛应用于各种大模型推理任务,特别是在需要高性能和高效率的场景中,如自然语言处理、图像生成和语音识别等。

Ascend-vLLM的主要特点

- 易用性:Ascend-vLLM简化了在大模型上的部署和推理过程,使开发者可以更轻松地使用它。

- 易开发性:提供了友好的开发和调试环境,便于模型的调整和优化。

- 高性能:通过自研特性和针对NPU的优化,如PD分离、前后处理、sample等,实现了高效的推理性能。

Ascend-vLLM架构

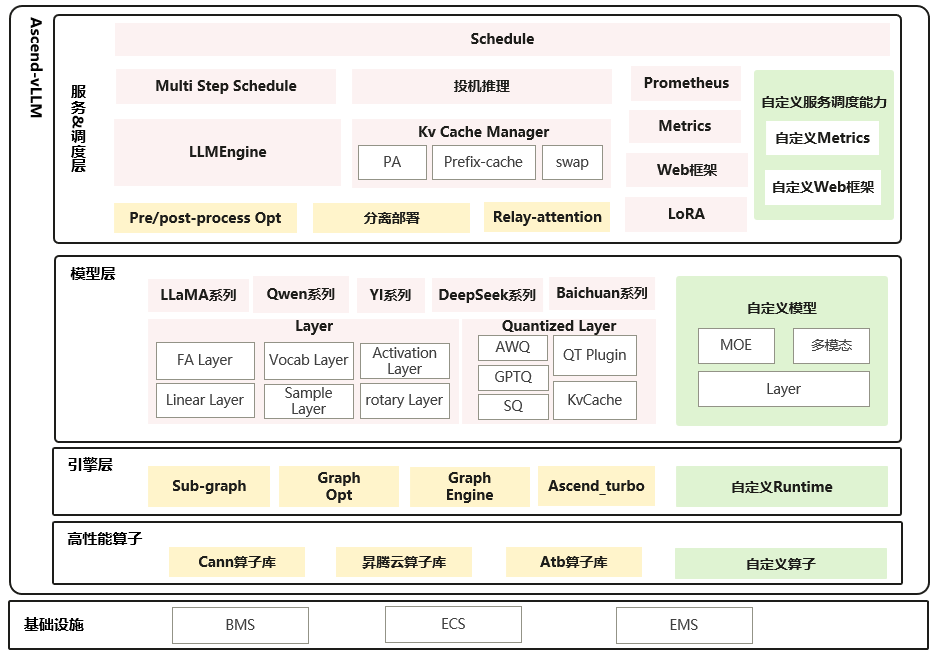

Ascend-vLLM架构图如下所示。

- 算子:使用CANN基础算子和高性能融合算子,同时支持用户自定义算子,持续迭代优化,提高推理效率。

- 模型:结构实现和社区一致,Huggingface模型开箱即用,同时可以快速适配新模型。

- 调用:提供高性能算子下发和图模式两种方案,兼顾性能和灵活性。

- 特性:服务调度、特性实现和社区一致,针对昇腾硬件做亲和替换和优化。

- 接口:离线SDK、在线OpenAI Server和社区完全一致,无缝迁移。