Ascend-vLLM推理常见问题

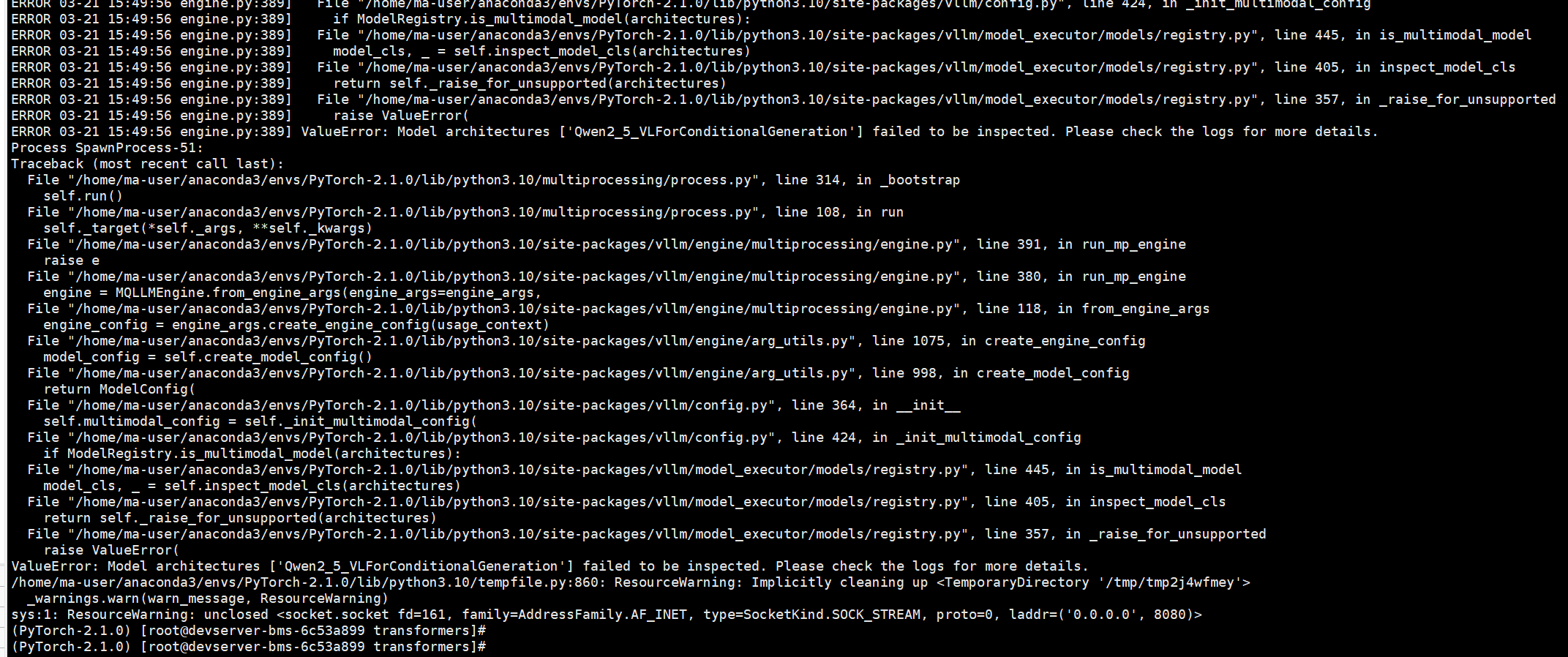

问题1:使用Qwen2.5-vl系列模型进行推理时报错

需使用特定版本的transformers。安装方式如下:

git clone https://github.com/huggingface/transformers cd transformers git checkout 1931a351408dbd1d0e2c4d6d7ee0eb5e8807d7bf pip install -e .

安装完成后的transformers版本为4.49.0.dev0。

问题2:在推理预测过程中遇到NPU out of memory

解决方法:调整推理服务启动时的显存利用率,将--gpu-memory-utilization的值调小。

问题3:在推理预测过程中遇到ValueError:User-specified max_model_len is greater than the drived max_model_len

解决方法:

修改config.json文件中的"seq_length"的值,"seq_length"需要大于等于 --max-model-len的值。config.json存在模型对应的路径下,例如:/data/nfs/benchmark/tokenizer/qwq-32b/config.json

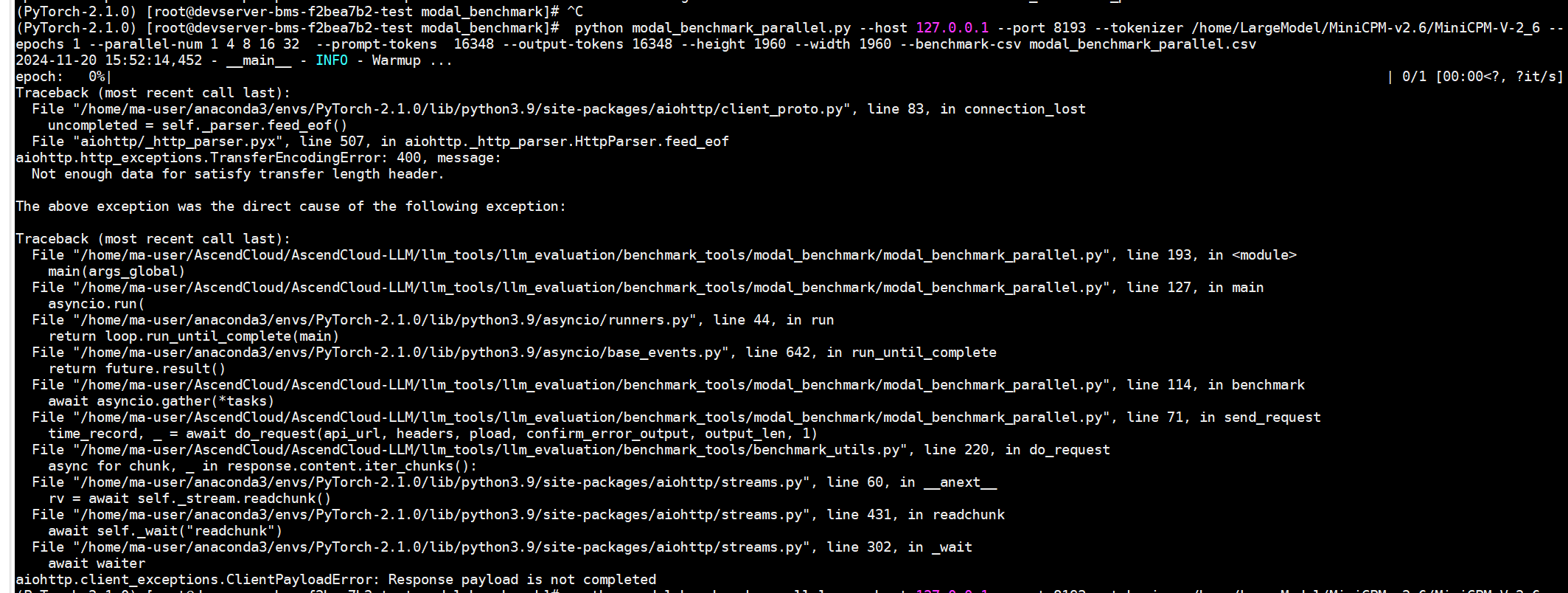

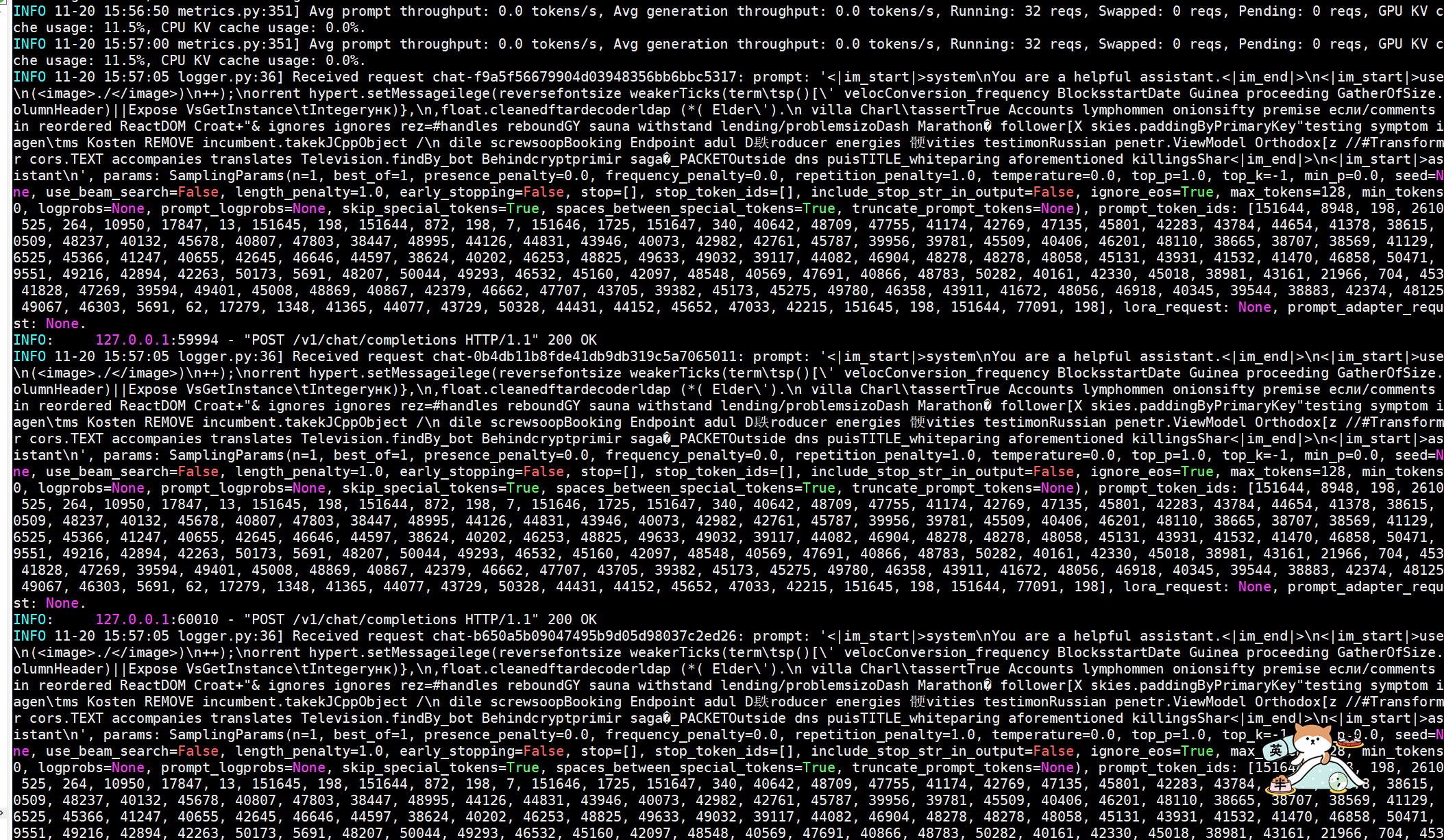

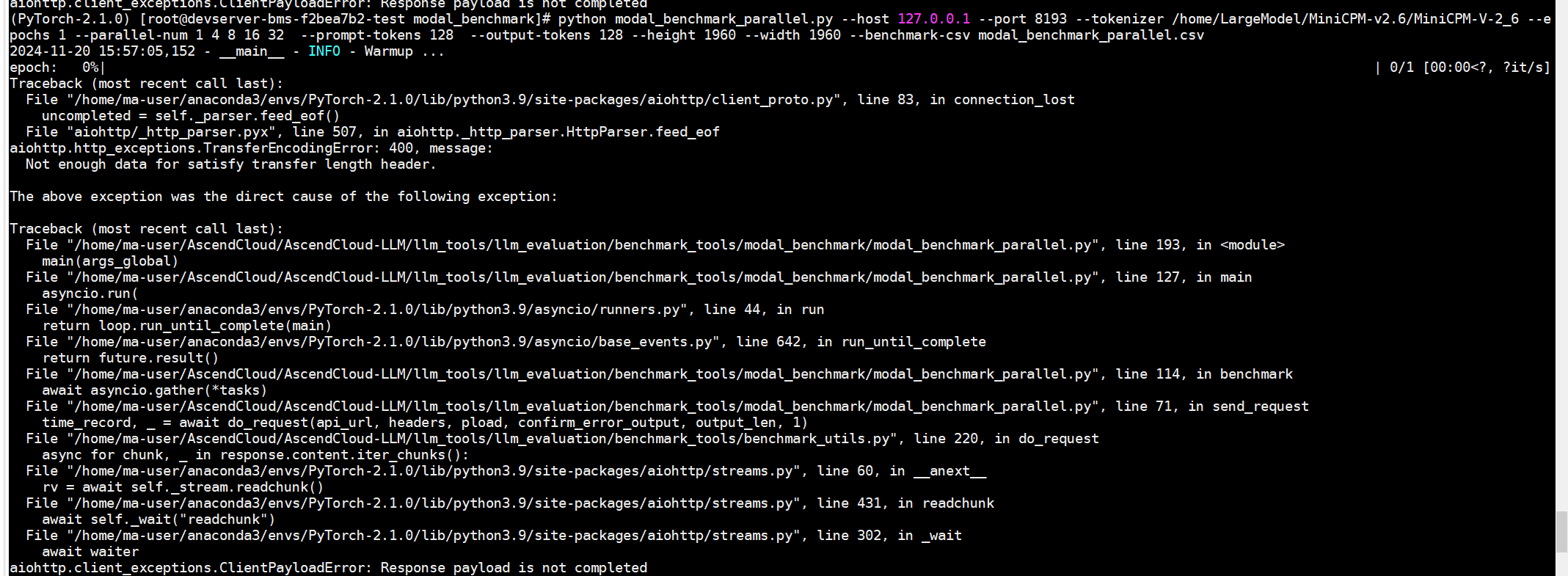

问题4:使用benchmark-tools访问推理服务返回报错

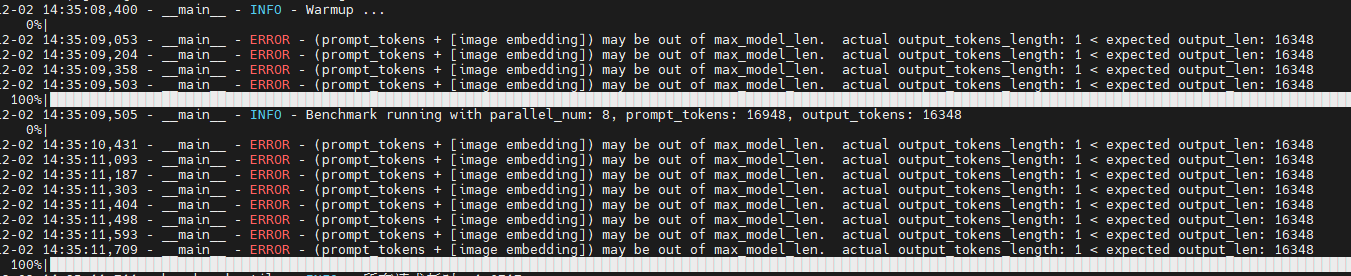

使用benchmark-tools访问推理服务时,输入输出的token和大于max_model_len,服务端返回报错Response payload is not completed,见图1。

再次设置输入输出的token和小于max_model_len访问推理服务,服务端响应200,见图2。

客户端仍返回报错Response payload is not completed,见图3。

解决方法:

安装brotlipy后返回正确报错

pip install brotlipy

问题5:使用benchmark-tools访问推理客户端返回报错或警告

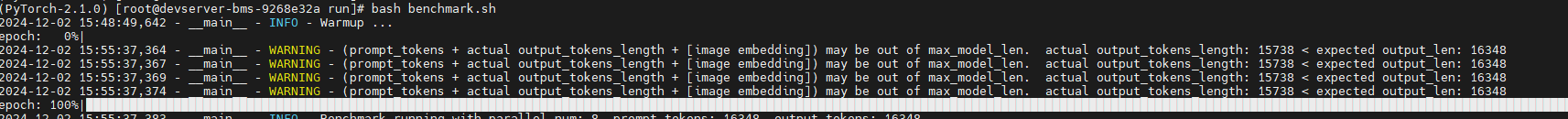

使用benchmark-tools访问推理客户端返回报错或警告:actual output_tokens_length < expected output_len

解决方法:

减少参数--prompt-tokens和--output-tokens的值,或者增大启动服务的参数--max-model-len的值。

问题6:使用离线推理时,性能较差或精度异常

解决方法:将block_size大小设置为128

from vllm import LLM, SamplingParams llm = LLM(model="facebook/opt-125m", block_size=128)