使用FunctionGraph部署DeepSeek-R1蒸馏模型

方案概述

DeepSeek-R1模型是深度求索公司推出的首款推理模型,基于DeepSeek-V3-Base模型,通过知识蒸馏技术优化,旨在以较低的计算资源实现高性能,支持快速部署与运行。

FunctionGraph应用中心提供DeepSeek-R1蒸馏模型的部署解决方案,支持多种模型参数规模选择(包括1.5B、7B、8B、14B和32B参数版本)。该方案基于FunctionGraph的全托管计算服务,您无需关注底层资源管理,即可通过标准API接口快速实现模型部署。搭配第三方客户端,可轻松构建AI对话应用,实现从模型托管到AI对话的应用。

约束与限制

函数需创建在“华东-上海一”区域下。

操作视频

本视频介绍使用FunctionGraph部署DeepSeek-R1蒸馏模型的操作流程。

资源和成本规划

表1介绍使用FunctionGraph函数,部署DeepSeek-R1蒸馏模型所需的资源和成本规划。

|

资源 |

资源说明 |

计费说明 |

|---|---|---|

|

函数工作流 FunctionGraph |

|

|

|

API网关 APIG |

|

|

操作流程

表2介绍通过FunctionGraph,部署DeepSeek-R1蒸馏模型的总体操作流程。

|

操作流程 |

说明 |

|---|---|

|

通过API网关控制台,购买APIG专享版实例,并配置公网入口访问。 |

|

|

通过FunctionGraph应用中心,创建DeepSeek-R1蒸馏模型应用。 如需自定义构建镜像,可参考附录:镜像构建Dockerfile参考进行操作。 |

|

|

下载并配置第三方客户端,部署DeepSeek-R1蒸馏模型开始AI对话,可选择以下任一客户端进行部署: |

步骤一:购买专享版APIG实例

登录API网关控制台,参考购买专享版APIG实例购买一个名为“apig-fg”的专享版APIG实例。

- 区域:选择华东-上海一。

- 公网入口:本例需“开启公网入口”,请根据实际需求选择入公网带宽。

- VPC和子网:本示例供测试使用,无需配置函数访问VPC内资源,因此可自行配置VPC和子网参数。

如生产环境中使用,请配置VPC内的公网访问,并将APIG实例和函数配置在同一VPC环境下。

- 安全组:开启公网入口,安全组入方向需要放开80(HTTP)和443(HTTPS)端口的访问权限。

步骤二:创建DeepSeek应用

- 登录函数工作流控制台,区域选择“华东-上海一”。

- 在左侧导航栏中选择“函数 > 应用中心”,单击“创建应用”进入选择模板界面。

- 找到“DeepSeek R1推理模型”模板,单击“使用模板”。

图1 创建DeepSeek应用模板

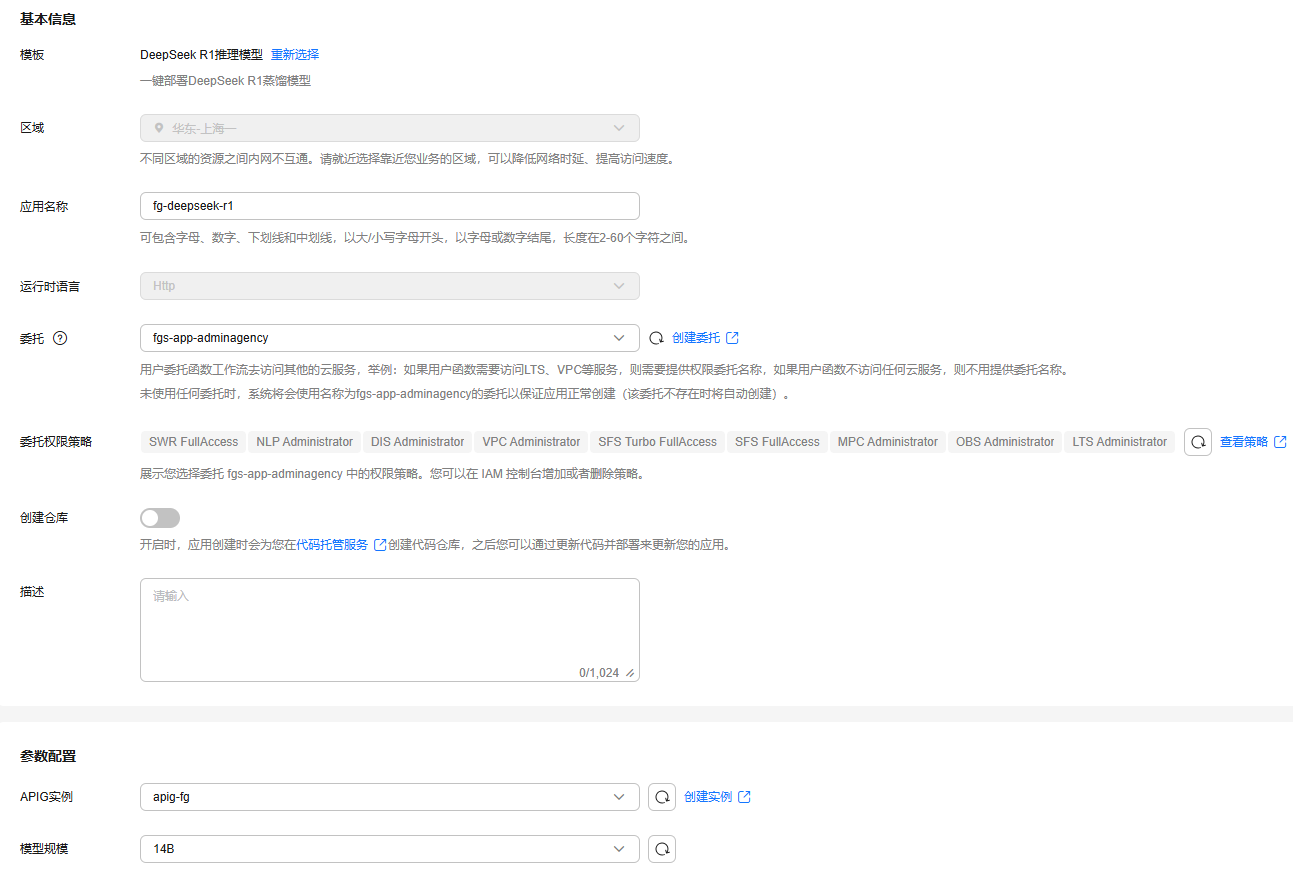

- 进入创建应用界面,参考表3填写应用参数。

图2 创建应用

表3 创建应用参数说明 参数

取值样例

说明

模板

DeepSeek R1推理模型

本案例使用DeepSeek R1推理模型应用模板创建应用。

区域

华东-上海一

选择应用部署的区域。

应用名称

fg-deepseek-r1

自定义填写应用的名称。可包含字母、数字、下划线和中划线,以大小写字母开头,以字母或数字结尾,长度不超过60个字符。

运行时语言

Http

本应用默认内置Http运行时语言,不可更改。

委托

fgs-app-adminagency

选择应用需使用的委托。

“fgs-app-adminagency”为FunctionGraph应用中心的默认委托。如未创建过该委托,可先将该参数选择为“未使用任何委托”,在创建应用时系统会弹出创建该应用中心默认委托的选项,单击创建即可。

创建仓库

不开启

若开启,应用创建时将会为您在代码托管服务创建代码仓库,之后可通过更新代码并部署来更新您的应用。

描述

-

自定义填写应用的描述,最长支持填写1024个字符。

APIG实例

apig-fg

选择步骤一:购买专享版APIG实例购买的APIG实例。

模型规模

14B

自定义选择DeepSeek R1模型的规模,涵盖1.5B、7B、8B、14B和32B模型供您选择。

- 填写完成后,单击右下角“立即创建”,进入应用详情页等待应用创建成功。

如“委托”参数选择了“未使用任何委托”,此处将会弹出创建“fgs-app-adminagency”委托的提示,单击创建即可。

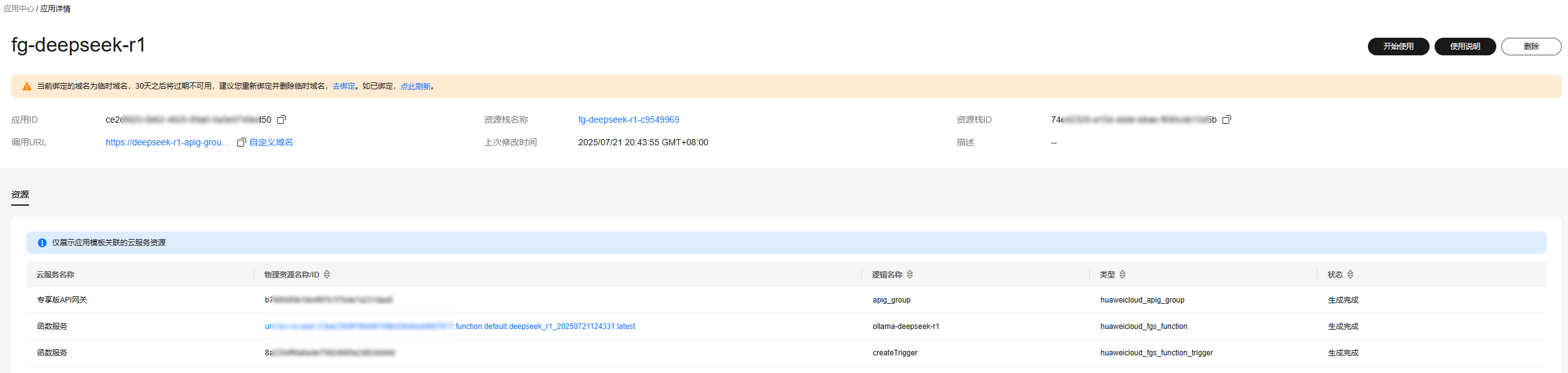

- 应用创建成功后如图3所示,会自动为您生成函数和API网关资源,其中生成的函数资源已开启GPU。

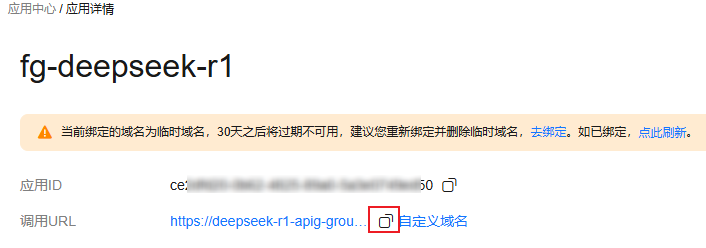

- 如图4所示复制应用的“调用URL”备用。

为方便快速体验,应用中心会为您分配一个临时域名,此临时域名仅可用于测试使用,有效期30天。若想开放应用长期访问,需在应用总览页面的域名提示信息中单击“去绑定”为应用绑定自定义域名,具体操作方案请参考配置API的调用域名。

附录:镜像构建Dockerfile参考

如需自定义构建镜像,可参考以下Dockerfile进行操作。

FROM nvidia/cuda:11.6.2-base-ubuntu20.04

ENV HOME=/home/paas

ENV GROUP_ID=1003

ENV GROUP_NAME=paas_user

ENV USER_ID=1003

ENV USER_NAME=paas_user

ENV OLLAMA_HOST=0.0.0.0:8000

RUN mkdir -m 550 ${HOME} && groupadd -g ${GROUP_ID} ${GROUP_NAME} && useradd -u ${USER_ID} -g ${GROUP_ID} ${USER_NAME}

RUN apt-get update && apt-get install -y --no-install-recommends curl && rm -rf /var/lib/apt/lists/*

RUN curl -fsSL https://ollama.com/install.sh | sh

RUN chown -R ${USER_ID}:${GROUP_ID} ${HOME}

RUN find ${HOME} -type d | xargs chmod 775

RUN ollama serve & \

sleep 15 && \

ollama pull deepseek-r1:14B

USER ${USER_NAME}

WORKDIR ${HOME}

EXPOSE 8000

ENTRYPOINT ["ollama", "serve"]

免责声明

- 本应用使用到的Ollama和DeepSeek-R1等项目均为社区开源项目,华为云仅提供算力支持。

- 本应用仅作为简单案例供用户参考和学习使用,如果用于实际生产环境,请参考附录:镜像构建Dockerfile参考的镜像构建工程自行完善和优化;使用过程中出现的函数工作流的问题,可以通过工单进行咨询,关于开源项目的问题需到开源社区寻求帮助或者自行解决。

- 本应用部署后会为您创建APIG网关,根据有关规定,请在应用创建成功后根据提示绑定自定义域名后,使用您的自有域名访问应用。