更新时间:2024-05-21 GMT+08:00

DLI

操作场景

基于数据湖探索(Data Lake Insight,简称DLI)服务的数据集。

前提条件

连接的数据源已创建,如何创建请参见DLI数据源。

在DLI构建数据

- 登录DLI服务控制台。

- 参考创建并提交Spark SQL作业中操作,创建队列、数据库和表。

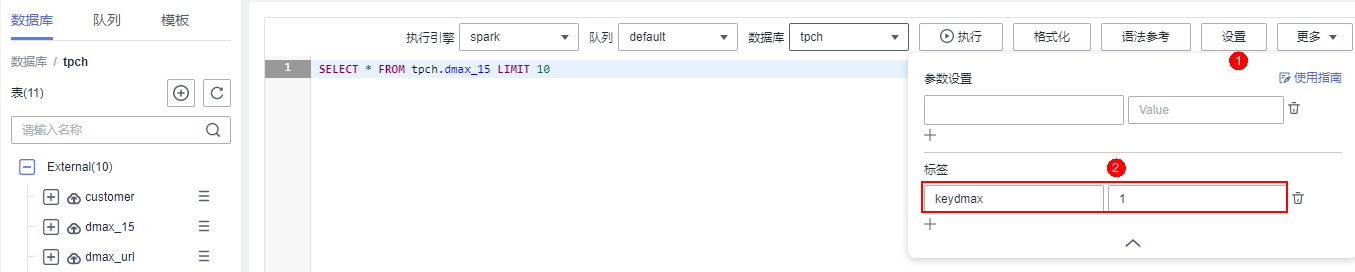

例如,创建了数据库tpch,且数据库中预置了所需的表。

图1 tpch数据库

- 单击已创建的数据库tpch,进入tpch数据库。

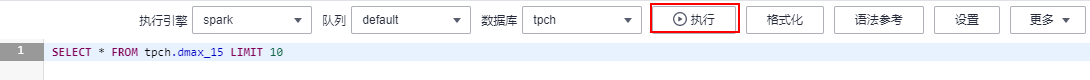

- (可选)双击对应的表,右侧会显示对应的查询语句,单击“设置”,添加标签。

为作业添加标签后,在AstroCanvas中可通过标签识别到是具体哪个作业的执行结果。如果不设置标签,默认识别到最新作业的执行结果。图2 设置标签

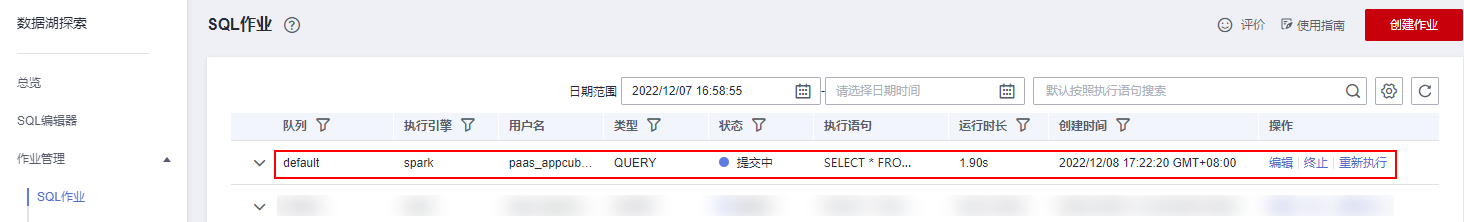

- 单击“执行”,构建数据。

图3 构建数据

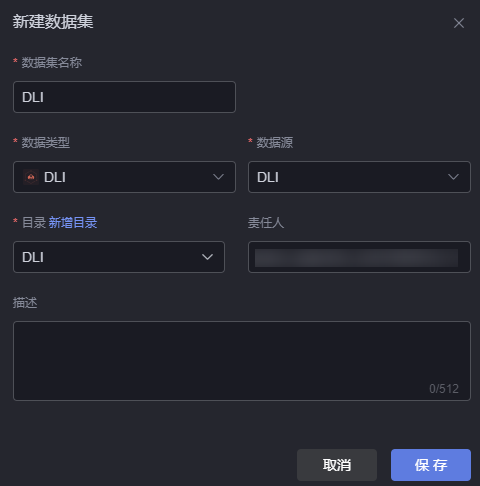

- 在左侧导航栏中,选择,查看构建结果。

图4 查看构建结果

创建DLI数据集

- 参考如何登录AstroCanvas中操作,登录AstroCanvas界面。

- 在主菜单中,选择“数据中心”。

- 在左侧导航栏中,选择“数据集 > 全部”。

- 在数据集管理页面,单击“新建数据集”。

- 在新增数据集页面,设置数据集名称、选择数据类型、数据源和目录,单击“保存”。

图5 新建数据集

- 配置数据集参数。

- 标签:SQL作业的标签。单击“标签”后的“展开”,设置标签的键“key”和标签的值“value”,即在DLI构建数据中设置的标签。

- 设置标签:从设置标签的SQL作业中,获取数据(48小时内的数据,作业超过48小时会过期)。

- 不设置标签,默认从最后执行的作业中获取数据。

- 刷新数据:单击该按钮,可预览数据。

- 标签:SQL作业的标签。单击“标签”后的“展开”,设置标签的键“key”和标签的值“value”,即在DLI构建数据中设置的标签。

- 单击“保存”,完成DLI数据集的创建。