模型服务介绍

模型服务分类

为满足不同用户的技术能力、业务场景及需求,AI原生应用引擎提供了多样化的模型服务模式。以下从模型来源、部署方式等维度对各类模型服务进行介绍,具体如表1所示。

|

分类 |

特征 |

典型模型 |

使用流程 |

|---|---|---|---|

|

平台接入的第三方厂商模型服务 |

由第三方厂商部署,平台接入厂商提供的模型服务API。 |

DeepSeek系列、Qwen系列。 |

|

|

平台预置的模型服务 |

平台已完成了模型的部署,提供模型服务API。 |

bge-reranker-large(文本排序)、bge-large-zh-v1.5(文本向量化)、whisper-large-v3(语音转文本) |

|

|

用户自主接入的模型服务 |

由用户或第三方部署在外部环境,平台调用外部已存在的模型服务API。 |

/ |

|

|

用户自主部署的模型服务 |

|

平台提供的开源模型:Qwen、DeepSeek Coder、DeepSeek-R1-Distill-Qwen模型系列等。 |

了解平台资产中心的大模型

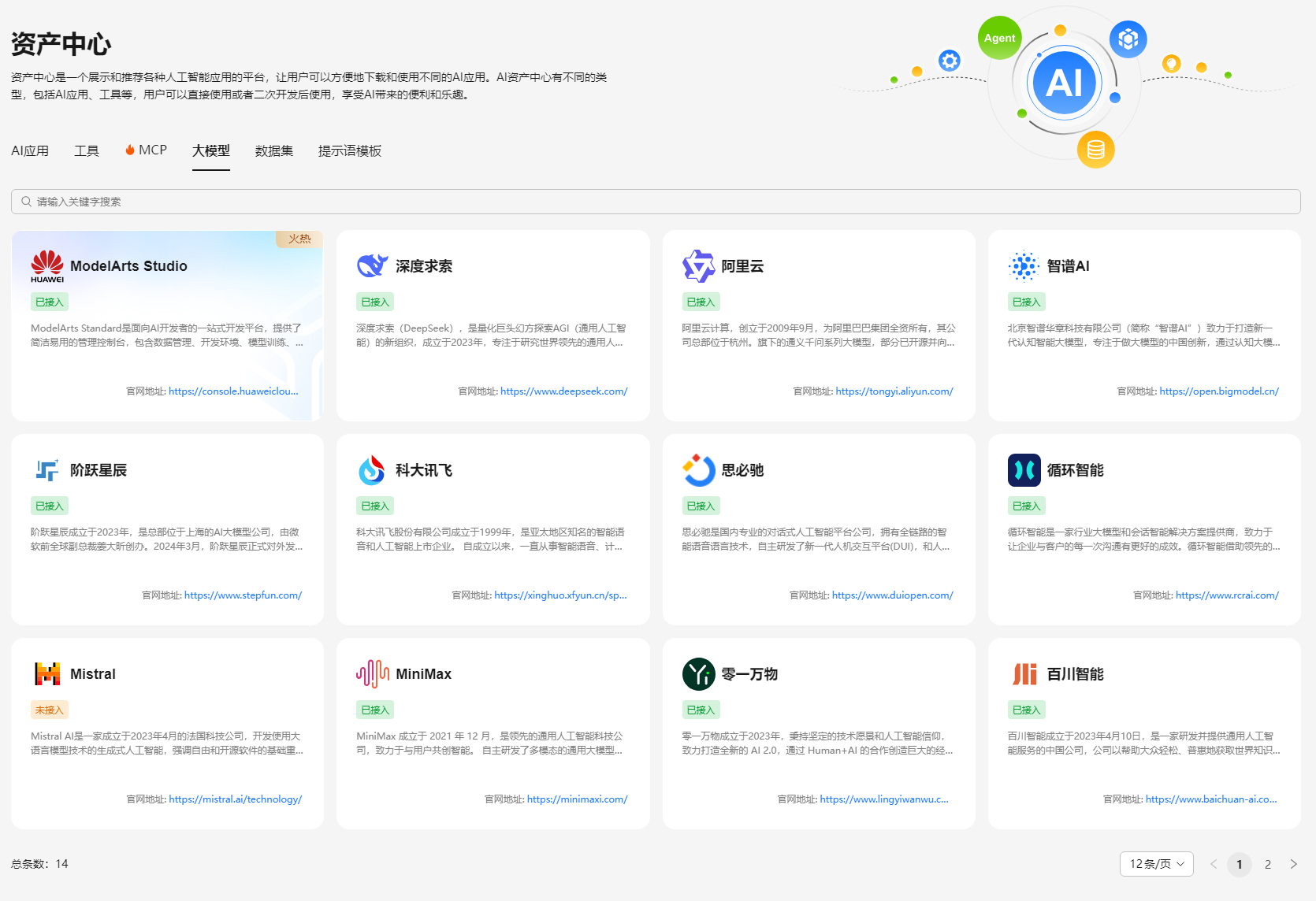

AI原生应用引擎的资产中心,展示模型供应商信息,您可以在AI原生应用引擎的左侧导航栏选择“资产中心”,选择“大模型”页签进行查看。如图1所示。

在搜索区域,支持输入供应商中英文名称/供应商描述关键字进行搜索。

模型供应商卡片上,提供了“配置鉴权”入口。

单击模型供应商卡片,可以查看接入模型信息,并且可以对已接入模型进行调测。