创建元数据连接

创建元数据来源类型的连接,获取源端大数据库表清单。

目前支持的连接类型,参见表1。

|

类别 |

连接类型 |

|---|---|

|

大数据组件 |

|

|

大数据云服务 |

|

- 在创建Hive Metastore连接前,需要先获取连接Hive Metastore的IP地址和端口号。

- 在创建MaxCompute连接前,需要先获取MaxCompute服务所在地域的Endpoint信息。

- 在创建Doris连接前,需要先获取Doris集群部署的服务器IP地址和端口。

- 在创建HBase连接前,需要先获取HBase集群中至少一个ZooKeeper节点的IP地址和连接端口。

前提条件

已在源端环境中部署MgC Agent。

操作步骤

- 登录迁移中心管理控制台。在左侧导航栏的项目下拉列表中选择创建的大数据迁移项目。

- 在左侧导航栏选择“迁移准备”,进入迁移准备页面。

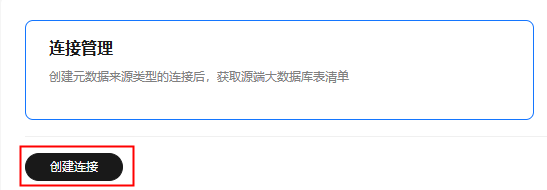

- 单击“创建连接”,右侧弹出新增连接窗口。

图1 创建连接

- 选择连接类型,单击“下一步”,进入详细配置页面。

- 根据所选的连接类型,查看对应的参数配置说明,配置连接参数。

- Hive Metastore连接参数配置说明

- Doris连接参数配置说明

- HBase连接参数配置说明

- ClickHouse组件参数配置说明

- DLI服务参数配置说明

- CloudTable(ClickHouse)服务参数配置说明

- CloudTable(HBase)服务参数配置说明

- Delta Lake(有元数据)连接参数配置说明

- Delta Lake(无元数据)连接参数配置说明

- Hudi(有元数据)连接参数配置说明

- Hudi(无元数据)连接参数配置说明

- MaxCompute连接参数配置说明

- Lindorm连接参数配置说明

- 阿里云云数据库ClickHouse连接参数配置说明

表2 Hive Metastore连接参数配置说明 参数

配置说明

所属源

根据实际需求选择。

连接名称

默认创建名称为“Hive-Metastore-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

启用安全连接

选择是否启用安全连接。

- MetaStore在非安全集群下,可以不启用安全连接。

- MetaStore在安全集群下,需要启用安全连接并选择凭证。凭证的获取以及添加方法请参考添加资源凭证中的大数据-Hive Metastore。

Hive版本

选择源端Hive的实际版本。

注意:如果源端Hive为2.1.1版本,此处需要选择1.x版本。

MetaStore节点IP

填写连接MetaStore的IP地址。

MetaStore Thrift服务端口

填写连接MetaStore的端口,默认为9083。

启用元数据仓连接

在增量数据校验中,如果通过Metastore查询,当分区数量超过30,000时,可能会因为将所有分区信息加载到内存中而导致内存溢出(OOM)。因此,使用MySQL作为元数据仓可以有效地解决这一问题。

- 不启用:系统通过MetaStore查询Hive表的分区信息。

- 启用:配置MySQL作为元数据仓,系统将通过MySQL查询Hive表的分区信息。启用后,需要配置如下参数:

- 元仓类型:目前仅支持MySQL作为元数据仓。

- MySQL凭证:选择访问MySQL数据库的认证信息。认证信息需要添加到MgC Agent然后同步到MgC,方法请参考添加资源凭证。

- MySQL节点IP:输入MySQL数据库服务器的IP地址。

- MySQL服务端口:输入MySQL数据库服务的端口号。

- 数据库名:输入存储Hive表元数据的数据库名称。

说明:请确保填写的MySQL凭证、节点IP、服务端口和数据库名与Hive实际使用的MySQL数据库相匹配,否则会导致数据校验失败。

表3 Doris连接参数配置说明 参数

配置说明

所属源

根据实际需求选择。

连接名称

默认创建名称为“Doris-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

Doris凭证

选择在MgC Agent添加的Doris凭证。凭证的添加方式请参考添加资源凭证,类型选择“大数据-Doris”。

数据库地址

填写连接到Doris集群部署的服务器IP地址。

数据库端口

填写连接到Doris集群部署的服务器的端口。默认为3306。

数据库名

填写Doris数据库名称。

采集资源使用信息

可选参数。开启后,通过该连接创建的统计任务将收集大数据服务的资源使用信息,这些信息将用于MgC上的报告生成,以便于进行性能优化。

须知:使用该功能,需要MgC Agent添加的华为云账号AK/SK拥有MRS服务和DLI服务的只读权限(ReadOnly)。

- 如果所选凭证与登录迁移中心 MgC的账号凭证相同,请勾选“所选凭证与登录迁移中心凭证相同”,系统将根据所选的区域,自动查询账号在该区域下的项目。

- 区域:选择需要校验的数据所在区域/项目。

- 项目:选择需要校验的数据所在项目。

- 集群ID:输入需要校验的数据所在集群ID。

- 如果所选凭证与登录迁移中心 MgC的账号凭证不同,请手动输入如下参数信息:

- 区域ID:输入需要校验的数据所在区域ID。例如,区域为“华南-广州”,则输入“cn-south-1”

- 项目ID:输入与区域对应的项目ID。

- 集群ID:输入需要校验的数据所在集群ID。

表4 HBase连接参数配置说明 参数

配置说明

所属源

根据实际需求选择。

连接名称

默认创建名称为“HBase-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

注意:需要在安装MgC Agent的主机上配置/etc/hosts后,HBase元数据连接才能连接成功。host文件的获取方法请参见准备开发和运行环境。

HBase凭证

选择在MgC Agent添加的HBase凭证。凭证的添加方式请参考添加资源凭证,类型选择“大数据-HBase”。

安全集群

选择是否部署在安全集群下。

Zookeeper节点IP

填写连接到Zookeeper的IP地址。通常是部署Zookeeper的服务器公网IP地址或内网IP地址。

Zookeeper连接端口

填写连接到Zookeeper的端口。

HBase 版本

选择HBase的版本。

采集资源使用信息

可选参数。开启后,通过该连接创建的统计任务将收集大数据服务的资源使用信息,这些信息将用于MgC上的报告生成,以便于进行性能优化。

须知:使用该功能,需要MgC Agent添加的华为云账号AK/SK拥有MRS服务和DLI服务的只读权限(ReadOnly)。

- 如果所选凭证与登录迁移中心 MgC的账号凭证相同,请勾选“所选凭证与登录迁移中心凭证相同”,系统将根据所选的区域,自动查询账号在该区域下的项目。

- 区域:选择需要校验的数据所在区域/项目。

- 项目:选择需要校验的数据所在项目。

- 集群ID:输入需要校验的数据所在集群ID。

- 如果所选凭证与登录迁移中心 MgC的账号凭证不同,请手动输入如下参数信息:

- 区域ID:输入需要校验的数据所在区域ID。例如,区域为“华南-广州”,则输入“cn-south-1”

- 项目ID:输入与区域对应的项目ID。

- 集群ID:输入需要校验的数据所在集群ID。

表5 ClickHouse连接参数配置说明 参数

配置说明

所属源

根据实际需求选择。

连接名称

默认创建名称为“ClickHouse-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

ClickHouse凭证(可选)

选择在MgC Agent添加的ClickHouse凭证。凭证的添加方法请参考添加资源凭证中的大数据-ClickHouse。

安全集群

选择是否部署在安全集群下。

ClickHouse Server IP

填写连接到ClickHouse服务器的IP地址。通常是运行ClickHouse的主机IP地址。

HTTP端口

非安全集群下,与ClickHouse 服务器通信的 HTTP 端口。默认为8123。

HTTP SSL/TLS端口

安全集群下,与ClickHouse 服务器通信的HTTPS 端口。

表6 DLI服务参数配置说明 参数

配置说明

所属源

选择目的端。

连接名称

默认创建名称为“DLI-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

DLI凭证

选择DLI云服务的凭证。凭证的添加方法请参考添加资源凭证中的大数据-DLI。如果所选凭证与登录迁移中心账号凭证相同,请勾选“所选凭证与登录迁移中心凭证相同”,系统将根据所选的区域,自动查询账号在该区域下的项目。

区域ID

输入需要校验的数据(即目的端数据)所在区域的代码。例如:ap-southeast-1。可以参考终端节点获取不同区域的区域代码信息。

项目ID

输入需要校验的数据所在的项目ID。获取方法请参考获取项目的名称和ID。

队列名称

输入需要进行校验的DLI队列名称。队列类型必须是SQL队列。

采集资源使用信息

可选参数。开启后,通过该连接创建的统计任务将收集大数据服务的资源使用信息,这些信息将用于MgC上的报告生成,以便于进行性能优化。

须知:使用该功能,需要MgC Agent添加的华为云账号AK/SK拥有MRS服务和DLI服务的只读权限(ReadOnly)。

表7 CloudTable(ClickHouse)服务参数配置说明 参数

配置说明

所属源

选择目的端。

连接名称

默认创建名称为“CloudTable-ClickHouse-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

CloudTable(ClickHouse)凭证

选择CloudTable(ClickHouse)集群的凭证。凭证的添加方法请参考添加资源凭证中的大数据-ClickHouse。认证方式选择“用户名/密码”,填写在CloudTable服务创建的目的端ClickHouse集群的登录用户名和密码。

数据库链接

填写连接到CloudTable(ClickHouse)的数据库链接地址。可以在ClickHouse集群的基本信息获取,对应参数为“集群访问地址”。

表8 CloudTable(HBase)服务参数配置说明 参数

配置说明

所属源

选择目的端。

连接名称

默认创建名称为“CloudTable-HBase-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

CloudTable(HBase)凭证

非安全集群,无需凭证。

安全集群

当前仅支持非安全集群(普通集群)。

数据库链接

填写连接到CloudTable(HBase)的数据库链接地址。可以在HBase集群的基本信息获取,对应参数为“ZK链接地址(内网)”。

表9 Delta Lake(有元数据)连接参数配置说明 参数

配置说明

所属源

仅需在源端创建元数据连接。

连接名称

默认创建名称为“Delta-Lake-有元数据-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

执行机凭证

选择执行机的登录凭证。凭证的添加方法请参考添加资源凭证中的大数据-执行机。

执行机IP

填写连接执行机的IP地址。

执行机连接端口

填写连接执行机的端口。

Spark客户端目录

填写Spark客户端的安装目录路径。

环境变量地址

填写环境变量文件(配置文件)的绝对路径,例如:/opt/bigdata/client/bigdata_env。

SQL文件地址

填写用于存放执行作业时生成的SQL文件的文件夹地址。您需要拥有该文件夹的读写权限。

须知:迁移完成后,您需要手动清理该路径下生成的文件夹,以释放存储空间。

表10 Delta Lake(无元数据)连接参数配置说明 参数

配置说明

所属源

仅需在源端创建元数据连接。

连接名称

默认创建名称为“Delta-Lake-无元数据-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

执行机凭证

选择执行机的登录凭证。凭证的添加方法请参考添加资源凭证中的大数据-执行机。

执行机IP

填写连接执行机的IP地址。

执行机连接端口

填写连接执行机的端口。

Spark客户端目录

填写Spark客户端的安装目录路径。

环境变量地址

填写环境变量文件(配置文件)的绝对路径,例如:/opt/bigdata/client/bigdata_env。

SQL文件地址

填写用于存放执行作业时生成的SQL文件的文件夹地址。您需要拥有该文件夹的读写权限。

须知:迁移完成后,您需要手动清理该路径下生成的文件夹,以释放存储空间。

采集资源使用信息

可选参数。开启后,通过该连接创建的统计任务将收集大数据服务的资源使用信息,这些信息将用于MgC上的报告生成,以便于进行性能优化。

须知:使用该功能,需要MgC Agent添加的华为云账号AK/SK拥有MRS服务和DLI服务的只读权限(ReadOnly)。

- 如果所选凭证与登录迁移中心 MgC的账号凭证相同,请勾选“所选凭证与登录迁移中心凭证相同”,系统将根据所选的区域,自动查询账号在该区域下的项目。

- 区域:选择需要校验的数据所在区域/项目。

- 项目:选择需要校验的数据所在项目。

- 集群ID:输入需要校验的数据所在集群ID。

- 如果所选凭证与登录迁移中心 MgC的账号凭证不同,请手动输入如下参数信息:

- 区域ID:输入需要校验的数据所在区域ID。例如,区域为“华南-广州”,则输入“cn-south-1”

- 项目ID:输入与区域对应的项目ID。

- 集群ID:输入需要校验的数据所在集群ID。

表11 Hudi(有元数据)连接参数配置说明 参数

配置说明

所属源

仅需在源端创建元数据连接。

连接名称

默认创建名称为“Hudi-有元数据-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

执行机凭证

选择执行机的登录凭证。凭证的添加方法请参考添加资源凭证中的大数据-执行机。

执行机IP

填写连接执行机的IP地址。

执行机连接端口

填写连接执行机的端口。

Spark客户端目录

填写Spark客户端的安装目录路径。

环境变量地址

填写环境变量文件(配置文件)的绝对路径,例如:/opt/bigdata/client/bigdata_env。

SQL文件地址

填写用于存放执行作业时生成的SQL文件的文件夹地址。您需要拥有该文件夹的读写权限。

须知:迁移完成后,您需要手动清理该路径下生成的文件夹,以释放存储空间。

表12 Hudi(无元数据)连接参数配置说明 参数

配置说明

所属源

仅需在源端创建元数据连接。

连接名称

默认创建名称为“Hudi-无元数据-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

执行机凭证

选择执行机的登录凭证。凭证的添加方法请参考添加资源凭证中的大数据-执行机。

执行机IP

填写连接执行机的IP地址。

执行机连接端口

填写连接执行机的端口。

Spark客户端目录

填写Spark客户端的安装目录路径。

环境变量地址

填写环境变量文件(配置文件)的绝对路径,例如:/opt/bigdata/client/bigdata_env。

SQL文件地址

填写用于存放执行作业时生成的SQL文件的文件夹地址。您需要拥有该文件夹的读写权限。

须知:迁移完成后,您需要手动清理该路径下生成的文件夹,以释放存储空间。

采集资源使用信息

可选参数。开启后,通过该连接创建的统计任务将收集大数据服务的资源使用信息,这些信息将用于MgC上的报告生成,以便于进行性能优化。

须知:使用该功能,需要MgC Agent添加的华为云账号AK/SK拥有MRS服务和DLI服务的只读权限(ReadOnly)。

- 如果所选凭证与登录迁移中心 MgC的账号凭证相同,请勾选“所选凭证与登录迁移中心凭证相同”,系统将根据所选的区域,自动查询账号在该区域下的项目。

- 区域:选择需要校验的数据所在区域/项目。

- 项目:选择需要校验的数据所在项目。

- 集群ID:输入需要校验的数据所在集群ID。

- 如果所选凭证与登录迁移中心 MgC的账号凭证不同,请手动输入如下参数信息:

- 区域ID:输入需要校验的数据所在区域ID。例如,区域为“华南-广州”,则输入“cn-south-1”

- 项目ID:输入与区域对应的项目ID。

- 集群ID:输入需要校验的数据所在集群ID。

表13 MaxCompute连接参数配置说明 参数

配置说明

所属源

仅需在源端创建元数据连接。

连接名称

默认创建名称为“MaxCompute-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

阿里云凭证

选择源端阿里云账号的凭证。凭证的添加方式请参考添加资源凭证,类型选择“大数据-MaxCompute”。

项目名称

输入需要采集的MaxCompute项目名称。项目名称可在MaxCompute侧控制台获取。

Endpoint

输入MaxCompute服务所在地域的Endpoint信息。

各地域Endpoint信息请参考Endpoint对照表。

表14 Lindorm连接参数配置说明 参数

配置说明

所属源

仅需在源端创建元数据连接。

连接名称

默认创建名称为“Lindorm-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

Lindorm凭证

选择在MgC Agent添加的源端Lindorm凭证。凭证的添加方式请参考添加资源凭证,类型选择“大数据-Lindorm”。

数据库链接

填写连接到源端Lindorm实例的地址。使用HBase兼容地址中的公网地址,获取方法请参考查看连接地址。

Lindorm版本

在下拉列表中选择对应Lindorm版本。目前只支持2.x版本。

在阿里云Lindorm实例列表,选择对应实例,在实例详情中查看Lindorm版本。

表15 阿里云云数据库ClickHouse连接参数配置说明 参数

配置说明

所属源

仅需在源端创建元数据连接。

连接名称

默认创建名称为“阿里云云数据库ClickHouse-4位随机数(字母和数字)”,也可以自定义名称。

迁移中心Agent

选择在源端环境中部署迁移中心Agent。

ClickHouse凭证

选择在MgC Agent添加的源端阿里云云数据库ClickHouse凭证。凭证的添加方法请参考添加资源凭证中的大数据-ClickHouse。

数据库链接

填写连接源端ClickHouse集群的外网地址。可以在集群信息页面,查看外网地址。

- 配置完成后,单击“测试连接”按钮,系统会校验配置信息并与源端建立连接,测试通过代表连接成功。

- 测试连接通过后,单击“确认”按钮,创建元数据连接完成。在连接管理页面,可以查看已创建的连接列表。如有需要,可以单击列表操作列的“修改链接”对连接配置进行修改。