MatrixLink网络

MatrixLink网络简介

MatrixLink网络基于高性能网络协议,实现NPU卡之间的高速互联,可提供大规模集群网络拓扑管理和安全隔离能力,同时,基于全局拓扑感知可实现网络的智能调度,为客户规划流量路径减少网络流量冲突。结合高性能通信算子及网络云脑可为客户提供更高性能、更高可靠的网络。

MatrixLink网络产品优势

- 性能优异:提供高速带宽互联网络,满足多种应用场景需求。

- 灵活调度:感知客户意图,基于全局拓扑提供网络灵活调度。

- 可靠性高:提供故障的快速感知、诊断和恢复能力,保障集群长稳运行。

MatrixLink网络应用场景

AI大模型训练与推理:AI大模型训练推理场景下通常需要大规模算力集群,为了充分发挥算力资源和网络资源的利用率,减少任务并行过程中的网络流量冲突,提升AI任务的训练推理效率,MatrixLink通过ScaleUp网络和ScaleOut网络可以提供大带宽低时延的高性能网络,通过网络调度可以实现客户模型与网络流量的最佳匹配,结合网络通信软件优化通信算子和网络云脑的故障快速感知与恢复能力,为客户大模型训练推理场景提供极致网络性能和高可靠性。

基本功能

- 智算网络

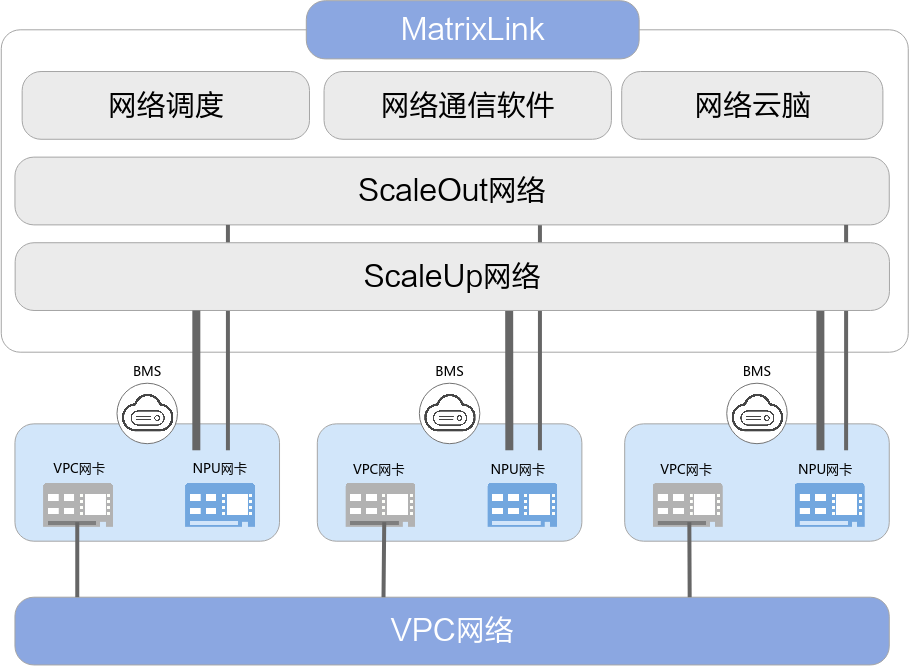

MatrixLink服务为充分发挥网络性能,支持ScaleUp网络、ScaleOut网络和VPC网络三重网络能力。ScaleUp网络负责超节点内的高速通信,跨超节点间的通信由ScaleOut网络负责,VPC网络负责通用网络流量的互访。基于流量特征划分的这三层网络,更加适合当前的训练分层通信、推理PD分离的应用场景,可为AI训练和推理提供极致网络性能。

- ScaleUp网络:基于华为自研HCCS协议栈,实现芯片级Load/Store语义通信,支持超节点内384卡全对等高速互联,同时提供动态切片能力,可按需划分独立通信域,满足分布式训练中的模型并行需求,单卡可最大支持784GBps带宽,时延低至<1μs,为大模型训练提供确定性通信保障。

- ScaleOut网络:通过先进的RDMA语义和物理RoCE协议,可实现跨超节点的高速通信,单卡最大可支持400Gbps带宽,实现1:1无收敛网络,通过多个超节点的网络互联,集群规模最大可支持128K卡,可满足超大规模模型的训练需求。

- VPC网络:基于UBoE协议单机最大可支持400Gbps带宽,相比传统网络带宽提升4倍,满足云原生环境下的通用数据传输需求,提供最全面的多租户网络隔离能力,保障业务流量的安全与服务质量。

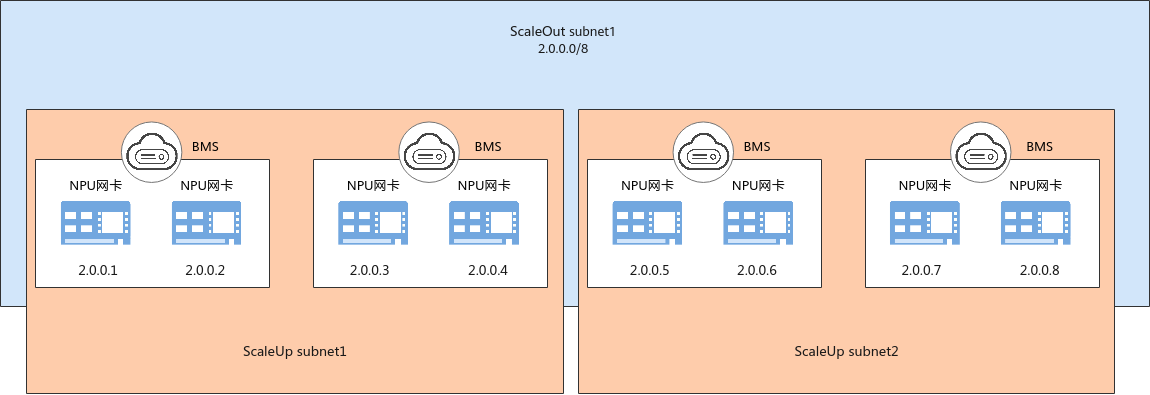

为确保多租户之间的业务流量互不影响,支持多租户间的网络隔离能力,通过ScaleUp子网与ScaleOut子网的划分来进行业务隔离,为客户提供安全的网络环境。

图2 不同子网NPU卡间的网络

网络调度

网络调度

AI大模型训练会将训练任务切分到多个计算节点进行分布式并行训练,会在节点之间引入复杂的通信行为,导致训练效率下降,网络调度通过考虑分布式训练通信的复杂性和集群带宽多级收敛的特性,根据大模型训练任务特征,并行度及可用资源拓扑信息,提供基于拓扑感知的亲和性部署和路径规划能力,降低模型训练过程中传输时间,提升大模型训练性能。

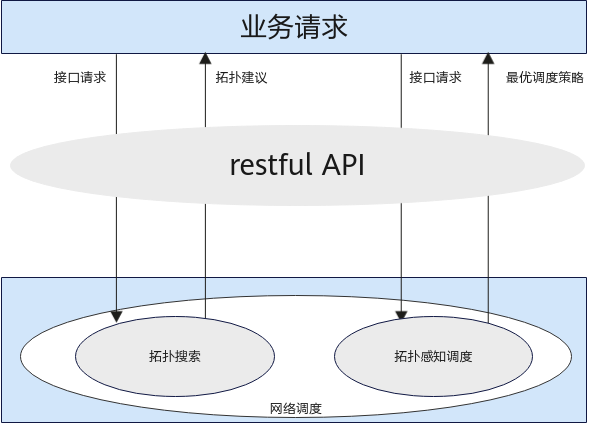

网络调度通过RESTful API接口可提供的能力包括:

- 拓扑搜索:根据用户提供的大模型超参、并行度及可用资源列表,提供给用户基于拓扑感知的任务资源最优选择建议。

- 拓扑感知调度:用户资源选择后,根据大模型超参、并行度、集合通信算法及AI编程框架等信息,优化资源部署及链路路由规划,提供资源调度优化建议。

图3 RESTful API调用示意

- 网络通信软件

通过构筑华为云自研的云原生高性能通信库,充分发挥超节点低时延内存语义通信,深度挖掘通算融合性能优势,基于云基础设施超节点形态及集群组网实现推理典型场景下的A2A、ARD通信算子加速。同时,基于NPU直驱内存语义的通信算子执行框架,支持通信算子与Attention计算算子的双batch隐藏,在推理场景下为客户提供高吞吐低时延的网络性能。

- 网络云脑

网络云脑通过感知设备和网络链路的状态实现故障快速发现,结合流量诊断及流量画像功能,基于AI算法和300+故障模式库,可分钟级诊断故障根因并决策故障恢复手段,减少故障爆炸半径,消除突发扰邻,提升系统的可靠性,实现IO吞吐效率大幅提升。