文本类加工算子介绍

平台支持文本类数据集的加工操作,分为数据提取、数据转换、数据过滤、数据打标四类,文本类加工算子能力清单见表1。

|

算子分类 |

算子名称 |

算子描述 |

|---|---|---|

|

数据提取 |

从Word文档中提取文字,并保留原文档的目录、标题和正文等结构,不保留图片、表格、公式、页眉、页脚。 |

|

|

从TXT文件中提取所有文本内容。 |

||

|

从CSV文件中读取所有文本内容,并按该文件内容类型模板KEY值生成匹配的JSON格式数据。 |

||

|

从PDF中提取文本,转化为结构化数据,支持文本、表格、公式等内容提取。 |

||

|

基于标签路径提取HTML数据内容,并将其他与待提取标签路径无关的内容删除。 |

||

|

从电子书中提取出所有文本内容。 |

||

|

数据转换 |

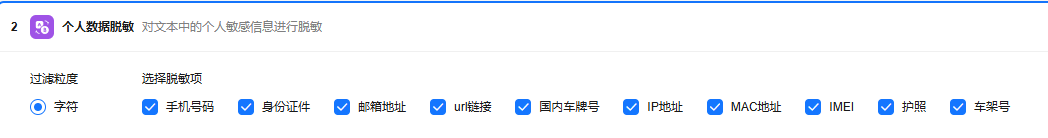

对文本中的手机号码、身份证件、邮箱地址、URL链接、国内车牌号、IP地址、MAC地址、IMEI、护照、车架号等个人敏感信息进行数据脱敏,或直接删除敏感信息。 |

|

|

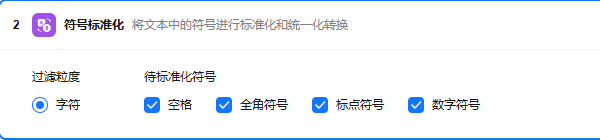

查找文本中携带的非标准化符号进行标准化、统一化转换。

|

||

|

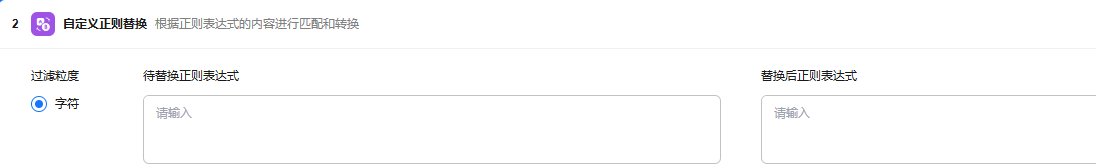

数据条目不变下,使用自定义正则表达式替换文本内容。 示例如下:

|

||

|

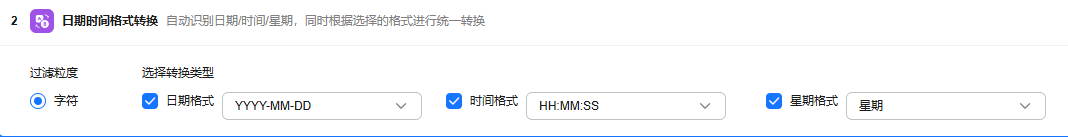

自动识别日期、时间、星期,同时根据选择的格式进行统一转换。 |

||

|

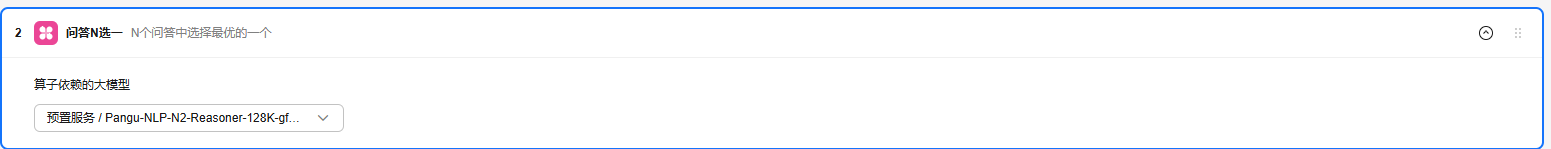

对于问答排序类型的数据,通过调用大模型,选出最优的答案放到答案列表第一个,其余答案顺序不变。 |

||

|

对于问答排序类型的数据,通过两两配对,调用大模型进行评价得分,最终根据得分得出预排序结果。 |

||

|

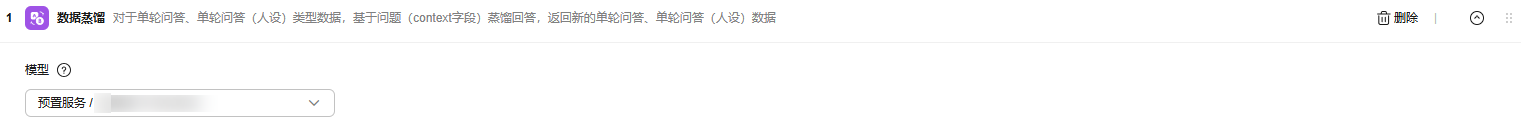

对于单轮问答类型数据,基于问题(context字段)生成回答,返回新的单轮问答数据。 |

||

|

按照句子的过滤粒度,自动识别段落结尾处的内容是否完整,如果不完整,则删除。 |

||

|

按照句子的过滤粒度,删除文本中包含广告数据的句子。 |

||

|

数据过滤 |

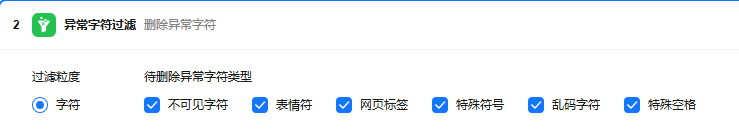

查找数据集每一条数据中携带的异常字符,并将异常字符替换为空值,数据条目不变。

|

|

|

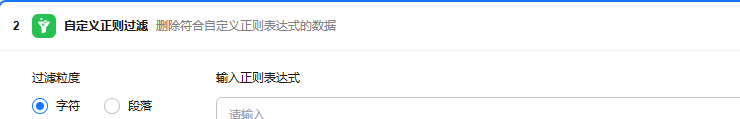

删除符合自定义正则表达式的数据。 |

||

|

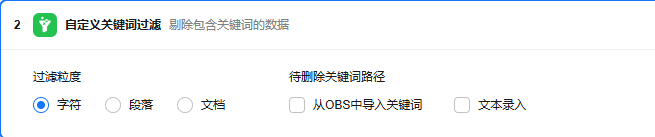

剔除包含关键词的数据。 |

||

|

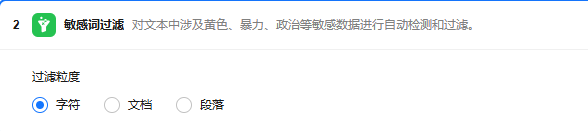

对文本中涉及黄色、暴力、政治等敏感数据进行自动检测和过滤。 |

||

|

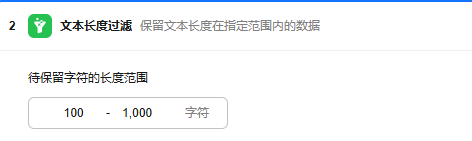

按照设置的文本长度,保留长度范围内的数据进行。 |

||

|

按照段落粒度,删除文本中的冗余信息,不改变数据条目。 例如图注表注和参考文献。 |

||

|

用于判断文档重复度,根据特征N值计算文档内词语按N值组合后的重复此时,可通过以下两种算法比较结果是否大于特征阈值,大于特征阈值的文档删除。

|

||

|

根据如下特征过滤:

|

||

|

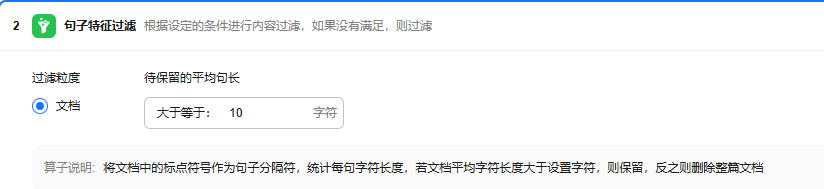

该算子将文档中的标点符号作为句子分隔符,统计每句字符长度,若文档平均字符长度大于设置字符,则保留,反之则删除整篇文档。根据如下特征过滤:

|

||

|

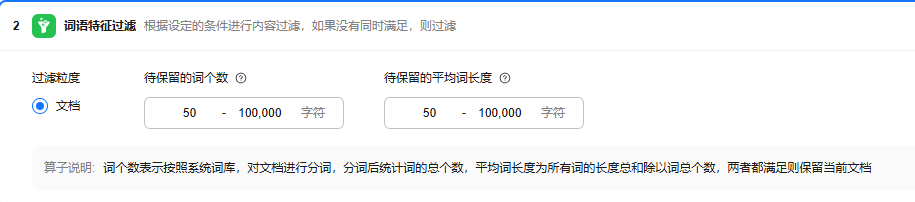

词个数表示按照系统词库,对文档进行分词,分词后统计词的总个数,平均词长度为所有词的长度总和除以词总个数,两者都满足则保留当前文档。根据如下特征过滤:

|

||

|

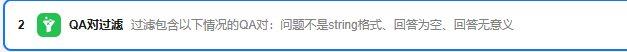

过滤包含以下情况的QA对:

|

||

|

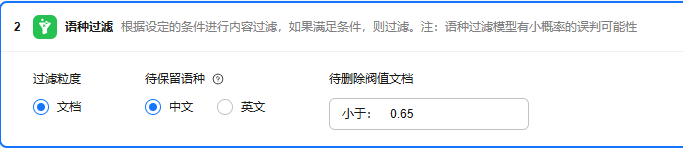

通过语种识别模型得到文档的语言类型,筛选所需语种的文档。 |

||

|

通过所选规则对SFT数据质量进行检查并过滤。 |

||

|

数据去重 |

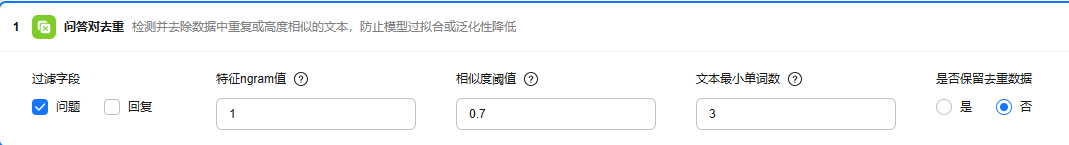

检测并去除数据中重复或高度相似的文本,防止模型过拟合或泛化性降低。 |

|

|

检测并去除数据中重复或高度相似的文本,防止模型过拟合或泛化性降低。 |

||

|

数据打标 |

通过LLM对SFT数据质量做通用语义检查和打分,并可根据打分阈值进行过滤。 |

|

|

通过LLM对SFT数据中的思维链做质量检查和打分,并可根据打分阈值进行过滤。 |

||

|

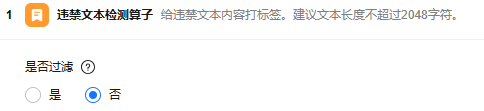

违禁内容检测算子通过对输入中文文本内容分析,最终返回文本中是否含有违禁内容的JSON结构化结果。 |

||

|

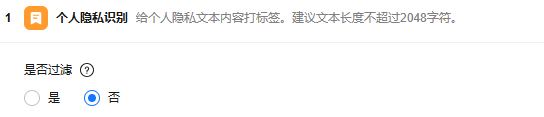

个人隐私内容检测算子通过对输入中文文本内容分析,最终返回文本中是否含有个人隐私内容的JSON结构化结果。 |

||

|

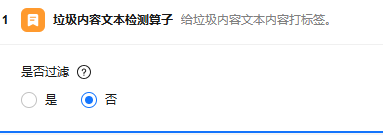

垃圾内容检测算子通过对输入中文文本内容分析,最终返回文本中是否含有垃圾内容的JSON结构化结果。 |

||

|

垃圾广告内容检测算子通过对输入中文文本内容分析,最终返回文本中是否含有垃圾广告内容的JSON结构化结果。 |

||

|

辱骂内容检测算子通过对输入中文文本内容分析,最终返回文本中是否含有辱骂内容的JSON结构化结果。 |

||

|

政治敏感内容检测算子通过对输入中文文本内容分析,最终返回文本中是否含有政治敏感内容的JSON结构化结果。 |

||

|

针对预训练文本进行内容分类,例如新闻、教育、健康等类别,支持分析语种包括:中文、英文。 |

||

|

针对文本进行通用质量的评估,例如流畅度、清晰度、丰富度等。 |

||

|

判断问题是否具有时效性,并给出判断原因。 |

||

|

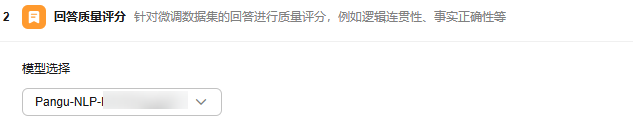

针对微调数据集的回答进行质量评分,例如逻辑连贯性、事实正确性等。 |

||

|

针对文本进行语法质量的评估,例如相关性、规范性等。 |

||

|

针对文本进行内容分类,例如汽车、体育、医疗等类别,支持分析语种包括:中文、英文。 |

||

|

检测文本所属行业及是否为理科数据,例如金融行业的报表分析、医疗行业的技术研究等。 |

段落特征过滤

- 适用的数据集类型:“文本类”。

- 各参数说明:

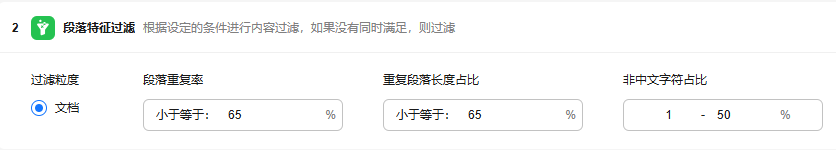

待过滤内容类型:按照文档过滤粒度,根据段落重复率、重复段落长度占比、非中文字符占比进行过滤,如果没有同时满足则过滤。默认值分别为段落重复率小于等于65%、重复段落长度占比小于等于65%、非中文字符占比1-50%,支持修改。

- 参数配置样例:

- 过滤样例:

加工前: {"text":"传说中,狐狸只对那些心地纯洁、愿望真诚的人显现。它会在月光下优雅地出现,用那双闪烁着智慧光芒的眼睛注视着来者。只有当狐狸感受到来者的真诚和纯洁,它才会开口说话,询问他们的愿望。 然而,愿望的实现并非没有代价。每一个愿望的实现都需要付出相应的代价。这个代价可能是珍贵的记忆,可能是深爱的事物,甚至可能是生命的一部分。因此,村民们在许愿之前,必须慎重考虑,是否愿意承担这样的代价。 传说中,狐狸只对那些心地纯洁、愿望真诚的人显现。它会在月光下优雅地出现,用那双闪烁着智慧光芒的眼睛注视着来者。只有当狐狸感受到来者的真诚和纯洁,它才会开口说话,询问他们的愿望。 然而,愿望的实现并非没有代价。每一个愿望的实现都需要付出相应的代价。这个代价可能是珍贵的记忆,可能是深爱的事物,甚至可能是生命的一部分。因此,村民们在许愿之前,必须慎重考虑,是否愿意承担这样的代价。"}

加工后:

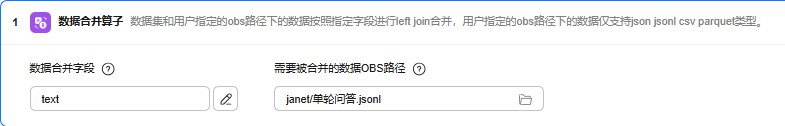

数据合并算子

- 适用的数据集类型:“文本类”。

- 各参数说明:

需要被合并的数据OBS路径:被合并数据集的OBS路径,仅支持json、jsonl、csv、parquet文件。

- 参数配置样例:

- 转换样例:

加工前:{"context": "参考资料中没有提供足够的信息来生成一个有意义的问题。","target": "无法通过参考资料生成问题", "start_domain_specific_l1": "其他"}

加工后:{"context":"参考资料中没有提供足够的信息来生成一个有意义的问题。","target":"无法通过参考资料生成问题","start_domain_specific_l1":"其他","description":"其他领域的描述知识"}

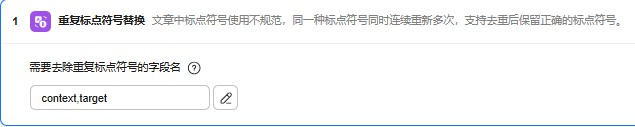

重复标点符号替换

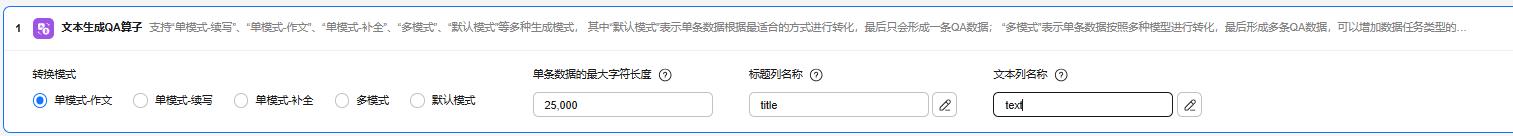

文本生成QA算子

- 适用的数据集类型:“文本类”。

- 各参数说明:

转换模式:支持“单模式-续写”、“单模式-作文”、“单模式-补全”、“多模式”、“默认模式”等多种生成模式, 其中“默认模式”表示单条数据根据最适合的方式进行转化,最后只会形成一条QA数据;“多模式”表示单条数据按照多种模型进行转化,最后形成多条QA数据,可以增加数据任务类型的多样性。

单条数据的最大字符长度:转化后的回答数据最大字符长度,超过长度“作文”作文模式下会过滤该条数据,其他模式下会进行拆分。下面给出基础功能模型对应的数据字符长度建议值,实际使用时,可以根据数据情况调整,但是需要保证数据转化为Token后不得超出训练模型的上下文Token长度。模型上下文Token长度对应的最大字符长度建议值如下:

32768 Token:最大字符长度 <= 25000字符

8196 Token:最大字符长度 <= 7500字符

4096 Token: 最大字符长度 <= 3500字符

标题列名称:用于获取数据中的标题。单模式-作文模型下必填,且列必须在数据中实际存在。

文本列名称:用于获取数据中的文本。默认为text。

- 参数配置样例:

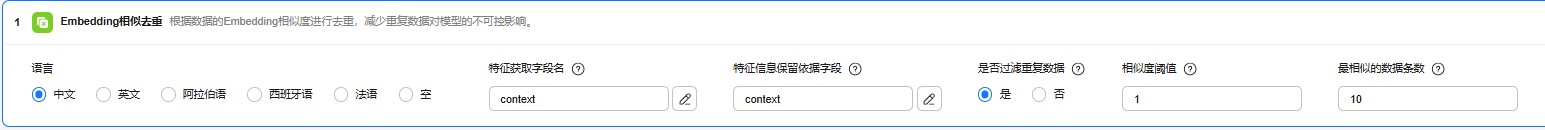

Embedding相似去重

- 适用的数据集类型:“文本类”。

- 各参数说明:

特征获取字段名:特征获取字段,计算embedding编码,用于如何挑选相似数据,如果不填默认为text或者context字段。

特征保留依据字段:根据embedding获取topN相似数据后,保留相似数据中,该字段值长度最长的记录,如果不填默认为text或者context字段。

是否过滤重复数据:过滤掉重复的数据,如果设置为不过滤重复数据,则会在结果中新增embedding_filter字段表示该条记录是否被过滤。

相似度阈值:当数据间的相似度小于阈值时会被选中,默认值0.2,取值范围[0,2.0]。

最相似的数据条数:每条记录查询出最相似的TopN条数据后,从中取出最相似的数据。默认值10。

- 转换样例:

{"context":"卫健委将电子烟纳入公共场所禁烟范围","target":"监管延伸"}

{"context":"生物学博士李雷:电子烟国标应涵盖尼古丁含量限制","target":"成分标准"}

{"context":"电子烟国标拟禁止水果口味吸引青少年","target":"特殊条款"}

{"context":"专家建议电子烟包装增加健康警示语","target":"消费提示"}

{"context":"电子烟国标制定首次引入消费者代表","target":"民主参与"}

{"context":"电子烟消费者调查:80%支持强制质量认证","target":"民意基础"}

{"context":"研究显示未监管电子烟含重金属超标3倍","target":"安全风险"}

{"context":"研究发现电子烟二手烟仍含致癌物质","target":"公共健康"}

{"context":"电子烟电池安全标准缺失致事故频发","target":"配件风险"}

{"context":"对比研究:中美电子烟监管体系差异","target":"国际比较"}

加工后:

{"context":"卫健委将电子烟纳入公共场所禁烟范围","target":"监管延伸"}

{"context":"生物学博士李雷:电子烟国标应涵盖尼古丁含量限制","target":"成分标准"}

{"context":"电子烟国标拟禁止水果口味吸引青少年","target":"特殊条款"}

{"context":"电子烟国标制定首次引入消费者代表","target":"民主参与"}

{"context":"电子烟消费者调查:80%支持强制质量认证","target":"民意基础"}

{"context":"研究显示未监管电子烟含重金属超标3倍","target":"安全风险"}

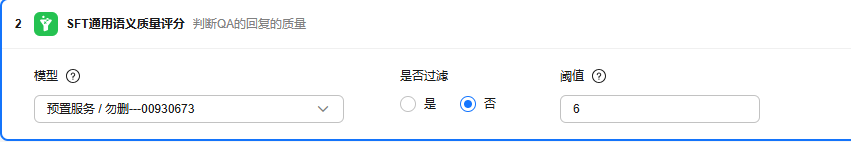

SFT通用语义质量评分

- 适用的数据集类型:“文本类-单轮问答、单轮问答(人设)、问答排序”。

- 各参数说明:

- 模型:需要选择模型。

- 是否过滤:字段取值是和否,默认为否,阈值取值范围在0.0~10.0之间,小于该值的样本将被过滤掉。

- 阈值:默认值为6,支持修改。

- 参数配置样例:

- 过滤样例:

加工前: [{"system":"你是一个计算达人","context":"根据给定的两个城市之间的距离,计算旅行所需的时间。起始城市:北京,目的地城市:上海,距离:1318公里。\n","target":"根据不同出行方式,北京到上海的旅行时间不同。如果乘坐高铁,大约需要5-6小时:如果乘坐飞机,大约需要2小时左右:如果驾车,大约需要13-14小时左右。"},{"system":"你是一个问答小能手","context":"在给定的一篇文章中,找到特定关键词的出现次数。\n文章:今年世界杯期间,许多人会熬夜观看比赛。\n关键词:世界杯\n","target":"关键词\"世界杯\"在文章中出现了1次。"}]

加工后: {"context":"在给定的一篇文章中,找到特定关键词的出现次数。\n文章:今年世界杯期间,许多人会熬夜观看比赛。\n关键词:世界杯\n","filter":0.0,"qa_quality score":{"reason":"大模型正确地识别出关键词\"世界杯\"在文章中出现了 1 次,并且给出了正确的答案。","score":10.0},"system":"你是一个问答小能手","target":"关键词\"世界杯\"在文章中出现了 1 次。"}

说明:未过滤的数据会打标,打标字段包括reason原因、score分数。

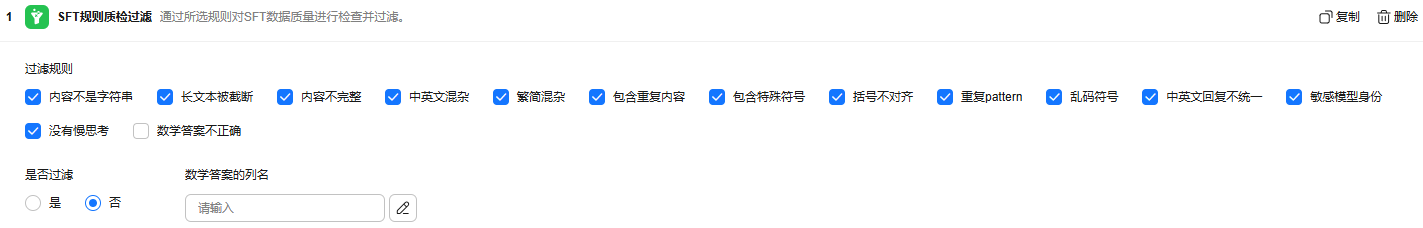

SFT规则质检过滤

- 适用的数据集类型:“文本类-单轮问答、单轮问答(人设)、问答排序”。

- 各参数说明:

- 过滤规则:通过所选规则对SFT数据质量进行检查并过滤。过滤规则包括内容不是字符串、长文本被截断、内容不完整、中英文混杂、繁简混杂、包含重复内容、包含特殊符号、括号不对齐、重复pattern、乱码符号、中英文回复不统一、敏感模型身份、没有慢思考、数学答案不正确,除了数学答案不正确这个选项外其余选项默认全部勾选,也可以选择其中部分规则。

- 是否过滤:取值是和否,默认为否。

- 数学答案列名:当过滤规则中勾选“数学答案不正确”后需要填写,即数据集中存储正确答案的列名(key值),用来判断模型回答是否正确,如果没有匹配到该字段,默认为答案不正确。当“数学答案不正确”规则未勾选,该参数可忽略。

SFT思维链质量评分

- 适用的数据集类型:“文本类-单轮问答、单轮问答(人设)、问答排序 jsonl”。

- 各参数说明:

待过滤内容类型:通过LLM对SFT数据中的思维链做质量检查和打分,并可根据打分阈值进行过滤。

- 模型:需要选择模型。

- 是否过滤:取值是和否,默认值为否。

- 阈值:取值范围在0.0~6.0之间,小于该值的样本将被过滤掉,阈值默认值为6,支持修改。

- 标准答案:界面支持用户输入标准答案的字段名,跟回答做比较,如算子无法匹配到对应的字段名,则默认为无正确答案逻辑。

- 数据判断规则:支持编辑,最大字符1000。

- 数据打分规则:支持编辑,最大字符1000。

- 参数配置样例:

- 过滤样例:

加工前:{"context":"context内容","targets":["hello","hi","你好"]}

加工后:{"context":"context内容","targets":["hello","hi","你好"],"qa_cot_score":{"score":[{"result":"错误","score":0.0,"reason":["模型回答不相关"]},{"result":"错误","score":0.0,"reason":"回答不相关"},{"result":"错误","score":0.0,"reason":"[模型回答不相关]"}]}}

说明:未过滤的数据会打标,打标字段包括result结果、score分数、reason原因。

问答对去重

违禁文本检测算子

- 适用的数据集类型:“问答排序、单轮问答、单轮问答(带人设) jsonl”。

- 各参数说明:选“是”则是过滤算子,选否则不过滤。

- 参数配置样例:

- 过滤样例:

{"text": "QQ销售股民数据,你有吗"}

打标后:

{"text":"QQ销售股民数据,你有吗","text_ban_moderation":{"suggestion":"block","details":{"confidence":1.0,"label":"violation_info","risk_level":2,"segments":[{"segment":"qq销售股民数据"},{"segment":"股民数据"},{"segment":"股民数据&销售"},{"segment":"销售股民数据"}],"suggestion":"block"}}}

suggestion字段表示对文件检测是否通过的结果,pass代表审核通过无相应的问题;review代表需要人工复核,您可以按照您的审核策略选择放通还是拦截;block代表待审文件存在问题。

个人隐私识别

- 适用的数据集类型:“问答排序、单轮问答、单轮问答(带人设) jsonl”。

- 各参数说明:选“是”则是过滤算子,选否则不过滤。

- 参数配置样例:

- 过滤样例:

{"text": "你保存一下我的MAC地址:20-6E-D4-88-F3-98"}

打标后:

{"text":"你保存一下我的MAC地址:20-6E-D4-88-F3-98","text_pii_moderation":{"suggestion":"block","details":[{"start":33,"end":50,"length":17,"data":"20-6E-D4-88-F3-98","category":"MAC_ADDRESS"}]}}

suggestion字段表示对文件检测是否通过的结果,pass代表审核通过无相应的问题;review代表需要人工复核,您可以按照您的审核策略选择放通还是拦截;block代表待审文件存在问题。

垃圾内容文本检测算子

- 适用的数据集类型:“问答排序、单轮问答、单轮问答(带人设) jsonl”。

- 各参数说明:选“是”则是过滤算子,选否则不过滤。

- 参数配置样例:

- 过滤样例:

{"text": "【开远假证848777596_qq合肥假证uhc0tm】什么意思_英语开远假证848777596_qq合肥假证uhc0tm的翻译_音标_读音_用法_例句_在线翻译_有道词典"}

打标后:

{"text":"【开远假证848777596_qq合肥假证uhc0tm】什么意思_英语开远假证848777596_qq合肥假证uhc0tm的翻译_音标_读音_用法_例句_在线翻译_有道词典","text_spam_moderation":{"details":[{"confidence":1.0,"label":"abuse","risk_level":2,"segments":[{"segment":"tm的"}],"suggestion":"block"}],"suggestion":"block"}}

suggestion字段表示对文件检测是否通过的结果,pass代表审核通过无相应的问题;review代表需要人工复核,您可以按照您的审核策略选择放通还是拦截;block代表待审文件存在问题。

辱骂文本检测算子

- 适用的数据集类型:“问答排序、单轮问答、单轮问答(带人设) jsonl”。

- 各参数说明:选“是”则是过滤算子,选否则不过滤。

- 参数配置样例:

- 过滤样例:

{"text": "谁要和你一起死要死你自己死"}

打标后:

{"text":"谁要和你一起死要死你自己死","text_abuse_moderation":{"details":[{"confidence":0.9998,"label":"abuse","risk_level":2,"segments":[],"suggestion":"block"}],"suggestion":"block"}}

suggestion字段表示对文件检测是否通过的结果,pass代表审核通过无相应的问题;review代表需要人工复核,您可以按照您的审核策略选择放通还是拦截;block代表待审文件存在问题。

涉政文本检测算子

- 适用的数据集类型:“问答排序、单轮问答、单轮问答(带人设) jsonl”。

- 各参数说明:选“是”则是过滤算子,选否则不过滤。

- 参数配置样例:

- 过滤样例:

{"text": "但中共当局对这些网络质疑声音从来不屑于解释,而是直接封杀"}

打标后:

{"text":"但中共当局对这些网络质疑声音从来不屑于解释,而是直接封杀","text_polInfo_moderation":{"suggestion":"block","details":"[{'confidence': 1.0, 'label': 'politics', 'risk_level': 3, 'segments': [{'segment': '中共当局'}], 'suggestion': 'block'}]"}}

suggestion字段表示对文件检测是否通过的结果,pass代表审核通过无相应的问题;review代表需要人工复核,您可以按照您的审核策略选择放通还是拦截;block代表待审文件存在问题。

预训练文本分类

- 适用的数据集类型:“文档、预训练文本”。

- 各参数说明:

- 参数配置样例:

- 打标样例:

{"fileName":"新闻打标测试.docx","text":" 本报北京3月3日电(记者徐佩玉)中国人民银行发布的今年1月份金融市场运行情况显示,1月份,我国债券市场共发行各类债券51027.5亿元。其中,国债发行10185.0亿元,地方政府债券发行5575.7亿元,金融债券发行7042.1亿元,公司信用类债券发行12791.7亿元,信贷资产支持证券发行27.3亿元,同业存单发行15147.8亿元。\n 截至1月末,我国债券市场托管余额178.2万亿元。其中,银行间市场托管余额156.9万亿元,交易所市场托管余额21.3万亿元。\n在债券市场对外开放方面,截至1月末,境外机构在中国债券市场的托管余额4.2万亿元,占中国债券市场托管余额的比重为2.3%。其中,境外机构在银行间债券市场的债券托管余额4.1万亿元:分券种看,境外机构持有国债2.0万亿元、占比48.8%,同业存单1.1万亿元、占比25.8%,政策性银行债券0.9万亿元、占20.8%。\n","pre_classification":"经济"}

通用质量评估

- 适用的数据集类型:“文本类-预训练文本”。

- 各参数说明:

待打标内容类型:针对文本进行通用质量的评估,例如流畅度、清晰度、丰富度等。需要选择模型、行业,其中行业支持手输,最高分为5分

- 参数配置样例:

- 打标样例:

{"fileName":"新闻打标测试.docx","text":"本报北京3月3日电(记者徐佩玉)中国人民银行发布的今年1月份金融市场运行情况显示,1月份,我国债券市场共发行各类债券51027.5亿元。其中,国债发行10185.0亿元,地方政府债券发行5575.7亿元,金融债券发行7042.1亿元,公司信用类债券发行12791.7亿元,信贷资产支持证券发行27.3亿元,同业存单发行15147.8亿元。\n 截至1月末,我国债券市场托管余额178.2万亿元。其中,银行间市场托管余额156.9万亿元,交易所市场托管余额21.3万亿元。\n在债券市场对外开放方面,截至1月末,境外机构在中国债券市场的托管余额4.2万亿元,占中国债券市场托管余额的比重为2.3%。其中,境外机构在银行间债券市场的债券托管余额4.1万亿元:分券种看,境外机构持有国债2.0万亿元、占比48.8%,同业存单1.1万亿元、占比25.8%,政策性银行债券0.9万亿元、占比20.8%。\n","generalscore":{"教育价值":"5","清洁度":"5","isIncorrect":"false","毒性":"false","丰富度":"5","流畅度":"5","knowledge":"5"}}

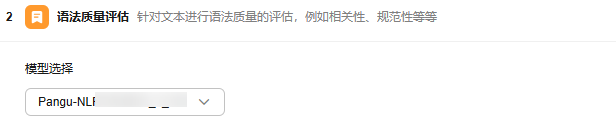

文本分类标签v2算子

- 适用的数据集类型:“文本类-预训练文本、文本类-单轮问答、单轮问答(人设)、问答排序”。

- 各参数说明:

- 参数配置样例:

- 打标样例:

{"text":"作者:王俊力,吴猛,武汉大学中南医院超声科\n患者女,28岁,发现右乳肿物半年,因6 d前自觉疼痛就诊。3年前曾行剖宫产术。体格检查:无发热,乳腺区皮肤无红肿,无乳头溢液;右侧乳腺外下象限可触及一直径约2 cm的肿块,触痛明显,质韧,右侧腋窝未触及肿大淋巴结。\n超声检查:右乳外下象限可见一大小约2.1 cm×1.4 cm×1.1 cm的不规则片状低至无回声区,与周边组织分界不清(图1);CDFI可探及少量血流信号,呈动脉频谱,阻力指数0.64。\n超声提示:右乳外下象限实质性病灶(BI-RADS 4b类;炎性改变不排除)。MRI检查:T2抑脂序列右乳外下象限见一不规则高信号肿块影(图2),呈明显不均匀强化,时间-信号曲线呈流出型。\nMRI提示:右侧乳腺外下象限不规则肿块,建议活检。钼靶检查:右乳外下象限乳后间隙及胸肌表面见不规则形稍高密度团块影(BI-RADS 4b类)。患者行右乳肿物切除术+筋膜组织瓣形成术。病理结果:梭形细胞肿瘤(图3),结合形态及免疫组化检查考虑乳腺侵袭性纤维瘤病。\n讨论\n乳腺侵袭性纤维瘤是一种乳腺间叶源性肿瘤,在乳腺疾病中的发病率约为0.2%。其病因尚不明确,多与遗传倾向、手术或雌激素等相关;常见于育龄期女性,临床表现无特征性。\n病理学构成为增生的成纤维细胞、肌成纤维细胞和胶原纤维构成;免疫组化检查主要表现为瘤细胞Vimentin和SAM呈阳性。超声表现为形态不规则、与周边组织分界不清的低回声包块,可呈“毛刺状”或“鹿角状”;肿块常沿长轴分布走行,可累及后方胸壁肌层;内部血流信号较少。\n目前本病的治疗多以手术为主,患者术后需长期随访,若出现复发,则根据病情需要再次手术或辅以放化疗、激素治疗等。本病需与梭形细胞癌、瘢痕组织等鉴别。","tag":null,"domain_specific_l1":"医药\/医疗","domain_specific_l2":"肿瘤学","domain_specific_confidence":0.429}

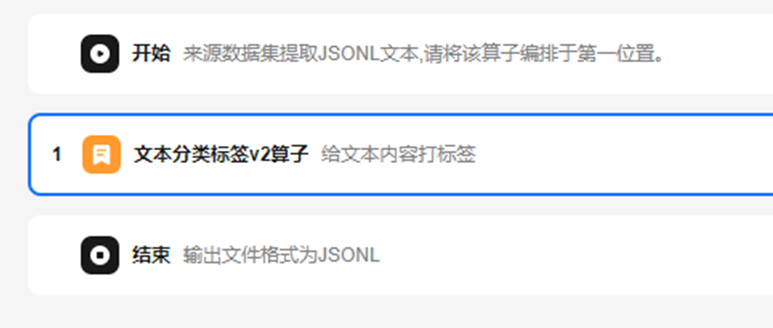

泛理科文本检测算子

- 适用的数据集类型:“文本类-预训练文本、文本类-单轮问答、单轮问答(人设)、问答排序”。

- 各参数说明:

待打标内容类型:检测文本所属行业及是否为理科数据,例如金融行业的报表分析、医疗行业的技术研究等。需要选择模型,模型建议使用Pangu-NLP-N1-32K-3.2.36.3。

- 参数配置样例:

- 打标样例:

{"system":"机智幽默","context":"此外,支架组件的未完全贴合可能会进一步加剧与血栓形成和再狭窄相关的风险。\n英文:Additionally, the incomplete apposition of stent components can further exacerbate risks associated with thrombosis and restenosis.","target":"ccccccc","ori_response":"属于医疗理科<|im_end|>","industry_category":"医疗","science_classification":"泛理科数据"}