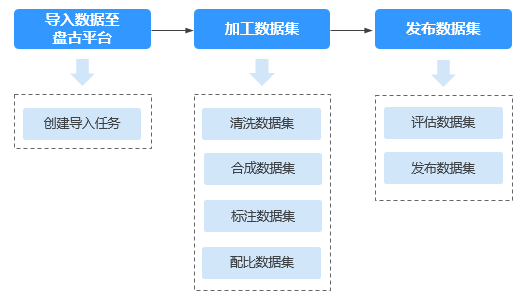

数据工程使用流程

高质量数据是推动大模型不断迭代和优化的根基,它的质量直接决定了模型的性能、泛化能力以及应用场景的适配性。只有通过系统化地准备和处理数据,才能提取出有价值的信息,从而更好地支持模型训练。因此,数据的获取、加工、合成、标注、配比、评估、发布等环节,成为数据开发中不可或缺的重要步骤。

在使用数据加工的大模型算子、数据合成、数据标注的预标注功能前,请先确保有已部署的NLP大模型。

|

流程 |

子流程 |

说明 |

|---|---|---|

|

导入数据至盘古平台 |

创建导入任务 |

将存储在OBS服务中的数据或本地数据导入至平台统一管理,用于后续加工或发布操作。 |

|

加工数据集 |

加工数据集 |

通过专用的加工算子对数据进行预处理,确保数据符合模型训练的标准和业务需求。不同类型的数据集使用专门设计的算子,例如去除噪声、冗余信息等,提升数据质量。 |

|

合成数据集 |

利用预置或自定义的数据指令对原始数据进行处理,并根据设定的轮数生成新数据。该过程能够在一定程度上扩展数据集,增强训练模型的多样性和泛化能力。 |

|

|

标注数据集 |

为无标签数据集添加准确的标签,确保模型训练所需的高质量数据。平台支持人工标注和AI预标注两种方式,用户可根据需求选择合适的标注方式。数据标注的质量直接影响模型的训练效果和精度。 |

|

|

配比数据集 |

数据配比是将多个数据集按特定比例组合并生成为“加工数据集”的过程。通过合理的配比,确保数据集的多样性、平衡性和代表性,避免因数据分布不均而引发的问题。 |

|

|

发布数据集 |

评估数据集 |

平台预置了多种数据类型的基础评估标准,用户可根据需求选择预置标准或自定义评估标准,从而精确优化数据质量,确保数据满足高标准,提升模型性能。 |

|

发布数据集 |

数据发布是将数据集发布为特定格式的“发布数据集”,用于后续模型训练等操作。 平台支持发布的数据集格式为标准格式、盘古格式。

|