更新时间:2025-11-18 GMT+08:00

训练中途卡死

问题现象1

检测每个节点日志是否有报错信息,某个节点报错但作业未退出导致整个训练作业卡死。

解决方案1

查看报错原因,解决报错。

问题现象2

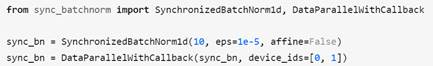

作业卡在sync-batch-norm中或者训练速度变慢。pytorch如果开了sync-batch-norm,多机会慢,因开了sync-batch-norm以后,每一个iter里面每个batch-norm层都要做同步,通信量很大,而且要所有节点同步。

解决方案2

关掉sync-batch-norm,或者升pytorch版本,升级pytorch到1.10。

问题现象3

作业卡在tensorboard中,出现报错:

writer = Sumarywriter('./path/to/log')

解决方案3

存储路径设为本地路径,如cache/tensorboard,不要使用OBS路径。

问题现象4

使用pytorch中的dataloader读数据时,作业卡在读数据过程中,日志停在训练的过程中并不再更新日志。

解决方案4

用dataloader读数据时,适当减小num_worker。

父主题: 训练作业卡死