更新时间:2024-11-08 GMT+08:00

怎样升级DLI作业的引擎版本

DLI提供了Spark和Flink计算引擎,为用户提供了一站式的流处理、批处理、交互式分析的Serverless融合处理分析服务,当前,Flink计算引擎推荐版本:Flink 1.15,Spark计算引擎推荐版本: Spark 3.3.1。

本节操作介绍如何升级作业的引擎版本。

- SQL作业:

SQL作业不支持配置引擎版本,需要您重新新建队列执行SQL作业,新创建的队列会默认使用新版本的Spark引擎。

- Flink OpenSource SQL作业:

- 登录DLI管理控制台。

- 选择“作业管理 > Flink作业”,在作业列表中选择待操作的Flink OpenSource SQL作业。

- 单击操作列的“编辑”,进入作业编辑页面。

- 在右侧的“运行参数”配置区域,选择新的Flink版本。

使用Flink 1.15以上版本的引擎执行作业时,需要在自定义配置中配置委托信息,其中key为"flink.dli.job.agency.name",value为委托名,否则可能会影响作业运行。了解自定义DLI委托

Flink 1.15语法参考请查看Flink 1.15语法概览。

- Flink Jar作业:

- 登录DLI管理控制台。

- 选择“作业管理 > Flink作业”,在作业列表中选择待操作的Flink Jar作业。

- 单击操作列的“编辑”,进入作业编辑页面。

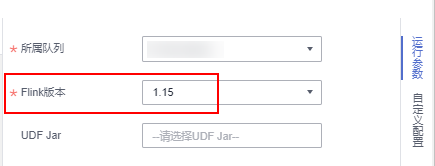

- 在参数配置区域,选择新的Flink版本。

使用Flink 1.15以上版本的引擎执行作业时,需要在优化参数中配置委托信息,其中key为"flink.dli.job.agency.name",value为委托名,否则可能会影响作业运行。了解自定义DLI委托

Flink 1.15语法参考请查看Flink 1.15语法概览。

- Spark Jar作业:

- 登录DLI管理控制台。

- 选择“作业管理 > Spark作业”,在作业列表中选择待操作的Spark Jar作业。

- 单击操作列的“编辑”,进入作业编辑页面。

- 在参数配置区域,选择新的Spark版本。

使用Spark3.3以上版本的引擎执行作业时,需要Spark参数中配置自定义的委托名称,否则可能会影响作业运行。了解自定义DLI委托

- 了解更多:

父主题: DLI产品咨询类