Uso de Kafka desde principio

MRS proporciona componentes de big data de alto rendimiento basados en Hadoop, como Spark, HBase, Kafka y Storm.

En esta sección se utiliza un clúster con la autenticación Kerberos deshabilitada como ejemplo para describir cómo generar y consumir mensajes en un topic de Kafka.

Vídeo Tutorial

Este vídeo utiliza un clúster MRS 3.1.0 (con la autenticación Kerberos deshabilitada) como ejemplo para describir cómo utilizar un cliente Kafka para crear, consultar y eliminar un topic. Para obtener más información sobre cómo crear un topic, vea Creación de un topic con el cliente Kafka.

La interfaz de usuario puede variar dependiendo de la versión. El video tutorial es solo para referencia.

Compra de un clúster

- Comprar un clúster MRS.

- Inicie sesión en la consola Huawei Cloud.

- Elija Service List >Analytics >MapReduce Service.

- En la página Active Clusters que se muestra, haga clic en Buy Cluster.

- Haga clic en la pestaña Custom Config.

- Configurar software.

- Region: Seleccione una región según sea necesario.

- Billing Mode: Seleccione Pay-per-use.

- Cluster Name: Introduzca mrs_demo o especifique un nombre de acuerdo con las reglas de nomenclatura.

- Cluster Version: Seleccione MRS 3.1.0.

- Cluster Type: Seleccione Streaming cluster.

- Seleccione todos los componentes del clúster de streaming.

- Haga clic en Next.

- Configurar hardware.

- AZ: Seleccione AZ2.

- Enterprise Project: Seleccione default.

- VPC y Subnet: Conserve los valores predeterminados o haga clic en View VPC y View Subnet para crearlos.

- Security Group - Utilice el valor predeterminado Security Group.

- EIP: Bind later está seleccionado de forma predeterminada.

- Cluster Node: Conserve los valores predeterminados. No agregue nodos de tarea.

- Haga clic en Next.

- Establecer opciones avanzadas.

- Kerberos Authentication: Disabled

- Username: admin se utiliza de forma predeterminada.

- Password y Confirm Password: Configúrelos con la contraseña del administrador del FusionInsight Manager.

- Login Mode: Seleccione Password. Ingrese una contraseña y confirme la contraseña para usuario root.

- Host Name Prefix: Conserve el valor predeterminado.

- Seleccione Advanced Settings y establezca Agency en MRS_ECS_DEFAULT_AGENCY.

- Haga clic en Next.

- Confirmar la configuración.

- Configure: Confirme los parámetros configurados en las áreas Configure Software, Configure Hardware y Set Advanced Options.

- Secure Communications: Seleccione Enable.

- Haga clic en Buy Now. Se muestra la página que muestra que la tarea se ha enviado.

- Haga clic en Back to Cluster List. Puede ver el estado del clúster en la página Active Clusters. Espere a que se complete la creación del clúster. El estado inicial del clúster es Starting. Una vez creado el clúster, el estado del clúster pasa a ser Running.

Instalación del cliente Kafka

- Elija Clusters > Active Clusters. En la página Active Clusters, haga clic en el clúster denominado mrs_demo para ir a su página de detalles.

- Haga clic en Access Manager junto a MRS Manager. En la página que se muestra, configure la información de EIP y haga clic en OK. Ingrese el nombre de usuario y la contraseña para acceder al FusionInsight Manager.

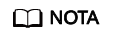

- Elija Cluster >Services >HBase. En la página mostrada, elija More >Download Client. En el cuadro de diálogo Download Cluster Client, seleccione Complete Client para Select Client Type y seleccione un tipo de plataforma, seleccione Save to Path y haga clic en OK. Se descarga el paquete de software cliente Kafka, por ejemplo FusionInsight_Cluster_1_Kafka_Client.tar.

- Inicie sesión en el nodo activo como usuario root.

- Vaya al directorio donde está almacenado el paquete de software y ejecute los siguientes comandos para descomprimir y verificar el paquete de software, y descomprimir el archivo de instalación obtenido:

cd /tmp/FusionInsight-Client

tar -xvf FusionInsight_Cluster_1_Kafka_Client.tar

sha256sum -c FusionInsight_Cluster_1_Kafka_ClientConfig.tar.sha256

tar -xvf FusionInsight_Cluster_1_Kafka_ClientConfig.tar

- Vaya al directorio donde está almacenado el paquete de instalación y ejecute el siguiente comando para instalar el cliente en un directorio especificado (ruta absoluta), por ejemplo /opt/hadoopclient:

cd /tmp/FusionInsight-Client/FusionInsight_Cluster_1_Kafka_ClientConfig

Ejecute el comando ./install.sh /opt/hadoopclient y espere hasta que se complete la instalación del cliente.

- Compruebe si el cliente está instalado.

cd /opt/hadoopclient

source bigdata_env

Ejecute el comando klist para consultar y confirmar los detalles de autenticación. Si se ejecuta el comando, se instala el cliente Kafka.

Inicio de sesión en un nodo master mediante VNC

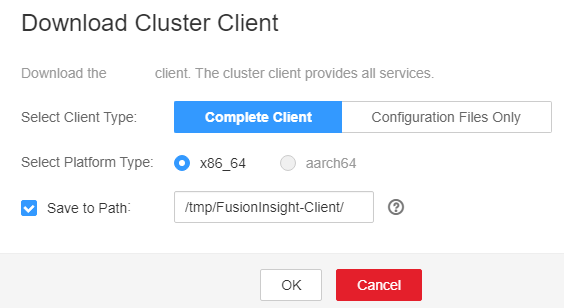

- Elija Clusters > Active Clusters. En la página Active Clusters que se muestra, haga clic en el clúster denominado mrs_demo. En la página de detalles del clúster que se muestra, haga clic en la pestaña Nodes. En esta página de pestaña, busque el nodo cuyo tipo es Master1 y haga clic en el nombre del nodo para ir a la página de detalles de ECS.

- Haga clic en Remote Login en la esquina superior derecha de la página para iniciar sesión de forma remota en el nodo master. Inicie sesión con el nombre de usuario root y la contraseña configurada durante la compra del clúster.

Creación de un topic mediante el cliente Kafka

- Configure variables de entorno. Por ejemplo, si el directorio de instalación del cliente de Kafka es /opt/hadoopclient, ejecute el siguiente comando:

source /opt/hadoopclient/bigdata_env

- Elija Clusters > Active Clusters. En la página Active Clusters, haga clic en el clúster denominado mrs_demo para ir a la página de pestaña Dashboard. En esta página, haga clic en Synchronize junto a IAM User Sync.

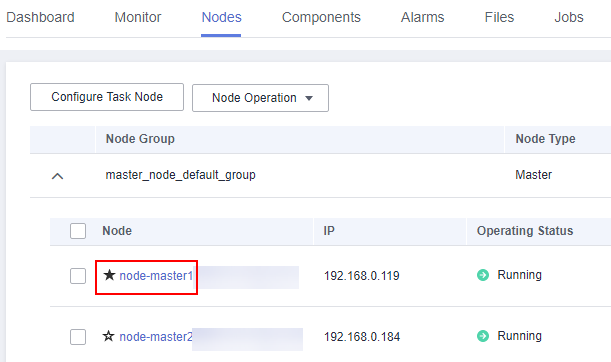

- Una vez completada la sincronización, haga clic en la pestaña Components. En esta página de pestaña, seleccione ZooKeeper. En la página que se muestra, haga clic en la pestaña Instances. Registre la dirección IP de cualquier instancia de ZooKeeper, por ejemplo, 192.168.7.35.

Figura 1 Direcciones IP de instancias de rol de ZooKeeper

- Ejecute el siguiente comando para crear un topic de Kafka:

kafka-topics.sh --create --zookeeper <IP address of the node where the ZooKeeper instance resides:2181/kafka> --partitions 2 --replication-factor 2 --topic <Topic name>

Gestión de mensajes en Kafka Topics

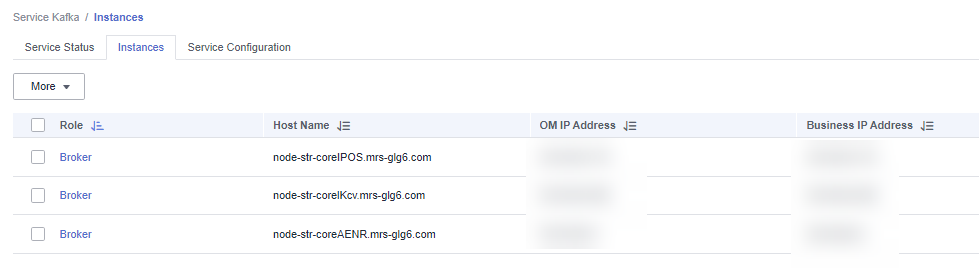

- Haga clic en la pestaña Components. En esta página de pestaña, seleccione Kafka. En la página que se muestra, haga clic en la pestaña Instances. En la página de pestaña Instances, vea las direcciones IP de las instancias de Kafka. Registre la dirección IP de cualquier instancia de Kafka, por ejemplo 192.168.7.15.

Figura 2 Direcciones IP de instancias de rol de Kafka

- Inicie sesión en el nodo master y ejecute el siguiente comando para generar mensajes en una prueba de topic:

kafka-console-producer.sh --broker-list <IP address of the node where the Kafka instance resides:9092> --topic <Topic name> --producer.config /opt/hadoopclient/Kafka/kafka/config/producer.properties

Introduzca el contenido especificado como los mensajes generados por el productor y pulse Enter para enviar los mensajes. Para dejar de generar mensajes, presione Ctrl+C para salir.

- Consumir mensajes en la prueba de topic.

kafka-console-consumer.sh --topic <Topic name> --bootstrap-server <IP address of the node where the Kafka instance resides:9092> --consumer.config /opt/hadoopclient/Kafka/kafka/config/consumer.properties