Spark Python作业如何引用Python脚本?

前提条件

在管理中心已创建MRS Spark连接,连接方式为MRS API连接。

操作步骤

- 在数据开发主界面的左侧导航栏,选择“数据开发 > 脚本开发”。

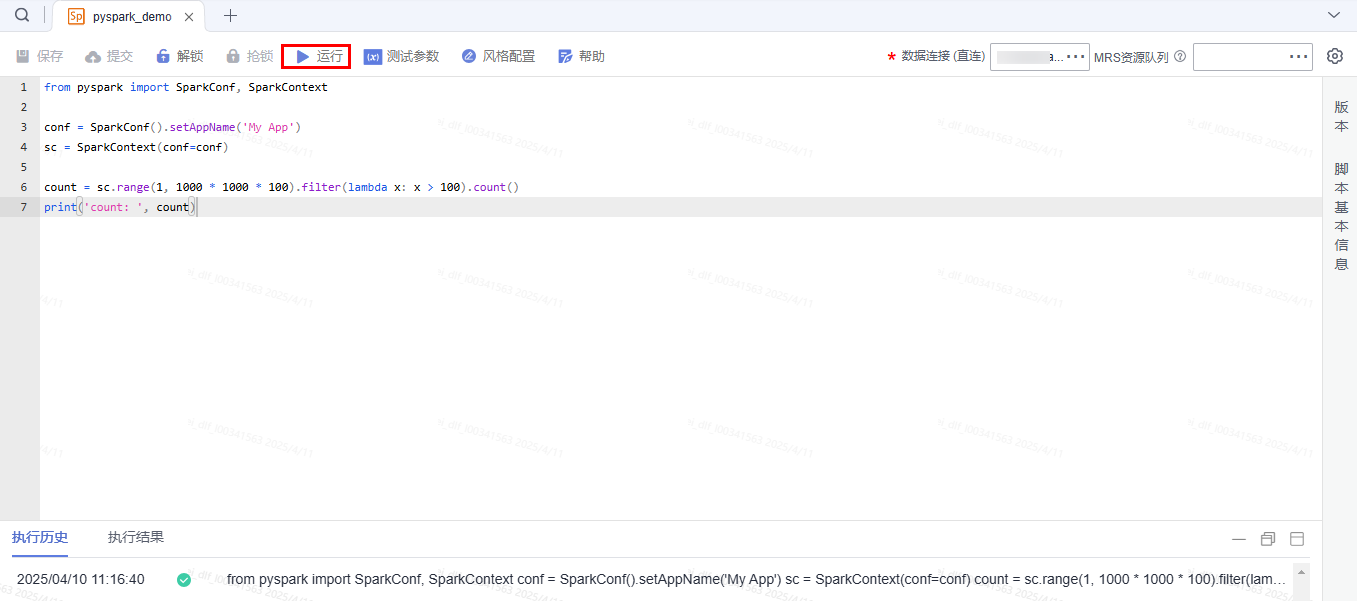

- 创建一个Spark Python脚本,脚本名称为pyspark_demo。数据连接选择管理中心已创建的MRS Spark连接。

from pyspark import SparkConf, SparkContext conf = SparkConf().setAppName('My App') sc = SparkContext(conf=conf) count = sc.range(1, 1000 * 1000 * 100).filter(lambda x: x > 100).count() print('count: ', count) - 保存并提交版本。

- 单击“运行”,运行该脚本。

图1 运行脚本

- 查看脚本的执行历史结果。

脚本创建好以后,在作业中引用该脚本,具体操作如下。

- 创建一个作业批处理的Pipeline作业。

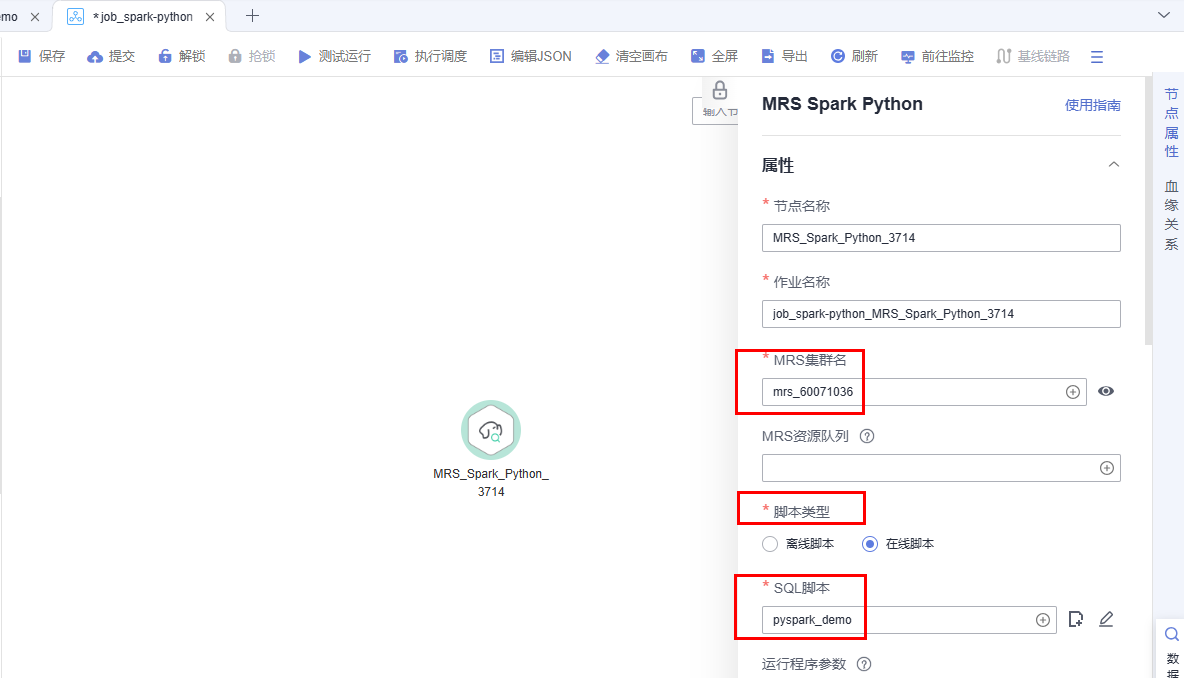

- 进入作业后,在画布中间,拖入MRS Spark Python作业节点,并配置节点属性参数。

集群:与管理中心创建连接时,所选择的集群保持一致。

脚本:选择在线脚本,选择在脚本开发已创建好的脚本pyspark_demo。

其他参数保持以默认。

图2 配置节点参数

- 设置作业调度方式。配置调度方式为单次调度或者周期调度。

- 保存并提交版本。

- 单击“执行调度”,运行该作业。

图3 查看调度运行结果

- 在“作业监控”查看作业的调度运行状态,并查看日志信息。