更新时间:2025-12-01 GMT+08:00

请求URI

服务的请求URI即API服务的终端地址,通过该地址与API进行通信和交互。

URI获取步骤如下:

- 登录ModelArts Studio大模型开发平台。

- 进入所需工作空间。

- 获取请求URI。

- 获取模型请求URI。

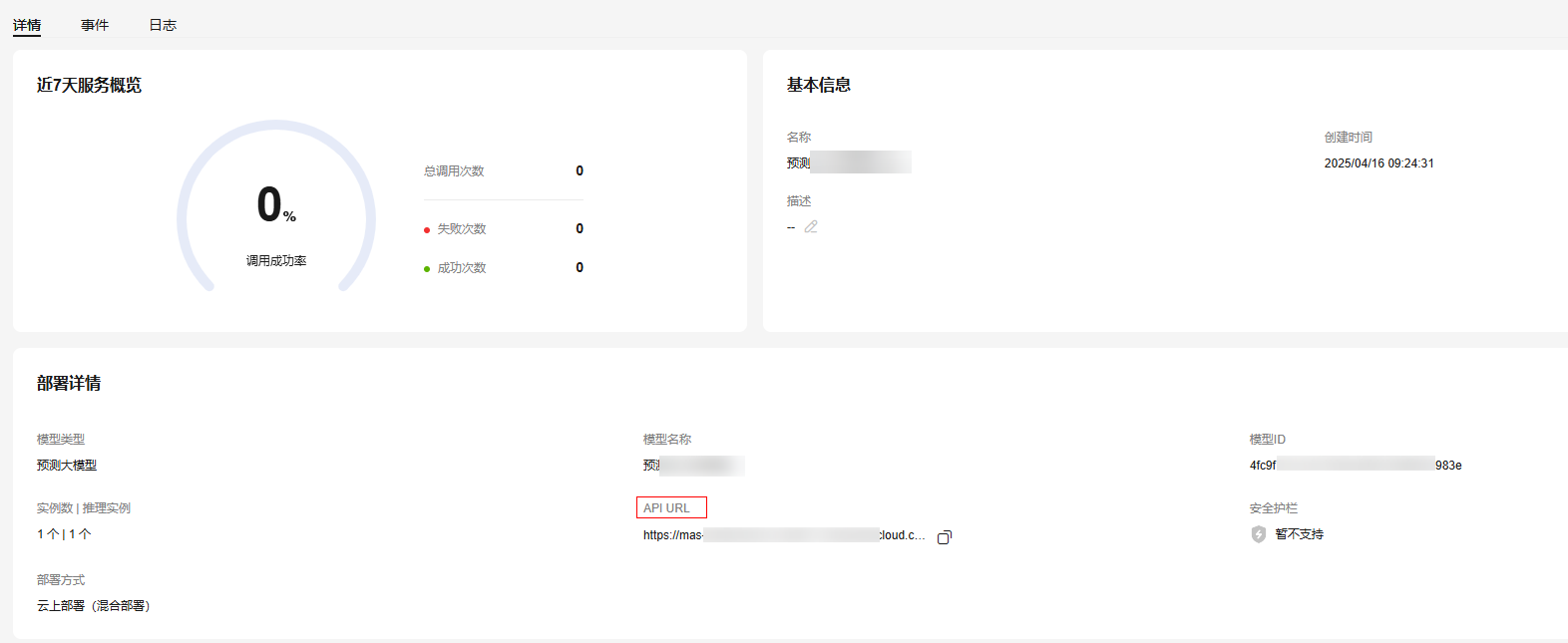

- 若调用部署后的模型,可在左侧导航栏中选择“模型开发 > 模型部署”,在“我的服务”页签,模型部署列表单击模型名称,在“详情”页签中,可获取模型的请求URI。

图1 部署后的模型调用路径

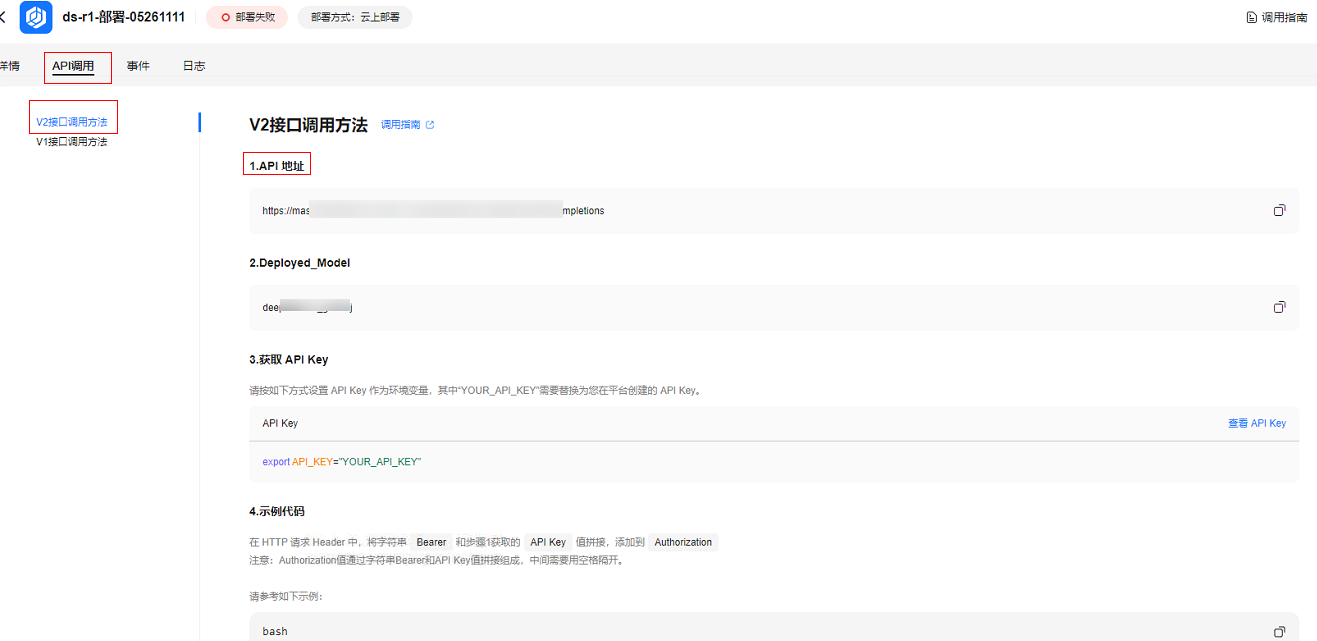

若调用的是用户自己部署的NLP推理服务,可在“API调用”页签中,可获取V1接口URL或者V2接口URI。

图2 NLP服务的调用路径

- 若调用预置模型,可在左侧导航栏中选择“模型开发 > 模型部署”,在“预置服务”页签,模型列表单击“调用路径”,获取该模型的请求URI。

图3 预置模型的调用路径

- 若调用部署后的模型,可在左侧导航栏中选择“模型开发 > 模型部署”,在“我的服务”页签,模型部署列表单击模型名称,在“详情”页签中,可获取模型的请求URI。

- 获取Agent应用请求URI。

- 单击左侧导航栏“Agent开发”,进入“工作台 > 应用”页面,选择需要部署的应用,单击“

> 调用路径”。

> 调用路径”。 - 在“调用路径”页面可获取Agent应用请求URI。

图4 调用路径

- 单击左侧导航栏“Agent开发”,进入“工作台 > 应用”页面,选择需要部署的应用,单击“

- 获取模型请求URI。

父主题: 使用前必读