推理部署使用场景

推理部署(Inference Deployment)是人工智能和机器学习领域中的一个重要环节。推理部署是指将训练好的机器学习或深度学习模型,从开发环境转移到实际生产环境中,使其能够对新的、未见过的数据进行预测或推理的过程,确保模型在实际应用中高效、稳定运行,同时满足实时性和资源限制的要求。简单来说,就是让模型在实际应用中发挥作用,根据输入数据给出相应的输出结果,例如对图像进行分类、对文本进行情感分析、对未来趋势进行预测等。

AI模型开发完成后,ModelArts提供计算资源、存储资源和网络部署,方便用户进行模型的部署、推理、管理和监控。ModelArts支持云端、边端多场景部署,同时支持在线推理、批量推理、边缘推理多形态部署。

部署方式介绍

ModelArts支持云端场景部署,同时ModelArts支持在线推理、批量推理多形态部署。

- 在线推理:实时推理,通过实时处理单个请求并同步返回结果。ModelArts支持将模型部署为一个Web Service,并且提供在线的测试UI与监控功能。部署成功的在线服务,将为用户提供一个可调用的API。在线推理常用于对实时性要求较高的场景,如在线智能客服、自动驾驶中的实时决策等。

- 批量推理:将多个输入数据批量处理,一次性返回所有结果。ModelArts支持将模型部署为批量服务,批量服务可对批量数据进行推理,完成数据处理后自动停止。批量推理适用于对大量数据进行离线分析和处理的场景,如大数据分析、批量数据标注、模型评估等。

计费说明

在ModelArts进行服务部署时,会产生计算资源和存储资源的累计值计费。计算资源为运行推理服务的费用。存储资源包括数据存储到OBS的计费。具体内容如表1所示。

|

计费项 |

计费项说明 |

适用的计费模式 |

计费公式 |

|

|---|---|---|---|---|

|

计算资源 |

公共资源池 |

使用计算资源的用量。 具体费用可参见ModelArts价格详情。 |

按需计费 |

规格单价 * 计算节点个数 * 使用时长 |

|

专属资源池 |

专属资源池的费用已在购买时支付,部署服务不再收费。 专属资源池的费用请参考专属资源池计费项。 |

- |

- |

|

|

存储资源 |

对象存储OBS |

用于存储批量部署服务的输入和输出数据。 具体费用可参见对象存储价格详情。

注意:

存储到OBS中的数据需在OBS控制台进行手动删除。如果未删除,则会按照OBS的计费规则进行持续计费。 |

按需计费 包年/包月 |

创建桶不收取费用,按实际使用的存储容量和时长收费 |

|

事件通知(不开启则不计费) |

订阅消息使用消息通知服务,在事件列表中选择特定事件,在事件发生时发送消息通知。 如果想使用消息通知,需要在创建训练作业时开启“事件通知”功能。 具体计费可见消息通知服务价格详情。 |

按实际用量付费 |

|

|

|

运行日志(不开启则不计费) |

由云日志服务(LTS)提供日志收集、分析、存储等服务。 部署服务时,开启“运行日志输出”后,日志数据超出LTS免费额度后,会产生费用。具体可云日志服务价格详情 |

按实际日志量付费 |

超过免费额度后,按实际日志存储量和存储时长收费 |

|

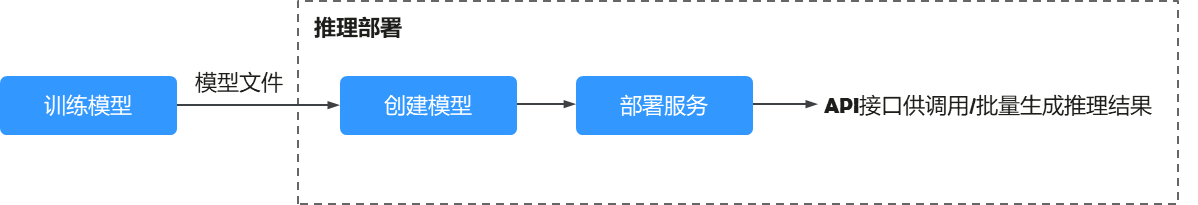

推理部署流程

AI模型开发完成后,在ModelArts服务中可以将AI模型创建为模型,将模型快速部署为推理服务,您可以通过调用API的方式把AI推理能力集成到自己的IT平台,或者批量生成推理结果。

- 准备推理资源:根据实际情况选择部署服务所需要的资源类型。ModelArts为您提供公共资源池和专属资源池。如果使用专属计算资源,您需要先购买并创建专属资源池,详情请参见创建专属资源池。

- 训练模型:可以在ModelArts服务中进行,也可以在您的本地开发环境进行,本地开发的模型需要上传到华为云OBS服务。

- 创建模型:把模型文件和推理文件导入到ModelArts的模型仓库中,进行版本化管理,并构建为可运行的模型。

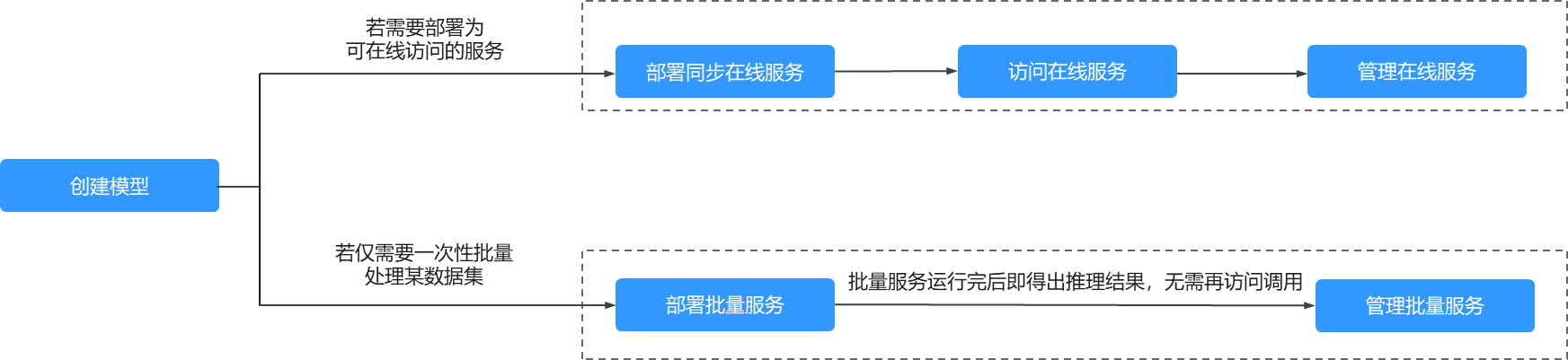

- 部署服务:模型构建完成后,根据您的业务场景,选择将模型部署成对应的服务类型。

- 将模型部署为实时推理作业

将模型部署为一个Web Service,并且提供在线的测试UI与监控功能,部署成功的在线服务,将为用户提供一个可调用的API。

- 将模型部署为批量推理服务

批量服务可对批量数据进行推理,完成数据处理后自动停止。

图2 不同类型的推理作业使用场景

- 将模型部署为实时推理作业