MRS集群阈值类告警配置说明

应用场景

MRS集群提供可视化、便捷的监控告警功能。用户可以快速获取集群关键性能指标,并评测集群健康状态。

MRS支持配置监控指标阈值用于关注各指标的健康情况,如果出现异常的数据并满足预设条件后,系统将会触发告警信息,并在告警页面中出现此告警信息。

如果部分阈值类监控告警经评估后对业务影响可忽略、或告警阈值可进行调整,用户也可以根据需要自定义集群监控指标,或屏蔽对应告警,使告警不再上报。

MRS集群阈值转告警监控指标可分为节点信息指标与集群服务指标,相关指标及其对系统的影响、默认阈值等信息请参考监控指标参考。

方案架构

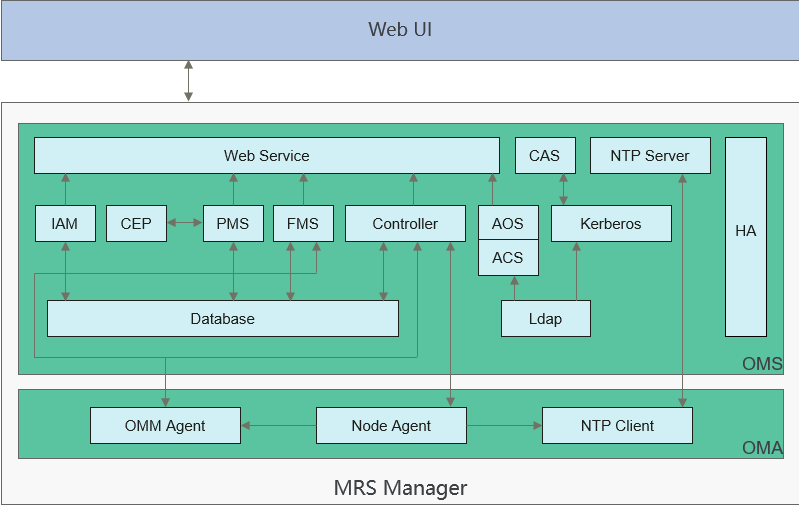

Manager的整体逻辑架构如图1所示。

Manager由OMS和OMA组成:

- OMS:操作维护系统的管理节点,OMS一般有两个,互为主备。

- OMA:操作维护系统中的被管理节点,一般有多个。

FMS为Manager中的告警模块,负责收集每一个OMA上的告警并提供查询。

约束与限制

阈值类告警通常会对集群功能的正常使用、或作业的运行等有一定影响,如需屏蔽或修改告警规则等,请提前评估操作风险。

修改阈值类告警触发规则

- 参考访问FusionInsight Manager(MRS 3.x及之后版本)登录MRS集群的FusionInsight Manager界面。

- 选择。

- 在监控分类中选择集群内指定主机或服务的监控指标。例如选择“主机内存使用率”。

图2 查看阈值告警信息

其中:

其中:- 开关:开启表示将触发告警。

- 平滑次数:Manager会检查监控指标数值是否满足阈值条件,若连续检查且不满足的次数等于“平滑次数”设置的值则发送告警,支持自定义。对于同一告警上报较频繁的场景,用户可通过单击编辑按钮适当调高平滑次数,降低告警频率。

- 检查周期(秒):表示Manager检查监控指标的时间间隔。

- 规则列表中的条目为触发告警的规则。

- 修改告警规则。

- 添加新规则

- 单击“添加规则”,参考表1新增指标的监控行为。

- 单击“确定”保存规则。

- 在当前已应用规则的所在行,单击“操作”中的“取消应用”。如果没有已应用的规则,则请跳过该步骤。

- 在新添加规则的所在行,单击“操作”中的“应用”,此时规则的“生效状态”变成“生效”。

- 修改已有规则

- 单击待修改规则“操作”列的“修改”。

- 参考表1修改相关规则参数。

- 单击“确定”保存。

以下样例以修改“主机内存使用率”为例进行说明。

- 添加新规则

屏蔽指定告警上报

- 参考访问FusionInsight Manager(MRS 3.x及之后版本)登录MRS集群的FusionInsight Manager界面。

- 选择。

- 在“屏蔽设置”区域,选择指定的服务或模块。

- 单击待操作告警对应“操作”列的“屏蔽”,在弹出的对话框中单击“确定”,修改告警的屏蔽状态为“屏蔽”。

图3 屏蔽告警

- 可以在屏蔽列表上方筛选指定的告警。

- 如果需要取消屏蔽,可以单击指定告警后的“取消屏蔽”,在弹出的对话框中单击“确定”,修改告警的屏蔽状态为“显示”。

- 如果需要一次操作多个告警,可以勾选多个待操作的告警后,单击列表上方的“屏蔽”或“取消屏蔽”。

常见问题

- 如何查看当前集群未清除告警?

- 登录MRS管理控制台。

- 单击待操作的集群名称,选择“告警管理”页签。

- 单击“高级搜索”,将“告警状态”设置为“未清除”,单击“搜索”。

- 界面将显示当前集群未清除的告警。

- 集群发生告警后如何清除?

集群发生告警后,可以查看对应告警的帮助文档进行处理。帮助文档查看入口如下:

- 管理控制台:登录MRS管理控制台,单击待操作的集群名称,选择“告警管理”页签,在告警列表中单击对应操作列的“查看帮助”。然后参考对应告警帮助文档处理步骤进行处理。

- Manager页面:登录Manager页面,选择“运维 > 告警 > 告警”,单击对应操作列的“查看帮助”。然后参考对应告警帮助文档处理步骤进行处理。

监控指标参考

FusionInsight Manager转告警监控指标可分为节点信息指标与集群服务指标。表2表示节点中可配置阈值的指标、表3表示组件可配置阈值的指标。

|

监控指标组名称 |

监控指标名称 |

告警ID |

告警名称 |

告警对系统的影响 |

默认阈值 |

|---|---|---|---|---|---|

|

CPU |

主机CPU使用率 |

12016 |

CPU使用率超过阈值 |

业务进程响应缓慢或不可用。 |

90.0% |

|

磁盘 |

磁盘使用率 |

12017 |

磁盘容量不足 |

业务进程不可用。 |

90.0% |

|

磁盘inode使用率 |

12051 |

磁盘Inode使用率超过阈值 |

文件系统无法正常写入。 |

80.0% |

|

|

内存 |

主机内存使用率 |

12018 |

内存使用率超过阈值 |

业务进程响应缓慢或不可用。 |

90.0% |

|

主机状态 |

主机文件句柄使用率 |

12053 |

主机文件句柄使用率超过阈值 |

系统应用无法打开文件、网络等IO操作,程序异常。 |

80.0% |

|

主机PID使用率 |

12027 |

主机PID使用率超过阈值 |

无法分配PID给新的业务进程,业务进程不可用。 |

90% |

|

|

网络状态 |

TCP临时端口使用率 |

12052 |

TCP临时端口使用率超过阈值 |

主机上业务无法发起对外建立连接,业务中断。 |

80.0% |

|

网络读信息 |

读包错误率 |

12047 |

网络读包错误率超过阈值 |

通信闪断,业务超时。 |

0.5% |

|

读包丢包率 |

12045 |

网络读包丢包率超过阈值 |

业务性能下降或者个别业务出现超时问题。 |

0.5% |

|

|

读吞吐率 |

12049 |

网络读吞吐率超过阈值 |

业务系统运行不正常或不可用。 |

80% |

|

|

网络写信息 |

写包错误率 |

12048 |

网络写包错误率超过阈值 |

通信闪断,业务超时。 |

0.5% |

|

写包丢包率 |

12046 |

网络写包丢包率超过阈值 |

业务性能下降或者个别业务出现超时问题。 |

0.5% |

|

|

写吞吐率 |

12050 |

网络写吞吐率超过阈值 |

业务系统运行不正常或不可用。 |

80% |

|

|

进程 |

D状态和Z状态进程总数 |

12028 |

主机D状态和Z状态进程数超过阈值 |

占用系统资源,业务进程响应变慢。 |

0 |

|

omm进程使用率 |

12061 |

进程使用率超过阈值 |

无法切换到omm用户。无法创建新的omm线程。 |

90 |

|

服务 |

监控指标名称 |

告警ID |

告警名称 |

告警对系统的影响 |

默认阈值 |

|---|---|---|---|---|---|

|

DBService |

数据库连接数使用率 |

27005 |

数据库连接数使用率超过阈值 |

可能导致上层服务无法连接DBService的数据库,影响正常业务。 |

90% |

|

数据目录磁盘空间使用率 |

27006 |

数据目录磁盘空间使用率超过阈值 |

业务进程不可用。 当数据目录磁盘空间使用率超过90%时,数据库进入只读模式并发送告警“数据库进入只读模式”,业务数据丢失。 |

80% |

|

|

Flume |

Flume堆内存使用率 |

24006 |

Flume Server堆内存使用率超过阈值 |

堆内存溢出可能导致服务崩溃。 |

95.0% |

|

Flume直接内存使用率 |

24007 |

Flume Server直接内存使用率超过阈值 |

直接内存溢出可能导致服务崩溃。 |

80.0% |

|

|

Flume非堆内存使用率 |

24008 |

Flume Server非堆内存使用率超过阈值 |

非堆内存溢出可能导致服务崩溃。 |

80.0% |

|

|

Flume垃圾回收(GC)总时间 |

24009 |

Flume Server垃圾回收(GC)时间超过阈值 |

导致Flume数据传输效率低下。 |

12000ms |

|

|

HBase |

GC中回收old区所花时长 |

19007 |

HBase GC时间超出阈值 |

老年代GC时间超出阈值,会影响到HBase数据的读写。 |

5000ms |

|

RegionServer直接内存使用率统计 |

19009 |

HBase服务进程直接内存使用率超出阈值 |

HBase可用的直接内存不足,可能会造成内存溢出导致服务崩溃。 |

90% |

|

|

RegionServer堆内存使用率统计 |

19008 |

HBase服务进程堆内存使用率超出阈值 |

HBase可用内存不足,可能会造成内存溢出导致服务崩溃。 |

90% |

|

|

HMaster直接内存使用率统计 |

19009 |

HBase服务进程直接内存使用率超出阈值 |

HBase可用的直接内存不足,可能会造成内存溢出导致服务崩溃。 |

90% |

|

|

HMaster堆内存使用率统计 |

19008 |

HBase服务进程堆内存使用率超出阈值 |

HBase可用内存不足,可能会造成内存溢出导致服务崩溃。 |

90% |

|

|

单个RegionServer的region数目 |

19011 |

RegionServer的Region数量超出阈值 |

RegionServer的Region数超出阈值,会影响HBase的数据读写性能。 |

2000 |

|

|

处在RIT状态达到阈值时长的region数 |

19013 |

region处在RIT状态的时长超过阈值。 |

表的部分数据丢失或不可用。 |

1 |

|

|

RegionServer的handler使用 |

19021 |

RegionServer活跃handler数超过阈值 |

RegionServer的handler使用率超出阈值,会影响RegionServer对外提供服务的能力,如果集群的大部分RegionServer的handler使用率超过阈值,可导致HBase无法对外提供服务。 |

90% |

|

|

容灾同步失败次数 |

19006 |

HBase容灾同步失败 |

无法同步集群中HBase的数据到备集群,导致主备集群数据不一致。 |

1 |

|

|

主集群等待同步的日志文件数量 |

19020 |

HBase容灾等待同步的wal文件数量超过阈值 |

RegionServer等待同步的wal文件数量超出阈值,会影响HBase使用的znode超出阈值,影响HBase服务状态。 |

128 |

|

|

主集群等待同步的HFile文件数量 |

19019 |

HBase容灾等待同步的HFile文件数量超过阈值 |

RegionServer等待同步的HFile文件数量超出阈值,会影响HBase使用的znode超出阈值,影响HBase服务状态。 |

128 |

|

|

Compaction操作队列大小 |

19018 |

HBase合并队列超出阈值 |

产生该告警表示HBase服务的compaction队列长度已经超过规定的阈值,如果不及时处理,可能会导致集群性能下降,影响数据读写。 |

100 |

|

|

HDFS |

HDFS缺失的块数量 |

14003 |

丢失的HDFS块数量超过阈值 |

HDFS存储数据丢失,HDFS可能会进入安全模式,无法提供写服务。丢失的块数据无法恢复。 |

0 |

|

需要复制副本的块总数 |

14028 |

待补齐的块数超过阈值 |

HDFS存储数据丢失,HDFS可能会进入安全模式,无法提供写服务。丢失的块数据无法恢复。 |

1000 |

|

|

主NameNode RPC处理平均时间 |

14021 |

NameNode RPC处理平均时间超过阈值 |

NameNode无法及时处理来自HDFS客户端、依赖于HDFS的上层服务、DataNode等的RPC请求,表现为访问HDFS服务的业务运行缓慢,严重时会导致HDFS服务不可用。 |

100ms |

|

|

主NameNode RPC队列平均时间 |

14022 |

NameNode RPC队列平均时间超过阈值 |

NameNode无法及时处理来自HDFS客户端、依赖于HDFS的上层服务、DataNode等的RPC请求,表现为访问HDFS服务的业务运行缓慢,严重时会导致HDFS服务不可用。 |

200ms |

|

|

HDFS磁盘空间使用率 |

14001 |

HDFS磁盘空间使用率超过阈值 |

HDFS集群磁盘容量不足,会影响到HDFS的数据写入。 |

80% |

|

|

DataNode磁盘空间使用率 |

14002 |

DataNode磁盘空间使用率超过阈值 |

DataNode容量不足,会影响到HDFS的数据写入。 |

80% |

|

|

总副本预留磁盘空间所占比率 |

14023 |

总副本预留磁盘空间所占比率超过阈值 |

HDFS集群磁盘容量不足,会影响到HDFS的数据写入。如果DataNode的剩余空间都已经给副本预留,则写入HDFS数据失败。 |

90% |

|

|

故障的DataNode总数 |

14009 |

Dead DataNode数量超过阈值 |

故障状态的DataNode节点无法提供HDFS服务。 |

3 |

|

|

NameNode非堆内存使用百分比统计 |

14018 |

NameNode非堆内存使用率超过阈值 |

HDFS NameNode非堆内存使用率过高,会影响HDFS的数据读写性能。 |

90% |

|

|

NameNode直接内存使用百分比统计 |

14017 |

NameNode直接内存使用率超过阈值 |

NameNode可用直接内存不足,可能会造成内存溢出导致服务崩溃。 |

90% |

|

|

NameNode堆内存使用百分比统计 |

14007 |

NameNode堆内存使用率超过阈值 |

HDFS NameNode堆内存使用率过高,会影响HDFS的数据读写性能。 |

95% |

|

|

DataNode直接内存使用百分比统计 |

14016 |

DataNode直接内存使用率超过阈值 |

DataNode可用直接内存不足,可能会造成内存溢出导致服务崩溃。 |

90% |

|

|

DataNode堆内存使用百分比统计 |

14008 |

DataNode堆内存使用率超过阈值 |

HDFS DataNode堆内存使用率过高,会影响到HDFS的数据读写性能。 |

95% |

|

|

DataNode非堆内存使用百分比统计 |

14019 |

DataNode非堆内存使用率超过阈值 |

HDFS DataNode非堆内存使用率过高,会影响HDFS的数据读写性能。 |

90% |

|

|

垃圾回收时间统计(GC)(NameNode) |

14014 |

NameNode进程垃圾回收(GC)时间超过阈值 |

NameNode进程的垃圾回收时间过长,可能影响该NameNode进程正常提供服务。 |

12000ms |

|

|

垃圾回收时间统计(GC)(DataNode) |

14015 |

DataNode进程垃圾回收(GC)时间超过阈值 |

DataNode进程的垃圾回收时间过长,可能影响该DataNode进程正常提供服务。 |

12000ms |

|

|

Hive |

Hive执行成功的HQL百分比 |

16002 |

Hive SQL执行成功率低于阈值 |

系统执行业务能力过低,无法正常响应客户请求。 |

90.0% |

|

Background线程使用率 |

16003 |

Background线程使用率超过阈值 |

后台Background线程数过多,导致新提交的任务无法及时运行。 |

90% |

|

|

MetaStore的总GC时间 |

16007 |

Hive GC时间超出阈值 |

GC时间超出阈值,会影响到Hive数据的读写。 |

12000ms |

|

|

HiveServer的总GC时间 |

16007 |

Hive GC时间超出阈值 |

GC时间超出阈值,会影响到Hive数据的读写。 |

12000ms |

|

|

Hive已经使用的HDFS空间占可使用空间的百分比 |

16001 |

Hive数据仓库空间使用率超过阈值 |

系统可能无法正常写入数据,导致部分数据丢失。 |

85.0% |

|

|

MetaStore直接内存使用率统计 |

16006 |

Hive服务进程直接内存使用超出阈值 |

Hive直接内存使用率过高,会影响Hive任务运行的性能,甚至造成内存溢出导致Hive服务不可用。 |

95% |

|

|

MetaStore非堆内存使用率统计 |

16008 |

Hive服务进程非堆内存使用超出阈值 |

Hive非堆内存使用率过高,会影响Hive任务运行的性能,甚至造成内存溢出导致Hive服务不可用。 |

95% |

|

|

MetaStore堆内存使用率统计 |

16005 |

Hive服务进程堆内存使用超出阈值 |

Hive堆内存使用率过高,会影响Hive任务运行的性能,甚至造成内存溢出导致Hive服务不可用。 |

95% |

|

|

HiveServer直接内存使用率统计 |

16006 |

Hive服务进程直接内存使用超出阈值 |

Hive直接内存使用率过高,会影响Hive任务运行的性能,甚至造成内存溢出导致Hive服务不可用。 |

95% |

|

|

HiveServer非堆内存使用率统计 |

16008 |

Hive服务进程非堆内存使用超出阈值 |

Hive非堆内存使用率过高,会影响Hive任务运行的性能,甚至造成内存溢出导致Hive服务不可用。 |

95% |

|

|

HiveServer堆内存使用率统计 |

16005 |

Hive服务进程堆内存使用超出阈值 |

Hive堆内存使用率过高,会影响Hive任务运行的性能,甚至造成内存溢出导致Hive服务不可用。 |

95% |

|

|

连接到HiveServer的session数占最大允许session数的百分比 |

16000 |

连接到HiveServer的session数占最大允许数的百分比超过阈值 |

发生连接数告警时,表示连接到HiveServer的session数过多,将会导致无法建立新的连接。 |

90.0% |

|

|

Kafka |

未完全同步的Partition百分比 |

38006 |

Kafka未完全同步的Partition百分比超过阈值 |

Kafka服务未完全同步的Partition数过多,会影响服务的可靠性,一旦发生leader切换,可能会导致丢数据。 |

50% |

|

broker上用户连接数使用率 |

38011 |

Broker上用户连接数使用率超过设定阈值 |

当同一个用户连接数太多时,产生告警的用户将无法与Broker建立新的连接。 |

80% |

|

|

Broker磁盘使用率 |

38001 |

Kafka磁盘容量不足 |

磁盘容量不足会导致Kafka写入数据失败。 |

80.0% |

|

|

Broker磁盘IO使用率 |

38009 |

Broker磁盘IO繁忙 |

Partition所在的磁盘分区IO过于繁忙,产生告警的Kafka Topic上可能无法写入数据。 |

80% |

|

|

Broker每分钟的垃圾回收时间统计(GC) |

38005 |

Broker进程垃圾回收(GC)时间超过阈值 |

Broker进程的垃圾回收时间过长,可能影响该Broker进程正常提供服务。 |

12000ms |

|

|

Kafka堆内存使用率 |

38002 |

Kafka堆内存使用率超过阈值 |

Kafka可用内存不足,可能会造成内存溢出导致服务崩溃。 |

95% |

|

|

Kafka直接内存使用率 |

38004 |

Kafka直接内存使用率超过阈值 |

Kafka可用直接内存不足,可能会造成内存溢出导致服务崩溃。 |

95% |

|

|

Loader |

Loader堆内存使用率 |

23004 |

Loader堆内存使用率超过阈值 |

堆内存溢出可能导致服务崩溃。 |

95% |

|

Loader直接内存使用率统计 |

23006 |

Loader直接内存使用率超过阈值 |

直接内存溢出可能导致服务崩溃。 |

80.0% |

|

|

Loader非堆内存使用率 |

23005 |

Loader非堆内存使用率超过阈值 |

非堆内存溢出可能导致服务崩溃。 |

80% |

|

|

Loader的总GC时间 |

23007 |

Loader进程垃圾回收(GC)时间超过阈值 |

导致Loader服务响应缓慢。 |

12000ms |

|

|

Mapreduce |

垃圾回收时间统计(GC) |

18012 |

JobHistoryServer进程垃圾回收(GC)时间超过阈值 |

JobHistoryServer进程的垃圾回收时间过长,可能影响该JobHistoryServer进程正常提供服务。 |

12000ms |

|

JobHistoryServer直接内存使用百分比统计 |

18015 |

JobHistoryServer直接内存使用率超过阈值 |

MapReduce可用直接内存不足,可能会造成内存溢出导致服务崩溃。 |

90% |

|

|

JobHistoryServer非堆内存使用百分比统计 |

18019 |

JobHistoryServer非堆内存使用率超过阈值 |

MapReduce JobHistoryServer非堆内存使用率过高,会影响MapReduce任务提交和运行的性能,甚至造成内存溢出导致MapReduce服务不可用。 |

90% |

|

|

JobHistoryServer堆内存使用百分比统计 |

18009 |

JobHistoryServer堆内存使用率超过阈值 |

Mapreduce JobHistoryServer堆内存使用率过高,会影响Mapreduce服务日志归档的性能,甚至造成内存溢出导致Mapreduce服务不可用。 |

95% |

|

|

Oozie |

Oozie堆内存使用率 |

17004 |

Oozie堆内存使用率超过阈值 |

堆内存溢出可能导致服务崩溃。 |

95.0% |

|

Oozie直接内存使用率 |

17006 |

Oozie直接内存使用率超过阈值 |

直接内存溢出可能导致服务崩溃。 |

80.0% |

|

|

Oozie非堆内存使用率 |

17005 |

Oozie非堆内存使用率超过阈值 |

非堆内存溢出可能导致服务崩溃。 |

80% |

|

|

Oozie垃圾回收(GC)总时间 |

17007 |

Oozie垃圾回收(GC)时间超过阈值 |

导致Oozie提交任务响应变慢。 |

12000ms |

|

|

Spark2x |

JDBCServer2x堆内存使用率统计 |

43010 |

JDBCServer2x进程堆内存使用超出阈值 |

JDBCServer2x进程堆内存使用率过高,会影响JDBCServer2x进程运行的性能,甚至造成内存溢出导致JDBCServer2x进程不可用。 |

95% |

|

JDBCServer2x直接内存使用率统计 |

43012 |

JDBCServer2x进程直接内存使用超出阈值 |

JDBCServer2x进程直接内存使用率过高,会影响JDBCServer2x进程运行的性能,甚至造成内存溢出导致JDBCServer2x进程不可用。 |

95% |

|

|

JDBCServer2x非堆内存使用率统计 |

43011 |

JDBCServer2x进程非堆内存使用超出阈值 |

JDBCServer2x进程非堆内存使用率过高,会影响JDBCServer2x进程运行的性能,甚至造成内存溢出导致JDBCServer2x进程不可用。 |

95% |

|

|

JobHistory2x直接内存使用率统计 |

43008 |

JobHistory2x进程直接内存使用超出阈值 |

JobHistory2x进程直接内存使用率过高,会影响JobHistory2x进程运行的性能,甚至造成内存溢出导致JobHistory2x进程不可用。 |

95% |

|

|

JobHistory2x非堆内存使用率统计 |

43007 |

JobHistory2x进程非堆内存使用超出阈值 |

JobHistory2x进程非堆内存使用率过高,会影响JobHistory2x进程运行的性能,甚至造成内存溢出导致JobHistory2x进程不可用。 |

95% |

|

|

JobHistory2x堆内存使用率统计 |

43006 |

JobHistory2x进程堆内存使用超出阈值 |

JobHistory2x进程堆内存使用率过高,会影响JobHistory2x进程运行的性能,甚至造成内存溢出导致JobHistory2x进程不可用。 |

95% |

|

|

IndexServer2x直接内存使用率统计 |

43021 |

IndexServer2x进程直接内存使用超出阈值 |

IndexServer2x进程直接内存使用率过高,会影响IndexServer2x进程运行的性能,甚至造成内存溢出导致IndexServer2x进程不可用。 |

95% |

|

|

IndexServer2x堆内存使用率统计 |

43019 |

IndexServer2x进程堆内存使用超出阈值 |

IndexServer2x进程堆内存使用率过高,会影响IndexServer2x进程运行的性能,甚至造成内存溢出导致IndexServer2x进程不可用。 |

95% |

|

|

IndexServer2x非堆内存使用率统计 |

43020 |

IndexServer2x进程非堆内存使用超出阈值 |

IndexServer2x进程非堆内存使用率过高,会影响IndexServer2x进程运行的性能,甚至造成内存溢出导致IndexServer2x进程不可用。 |

95% |

|

|

JDBCServer2x的Full GC次数 |

43017 |

JDBCServer2x进程Full GC次数超出阈值 |

GC次数超出阈值,会影响JDBCServer2x进程运行的性能,甚至造成JDBCServer2x进程不可用。 |

12 |

|

|

JobHistory2x的Full GC次数 |

43018 |

JobHistory2x进程Full GC次数超出阈值 |

GC次数超出阈值,会影响JobHistory2x进程运行的性能,甚至造成JobHistory2x进程不可用。 |

12 |

|

|

IndexServer2x的Full GC次数 |

43023 |

IndexServer2x进程Full GC次数超出阈值 |

GC次数超出阈值,会影响IndexServer2x进程运行的性能,甚至造成IndexServer2x进程不可用。 |

12 |

|

|

JDBCServer2x的总GC时间 |

43013 |

JDBCServer2x进程GC时间超出阈值 |

GC时间超出阈值,会影响JDBCServer2x进程运行的性能,甚至造成JDBCServer2x进程不可用。 |

12000ms |

|

|

JobHistory2x的总GC时间 |

43009 |

JobHistory2x进程GC时间超出阈值 |

GC时间超出阈值,会影响JobHistory2x进程运行的性能,甚至造成JobHistory2x进程不可用。 |

12000ms |

|

|

IndexServer2x的总GC时间 |

43022 |

IndexServer2x进程GC时间超出阈值 |

GC时间超出阈值,会影响IndexServer2x进程运行的性能,甚至造成IndexServer2x进程不可用。 |

12000ms |

|

|

Storm |

Supervisor数 |

26052 |

Storm服务可用Supervisor数量小于阈值 |

集群已经存在的任务无法运行;集群可接收新的Storm任务,但是无法运行。 |

1 |

|

已用Slot比率 |

26053 |

Storm Slot使用率超过阈值 |

用户无法执行新的Storm任务。 |

80.0% |

|

|

Nimbus堆内存使用率 |

26054 |

Nimbus堆内存使用率超过阈值 |

Storm Nimbus堆内存使用率过高时可能造成频繁GC,甚至造成内存溢出,进而影响Storm任务提交。 |

80% |

|

|

Yarn |

NodeManager直接内存使用百分比统计 |

18014 |

NodeManager直接内存使用率超过阈值 |

NodeManager可用直接内存不足,可能会造成内存溢出导致服务崩溃。 |

90% |

|

NodeManager堆内存使用百分比统计 |

18018 |

NodeManager堆内存使用率超过阈值 |

NodeManager堆内存使用率过高,会影响Yarn任务提交和运行的性能,甚至可能会造成内存溢出导致Yarn服务崩溃。 |

95% |

|

|

NodeManager非堆内存使用百分比统计 |

18017 |

NodeManager非堆内存使用率超过阈值 |

Yarn NodeManager非堆内存使用率过高,会影响Yarn任务提交和运行的性能,甚至造成内存溢出导致Yarn服务不可用。 |

90% |

|

|

ResourceManager直接内存使用百分比统计 |

18013 |

ResourceManager直接内存使用率超过阈值 |

ResourceManager可用直接内存不足,可能会造成内存溢出导致服务崩溃。 |

90% |

|

|

ResourceManager堆内存使用百分比统计 |

18008 |

ResourceManager堆内存使用率超过阈值 |

Yarn ResourceManager堆内存使用率过高,会影响Yarn任务提交和运行的性能,甚至造成内存溢出导致Yarn服务不可用。 |

95% |

|

|

ResourceManager非堆内存使用百分比统计 |

18016 |

ResourceManager非堆内存使用率超过阈值 |

Yarn ResourceManager非堆内存使用率过高,会影响Yarn任务提交和运行的性能,甚至造成内存溢出导致Yarn服务不可用。 |

90% |

|

|

垃圾回收时间统计(GC) (NodeManager) |

18011 |

NodeManager进程垃圾回收(GC)时间超过阈值 |

NodeManager进程的垃圾回收时间过长,可能影响该NodeManager进程正常提供服务。 |

12000ms |

|

|

垃圾回收时间统计(GC)(ResourceManager) |

18010 |

ResourceManager进程垃圾回收(GC)时间超过阈值 |

ResourceManager进程的垃圾回收时间过长,可能影响该ResourceManager进程正常提供服务。 |

12000ms |

|

|

root队列下失败的任务数 |

18026 |

Yarn上运行失败的任务数超过阈值 |

大量应用任务运行失败。 运行失败的任务需要重新提交。 |

50 |

|

|

root队列下被杀死的任务数 |

18025 |

Yarn被终止的任务数超过阈值 |

大量应用任务被强制终止。 |

50 |

|

|

挂起的内存量 |

18024 |

Yarn任务挂起内存超过阈值 |

应用任务结束时间变长。 新应用提交后长时间无法运行。 |

83886080MB |

|

|

正在挂起的任务 |

18023 |

Yarn任务挂起数超过阈值 |

应用任务结束时间变长。 新应用提交后长时间无法运行。 |

60 |

|

|

ZooKeeper |

ZooKeeper连接数使用率 |

13001 |

ZooKeeper可用连接数不足 |

ZooKeeper可用连接数不足,当连接率超过100%时无法处理外部连接。 |

80% |

|

ZooKeeper堆内存使用率 |

13004 |

ZooKeeper堆内存使用率超过阈值 |

ZooKeeper可用内存不足,可能会造成内存溢出导致服务崩溃。 |

95% |

|

|

ZooKeeper直接内存使用率 |

13002 |

ZooKeeper直接内存使用率超过阈值 |

ZooKeeper可用内存不足,可能会造成内存溢出导致服务崩溃。 |

80% |

|

|

ZooKeeper每分钟的垃圾回收时间统计(GC) |

13003 |

ZooKeeper进程垃圾回收(GC)时间超过阈值 |

ZooKeeper进程的垃圾回收时间过长,可能影响该ZooKeeper进程正常提供服务。 |

12000ms |

|

|

Ranger |

UserSync垃圾回收(GC)时间 |

45284 |

UserSync垃圾回收(GC)时间超过阈值 |

导致UserSync响应缓慢。 |

12000ms |

|

PolicySync垃圾回收(GC)时间 |

45292 |

PolicySync垃圾回收(GC)时间超过阈值 |

导致PolicySync响应缓慢。 |

12000ms |

|

|

RangerAdmin垃圾回收(GC)时间 |

45280 |

RangerAdmin垃圾回收(GC)时间超过阈值 |

导致RangerAdmin响应缓慢。 |

12000ms |

|

|

TagSync垃圾回收(GC)时间 |

45288 |

TagSync垃圾回收(GC)时间超过阈值 |

导致TagSync响应缓慢。 |

12000ms |

|

|

UserSync非堆内存使用率 |

45283 |

UserSync非堆内存使用率超过阈值 |

非堆内存溢出可能导致服务崩溃。 |

80.0% |

|

|

UserSync直接内存使用率 |

45282 |

UserSync直接内存使用率超过阈值 |

直接内存溢出可能导致服务崩溃。 |

80.0% |

|

|

UserSync堆内存使用率 |

45281 |

UserSync堆内存使用率超过阈值 |

堆内存溢出可能导致服务崩溃。 |

95.0% |

|

|

PolicySync直接内存使用率 |

45290 |

PolicySync直接内存使用率超过阈值 |

直接内存溢出可能导致服务崩溃。 |

80.0% |

|

|

PolicySync堆内存使用率 |

45289 |

PolicySync堆内存使用率超过阈值 |

堆内存溢出可能导致服务崩溃。 |

95.0% |

|

|

PolicySync非堆内存使用率 |

45291 |

PolicySync非堆内存使用率超过阈值 |

非堆内存溢出可能导致服务崩溃。 |

80.0% |

|

|

RangerAdmin非堆内存使用率 |

45279 |

RangerAdmin非堆内存使用率超过阈值 |

非堆内存溢出可能导致服务崩溃。 |

80.0% |

|

|

RangerAdmin堆内存使用率 |

45277 |

RangerAdmin堆内存使用率超过阈值 |

堆内存溢出可能导致服务崩溃。 |

95.0% |

|

|

RangerAdmin直接内存使用率 |

45278 |

RangerAdmin直接内存使用率超过阈值 |

直接内存溢出可能导致服务崩溃。 |

80.0% |

|

|

TagSync直接内存使用率 |

45286 |

TagSync直接内存使用率超过阈值 |

直接内存溢出可能导致服务崩溃。 |

80.0% |

|

|

TagSync非堆内存使用率 |

45287 |

TagSync非堆内存使用率超过阈值 |

非堆内存溢出可能导致服务崩溃。 |

80.0% |

|

|

TagSync堆内存使用率 |

45285 |

TagSync堆内存使用率超过阈值 |

堆内存溢出可能导致服务崩溃。 |

95.0% |

|

|

ClickHouse |

ClickHouse服务在ZooKeeper的数量配额使用率 |

45426 |

ClickHouse服务在ZooKeeper的数量配额使用率超过阈值 |

ClickHouse在ZooKeeper的数量配额超过阈值后,无法通过FusionInsight Manager对ClickHouse进行集群操作,无法使用ClickHouse服务功能。 |

90% |

|

ClickHouse服务在ZooKeeper的容量配额使用率 |

45427 |

ClickHouse服务在ZooKeeper的容量配额使用率超过阈值 |

ClickHouse在ZooKeeper的容量配额超过阈值后,无法通过FusionInsight Manager对ClickHouse进行集群操作,无法使用ClickHouse服务功能。 |

90% |

|

|

IoTDB |

合并任务 (空间内合并) 的最大时延 |

45594 |

IoTDBServer空间内合并执行时长超过阈值 |

空间内合并任务超时,会阻塞写数据,影响写操作的性能。 |

300000ms |

|

合并任务 (Flush) 的最大时延 |

45593 |

IoTDBServer Flush执行时长超过阈值 |

Flush任务超时,会阻塞写数据,影响写操作的性能。 |

300000ms |

|

|

合并任务 (跨空间合并) 的最大时延 |

45595 |

IoTDBServer跨空间合并执行时长超过阈值 |

跨空间合并任务超时,会阻塞写数据,影响写操作的性能。 |

300000ms |

|

|

RPC (executeStatement) 的最大时延 |

45592 |

IoTDBServer RPC执行时长超过阈值 |

IoTDBServer进程RPC过高,会影响IoTDBServer进程运行的性能。 |

10000s |

|

|

IoTDBServer垃圾回收(GC)总时间 |

45587 |

IoTDBServer垃圾回收(GC)时间超过阈值 |

IoTDBServer进程的垃圾回收(GC)时间过长,可能影响该IoTDBServer进程正常提供服务。 |

12000ms |

|

|

ConfigNode垃圾回收(GC)总时间 |

45590 |

ConfigNode垃圾回收(GC)时间超过阈值 |

ConfigNode进程的垃圾回收(GC)时间过长,可能影响该ConfigNode进程正常提供服务。 |

12000ms |

|

|

IoTDBServer堆内存使用率 |

45586 |

IoTDBServer堆内存使用率超过阈值 |

IoTDBServer进程堆内存使用率过高,会影响IoTDBServer进程运行的性能,甚至造成内存溢出导致IoTDBServer进程不可用。 |

90% |

|

|

IoTDBServer直接内存使用率 |

45588 |

IoTDBServer直接内存使用率超过阈值 |

直接内存溢出可能导致服务崩溃。 |

90% |

|

|

ConfigNode堆内存使用率 |

45589 |

ConfigNode堆内存使用率超过阈值 |

ConfigNode进程堆内存使用率过高,会影响ConfigNode进程运行的性能,甚至造成内存溢出导致ConfigNode进程不可用。 |

90% |

|

|

ConfigNode直接内存使用率 |

45591 |

ConfigNode直接内存使用率超过阈值 |

直接内存溢出可能导致IoTDB实例不可用。 |

90% |