更新时间:2025-08-14 GMT+08:00

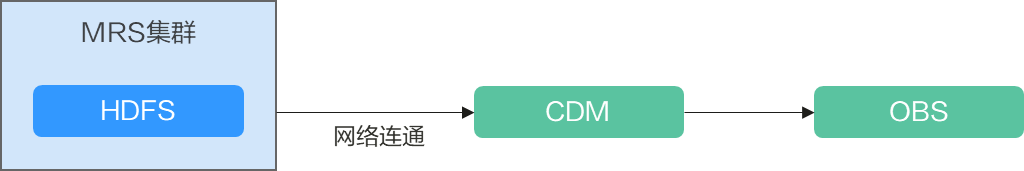

使用CDM服务迁移MRS HDFS数据至OBS

应用场景

云数据迁移(Cloud Data Migration,简称CDM),是一种高效、易用的批量数据迁移服务。 CDM围绕大数据迁移上云和智能数据湖解决方案,提供了简单易用的迁移能力和多种数据源到数据湖的集成能力,降低了客户数据源迁移和集成的复杂性,有效地提高您数据迁移和集成的效率。

MRS支持在大数据存储容量大、计算资源需要弹性扩展的场景下,用户将数据存储在OBS服务中,使用MRS集群仅作数据计算处理的存算分离模式,从而实现按需灵活扩展资源、低成本的海量数据分析方案。

CDM支持文件到文件类数据的迁移,本章节以MRS HDFS至OBS为例,介绍如何通过CDM将文件类数据迁移到OBS文件系统中。

前提条件

- 已获取OBS的访问域名、端口,以及AK、SK信息。

- 已经创建包含有Hadoop服务的MRS集群。

- 拥有EIP配额并创建EIP。

步骤2:创建MRS HDFS连接

- 在CDM集群管理界面,单击集群后的“作业管理”,选择“连接管理 > 新建连接”。

- 连接器类型选择“MRS HDFS”后,单击“下一步”,配置MRS HDFS连接参数。

步骤3:创建OBS连接

- 在CDM集群管理界面,单击集群后的“作业管理”,选择“连接管理 > 新建连接”,连接器类型选择“对象存储服务(OBS)”后,单击“下一步”配置OBS连接参数,如图2所示。

- 名称:用户自定义连接名称,例如“obslink”。

- OBS终端节点、端口:配置为OBS实际的地址信息。

- OBS类型:保持默认。

- 访问标识(AK)、密钥(SK):登录OBS的AK、SK信息。

- 单击“保存”回到连接管理界面。

步骤4:创建迁移作业

- 在CDM集群管理界面,单击集群后的“作业管理”,选择,开始创建从MRS HDFS导出数据到OBS的任务。

图3 创建MRS HDFS到OBS的迁移任务

- 作业名称:用户自定义便于记忆、区分的任务名称。

- 源端作业配置

- 源连接名称:选择步骤2:创建MRS HDFS连接中的“hdfs_link”。

- 源目录或文件:待迁移数据的目录或单个文件路径。

- 文件格式:传输数据时所用的文件格式,这里选择“二进制格式”。不解析文件内容直接传输,不要求文件格式必须为二进制。适用于文件到文件的原样复制。

- 其他可选参数一般情况下保持默认,详细说明请参见配置HDFS源端参数。

- 目的端作业配置

- 目的连接名称:选择步骤3:创建OBS连接中的“obs_link”。

- 桶名:待迁移数据的桶。

- 写入目录:写入数据到OBS服务器的目录。

- 文件格式:迁移文件类数据到文件时,文件格式选择“二进制格式”。

- 高级属性里的可选参数一般情况下保持默认,详细说明请参见配置OBS目的端参数。

- 单击“下一步”进入字段映射界面,CDM会自动匹配源和目的字段。

- 如果字段映射顺序不匹配,可通过拖拽字段调整。

- CDM的表达式已经预置常用字符串、日期、数值等类型的字段内容转换,详细请参见字段转换。

- 单击“下一步”配置任务参数,一般情况下全部保持默认即可。

该步骤用户可以配置如下可选功能:

- 作业失败重试:如果作业执行失败,可选择是否自动重试,这里保持默认值“不重试”。

- 作业分组:选择作业所属的分组,默认分组为“DEFAULT”。在CDM“作业管理”界面,支持作业分组显示、按组批量启动作业、按分组导出作业等操作。

- 是否定时执行:如果需要配置作业定时自动执行,请参见配置定时任务。这里保持默认值“否”。

- 抽取并发数:设置同时执行的抽取任务数。CDM支持多个文件的并发抽取,调大参数有利于提高迁移效率

- 是否写入脏数据:否,文件到文件属于二进制迁移,不存在脏数据。

- 作业运行完是否删除:这里保持默认值“不删除”。根据使用场景,也可配置为“删除”,防止迁移作业堆积。

- 单击“保存并运行”,回到作业管理界面,在作业管理界面可查看作业执行进度和结果。

- 作业执行成功后,单击作业操作列的“历史记录”,可查看该作业的历史执行记录、读取和写入的统计数据。

在历史记录界面单击“日志”,可查看作业的日志信息。

父主题: 数据迁移