更新时间:2024-09-30 GMT+08:00

Spark任务提交失败

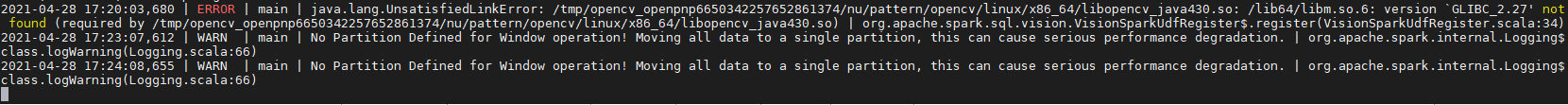

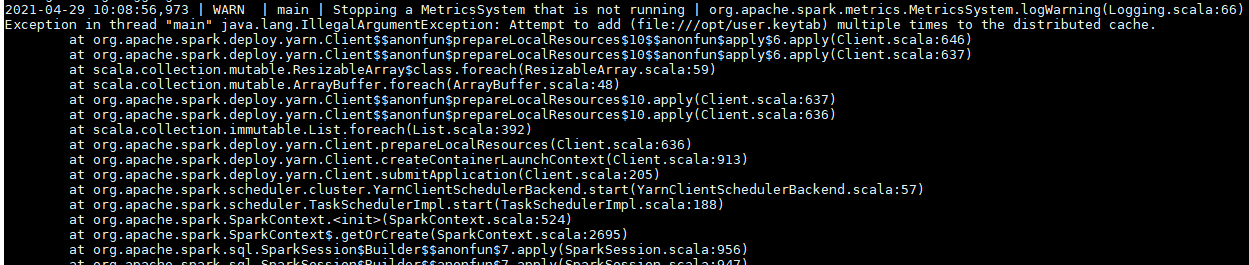

问题现象

- Spark提交任务直接提示无法提交任务。

- Spark提示无法获取到yarn的相关jar包。

- 提示多次提交一个文件。

原因分析

父主题: 使用Spark